Google推出開源TensorBoard網頁應用程式的新功能What-If Tool,讓使用者在不需要撰寫任何程式碼的情況下,檢測機器學習模型,使用視覺化互動介面,探索模型結果。

建構有效的機器學習系統有很多面向需要注意,除了演算法和效能表現外,資料也是一個良好機器學習應用的根本要素,TensorFlow官方早前釋出了TensorFlow資料驗證(TensorFlow Data Validation,TFDV)工具,來幫助開發者進行大規模資料分析與驗證。而Google也提到,機器學習的模型訓練完成後,仍然可能存在許多問題,需要經過反覆的探索調校。

Google認為,一個優秀的開發人員,應該要可以對自己訓練出來的機器模型,回答幾個問題,像是資料的變化會如何影響模型的預測?機器模型對不同的群體有哪些不同的表現?用來測試模型的資料是否足夠多樣化?要回答這些問題並不容易,通常探索機器學習模型必須要編寫一次性的程式碼,來分析特定的模型,但這個過程通常效率很低,而且不會寫程式的人也很難參與其中。

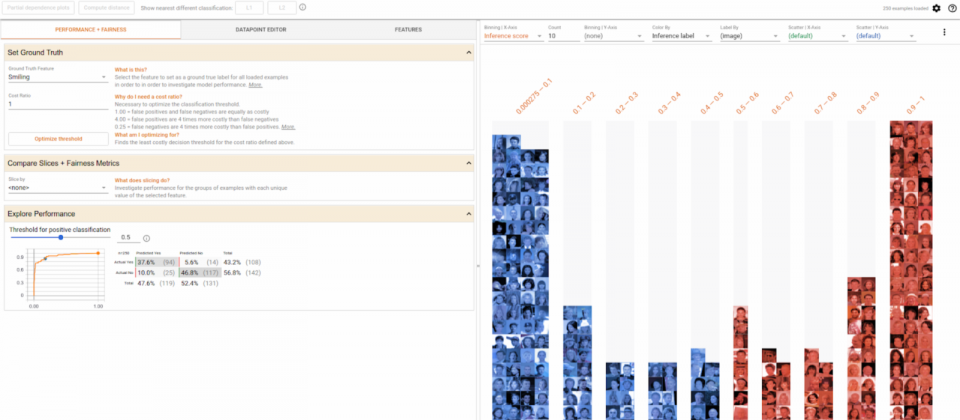

為此,Google在開源的TensorBoard網頁應用程式中,推出了What-If Tool新功能,可以讓使用者在不撰寫任何程式碼的情況下分析模型,只要給What-If Tool一個TensorFlow模型以及資料集的指標,該工具就能提供互動式視覺化介面,讓使用者探索模型結果。What-If Tool包含了豐富的有用功能,除了能使用Facets自動視覺化資料集外,還可以從資料集手動編輯範例以檢視影響變化等。

Google提到,What-If Tool有兩個強大的使用案例,可以用在反事實(Counterfactual)以及效能和演算法公平性分析。反事實是來偵測「如果-那麼」的假設性因果關係,使用者只要在What-If Tool點擊一個按鈕,就能把資料點和模型預測不同結果的最相似資料點進行比較,這能有效地尋找模型決策邊界。而且使用者也可以直接手動編輯資料點,以探索整體模型預測的變化。在效能和演算法公平性分析方面,使用者也可以用What-If Tool探索不同分類閾值對模型的影響,同時考慮不同數值的公平性標準等約束條件。

What-If Tool在Google內部測試的結果,有一個團隊發現他們的機器學習模型,錯誤忽略資料集的整體特徵,還有另一個團隊則使用What-If Tool的視覺化工具,整理模型最佳與最差的範例類型,發現了導致他們模型表現不佳的原因。

熱門新聞

2026-02-11

2026-02-12

2026-02-11

2026-02-10

2026-02-09

2026-02-13

2026-02-10