有鑒於現有的自動評估指標已經不敷使用,儼然成為自然語言生成技術的瓶頸,因此Google新開發了一個用來自動衡量文字產生強健性的指標BLEURT,能達到接近人類註釋的準確性,其準確度比常用的自動指標BLEU還高48%。

過去幾年自然語言生成技術的發展有長足的進步,可以使用越來越高級的方法,精確地翻譯文字、總結文章、進行對話甚至是發表圖片評論,而Google提到,目前評估自然文字產生系統有兩種方法,分別是人工評估以及自動化指標。人工評估是仰賴人工註釋者進行大規模的品質調查,註釋者會檢視系統所產生的文字,並評估其流暢性和含義的品質,這種方法雖然精確,但是卻相當費時,僅數千個範例可能就需要數十人參與評估,這將會破壞模型開發的工作流程。

相較於人工評估,自動評估是更為理想的方法,優點是更便宜且延遲低,自動評估通常以兩個句子作為輸入,一個是候選詞,另一個則是參照詞,評估系統藉由比較兩者相似度給出一個分數,目前常用的衡量標準為BLEU;自動指標與人工評估的優缺點剛好相反,自動指標可以在模型訓練的時候進行計算,回饋強化模型訓練,但是由於其評估僅是表面相似度,因此準確度不高,也無法擷取人類語言的多樣性。

Google認為,理想的評估方法,應該要兼具人工評估和自動指標的優點,計算過程成本應該盡量低廉,且又具有足夠靈活性應對語言多樣性。Google新發展的BLEURT,則是一個運用機器學習技術的自動指標,能夠捕捉句子間語意的相似性。

而訓練BLEURT模型的第一個問題,便是訓練資料數量不足,即便最大的人類評估資料集WMT Metrics Task,新聞領域也只有26萬筆人工評估,而這不足以訓練出進階的自然語言生成系統評估指標,為了解決這個問題,Google採用轉移學習,應用BERT的上下文單詞表示法,這是一種用於語言理解的最新非監督式表示學習法,另外,Google還使用了先進的預訓練方法,以提高BLEURT強健性。

.png)

之所以BLEURT的效能可以這麼好,就是因為使用預訓練技術,Google解釋,在使用人類評估資料微調之前,先使用數百萬個合成句對為模型預熱,研究人員使用維基百科上的句子,應用隨機擾動技術產生訓練資料,由於不使用人工評估,而是使用指標和模型集合,因此能以低成本但極大程度擴大訓練範例的數量。

經實驗證實,預訓練確實提高了BLEURT準確性,而Google對BLEURT進行了兩次預訓練,一次針對語言建模目標,另一次針對一系列自然語言生成評估目標,最後才使用WMT指標資料集進行微調。

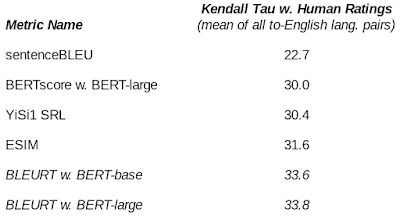

Google對BLEURT進行了基準測試,結果證實BLEURT效能良好,包括在機器翻譯和資料生成文字等任務都超越現有的方法,比應用WMT Metrics Shared Task的BLEU,人工評估分數還要高48%。

熱門新聞

2026-02-09

2026-02-10

2026-02-06

2026-02-09

2026-02-10

2026-02-10

2026-02-10

2026-02-09