Meta

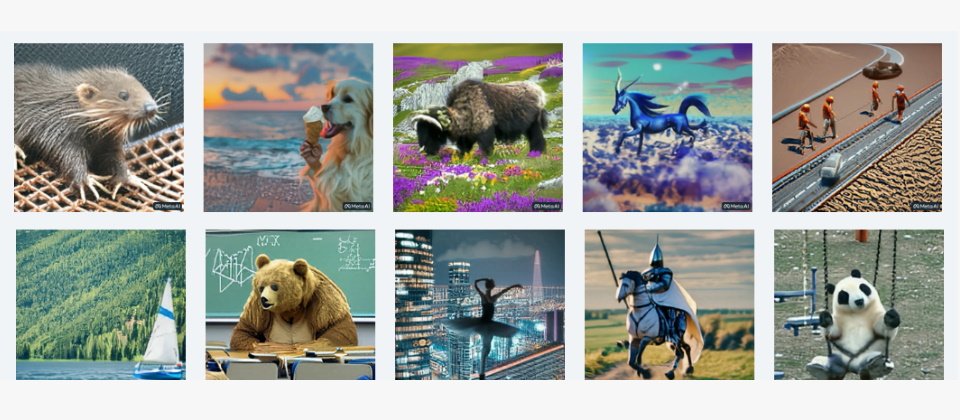

Meta昨(29)日公布名為Make-A-Video的AI工具,能利用文字或靜態圖片產生短影片,並公開給社群試用。

Make-A-Video類似OpenAI的DALL-E和Stable Diffusion,能將輸入的文字以AI模型產生成圖像。Meta 表示,是以Meta AI部門生成性AI(generative)技術為基礎發展而成,利用文字搭配圖片,以及不加入相關文字及標註的影片片段為資料加以訓練。Meta表示,這項工具可讓用戶發揮想像力,只要幾行字即可生成各種天馬行空、獨一無二的短影片。

這項服務是Meta繼今年7月的Make-A-Scene後最新生成性AI研發成果。Make-A-Scene透過提示,即可利用使用者輸入的文字和簡單草圖,來生成一幅高品質的場景圖。

圖片來源/Meta

根據Meta的示範網站,Make-a-Video有多項能力。在基礎層次上,它可以利用一行文字如「泰迪熊作畫」或「機器人在時代廣場跳舞」生成數秒短影片,現提供超現實、寫實或風格化三種類型。它也能將單一張圖轉成動畫,或是將二張圖接合成連續性影片,例如把看似差異不小的地貌圖接合成地形變動的影片。此外Make-a-Video還能以輸入一則影片的素材生成4種變化,例如讓跳舞的熊多出好幾種舞步。

圖片來源/Meta

Meta強調Make-a-Video和之前技術相比,再現文字意境的能力提高3倍,畫質也改善了3倍。

Meta也將Make-a-Video 的相關技術資源,公開於GitHub供研究社群試用。

圖片來源/GitHub

為了減少AI模型產生有害內容,Meta強調會在Make-a-Video反覆檢視並使用篩選器,而且由於產生的影片相當逼真,Make-a-Video所有產生的影片都會加上浮水印以供讀者辨識。Meta同時強調會在Make-a-Video推向所有使用者之前,持續分析、測試,確保每個環節的安全及適當。

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-10

2026-02-06

2026-02-10