Meta首席人工智慧科學家Yann LeCun提出了一種新的人工智慧模型架構,能夠克服當今人工智慧系統的限制,獲得更好的效能。而現在Meta揭露了使用這個新架構所開發的電腦視覺模型I-JEPA(Image Joint Embedding Predictive Architecture),其特色在於能夠關注真正的圖像重點,並以更少的GPU訓練時間獲得更好的模型效能。

I-JEPA在多項電腦視覺任務表現,較當前廣泛使用的電腦模型高上不少,而且計算效率也更好,I-JEPA模型所學習的資料表示(Representation),也可以在不需要大量微調的情況下,用在許多不同的應用程式。在機器學習中,表示指得是輸入資料被轉化成機器可以理解和處理的形式,也就是所捕捉到原始資料的特徵和模式。

基於I-JEPA架構,研究人員使用16個A100 GPU,以72小時訓練了一個6.32億參數的視覺Transformer模型,在ImageNet資料集中的少樣本分類任務效能表現,超越當前所有模型。研究人員提到,其他方法通常需要2到10倍的GPU訓練時間,而且在使用相同資料訓練時,錯誤率通常會高得多。

而I-JEPA高效能的秘密,就在其能夠以更像人類理解抽象表示的方式,來預測缺失的資訊。一般生成式模型的預測發生在像素空間,而I-JEPA則是使用抽象的預測目標,而這也潛在地消除了像素空間中不必要的細節,進而使模型學習更多語義特徵。

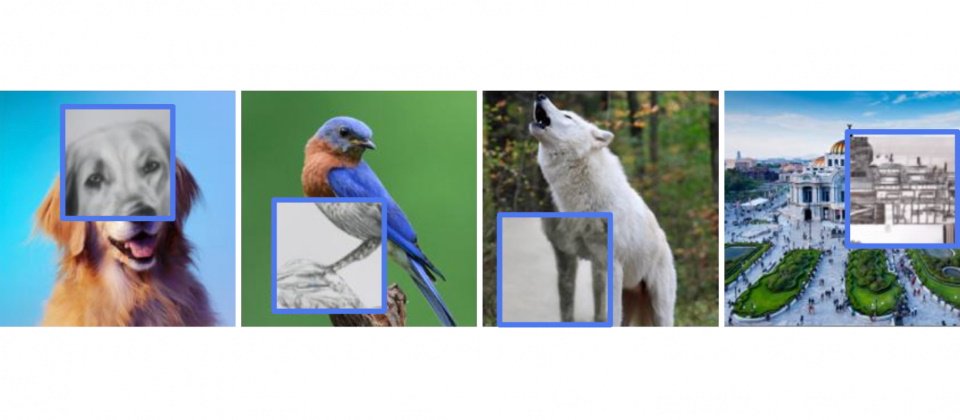

另一個I-JEPA重要設計,是使用一種稱為多區塊遮蔽策略(Multi-Block Masking Strategy)。I-JEPA在處理圖像複雜輸入時,不只是關注一小部分,而是放眼更大的範圍,以便理解和學習更多的語義資訊,也就是說,多區塊遮蔽策略的重要性,在於預測包含語義資訊的大塊區域,而且這些區域的範圍要足夠大,才能有足夠豐富的上下文來進行預測。

I-JEPA以高層次預測表示而非直接預測像素值,能夠學習有用的表示,避開生成式方法的侷限。研究人員指出,生成式方法透過刪除和扭曲模型輸入的部分內容來進行學習,像是抹除照片的一部分,或是隱藏文字段落中的某些單字,接著要求模型嘗試預測丟失的像素和單字,來達成訓練目的。

但這也造成生成式方法一個明顯的缺點,生成式模型會嘗試填補每一個缺失的資訊,即便是現實世界的本質並不可預測。由於生成式方法過於關注不重要的細節,導致容易出現人類永遠不可能犯的錯誤,例如在生成人手的時候,可能出現不同數量的手指,或是其他明顯的錯誤。

I-JEPA預訓練非常高效,而且不需要使用複雜的資料增強方法,經過實驗證實,I-JEPA能夠學習出強大的語義表示,在ImageNet-1K的線性探索和半監督評估上,超越了像素和權杖重建(Token-Reconstruction)方法,且與仰賴人工資料增強的方法相比,I-JEPA在低階的視覺任務,像是物體計數和深度預測上表現得更好。I-JEPA架構的模型更簡單,也更能夠適應廣泛的任務。

熱門新聞

2026-02-11

2026-02-09

2026-02-11

2026-02-10

2026-02-10

2026-02-06

2026-02-10

2026-02-10