OpenAI

在微軟、Google、Meta之後,OpenAI也搭上小語言模型列車,推出多模態AI模型GPT-4o mini,強調低成本,且比Claude Haiku、Gemini 1.5 Flash其他小模型理解能力更高,目前可支援文字和視覺,未來還會再加入影片與聲音支援。

OpenAI指出,GPT-4o mini是該公司最具成本效益的小模型,低成本及低延遲性等優點,預期它可擴大AI應用廣度和使用普及。OpenAI並未公布GPT-4o mini的參數量。該公司對Techcrunch表示,其參數量和主要小模型如Llama 3.8B、Claude Haiku和Gemini 1.5 Flash差不多。

目前已知,GPT-4o具備128K字符的context window,一次呼叫支援最多16K輸出字符,其訓練資料集已更新到2023年10月。由於與GPT-4o使用同樣的tokenizer,這小模型處理非英文文字的成本效益會再更提升。

雖然號稱多模態支援,但目前GPT-4o mini僅在API支援文字和視覺,未來才會加入多模態能力,支援文字、圖片、影音輸入/輸出功能。GPT-4o mini現在可透過Assistants API、Chat Completions API及Batch API提供文字和視覺模型。收費方面,每100萬(大約是一本2,500頁的書)輸入字符費用為15美分,每100萬輸出字符為60美分。OpenAI計畫未來幾天內,就會推出GPT-4o mini微調功能。

ChatGPT免費版、Plus、Team方案用戶今天起可存取GPT-4o mini,取代GPT-3.5。下周Enterprise方案用戶也可開始存取。

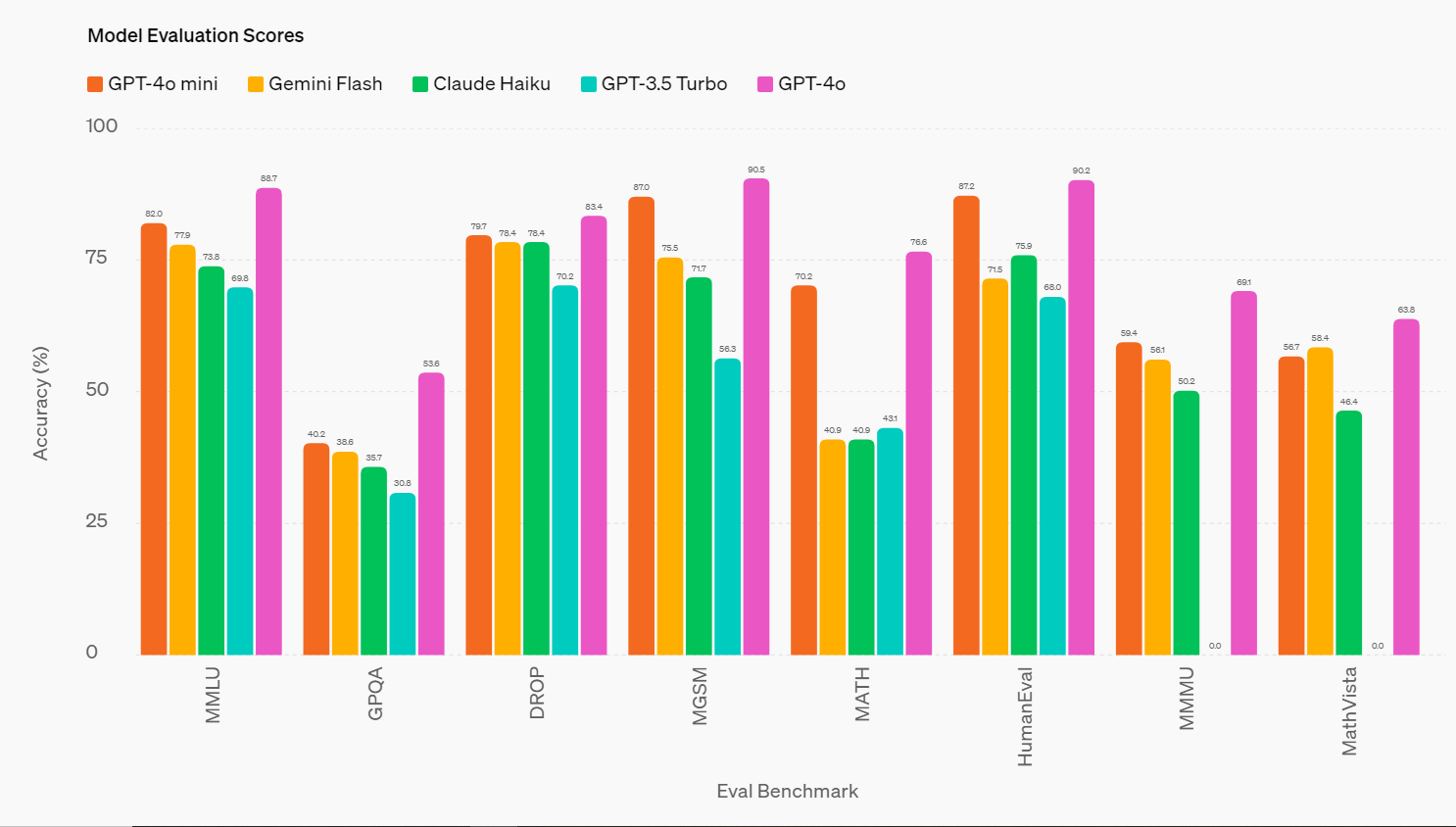

現有能力上,GPT-4o mini在文字智慧及多模態理解能力,已超越GPT-3.5 Turbo及其他小模型。例如在文字與視覺理解任務上,GPT-4o mini在MMLU測試中得分82.0%,超過Gemini Flash的77.9%和Claude Haiku的73.8%。在數學與程式任務上,它在MGSM測試中拿到87.0%,在寫程式效能的HumanEval測試中拿到87.2%,都超越Gemini Flash(75.5%/71.5%)及Claude Haiku(71.7%/75.9%)。此外,在多模態理解的MMMU測試中,GPT-4o mini也以59.4%擊敗對手(Gemini Flash 56.1%;Claude Haiku 50.2%)。

圖片來源/OpenAI

GPT-4o mini也展現強大的函式呼叫能力,能協助開發人員建立撈資料,和外部系統串聯以採取行動的應用程式,其長脈絡效能也優於GPT-3.5 Turbo。OpenAI舉例,這小模型能支援串聯或平行執行多個模型呼叫動作(如呼叫多個API)、將大量脈絡資訊傳送給模型(如完整的code base或對話紀錄),或是以快速、即時回應(如客戶支援聊天機器人)和客戶互動。

目前OpenAI已和第三方應用開發商合作測試GPT-4o mini,包括帳單管理App Ramp及智慧化電子郵件App Superhuman等。

OpenAI也不忘強調為GPT-4o mini加入的安全防護。包括從預訓練的資料去除仇恨、暴力、成人內容,以及個資。後訓練中則以強化式學習搭配人員回饋提升模型回應的可信度與準確性。這模型也具備和GPT-4o同樣的安全機制,也找來了專家團隊測試。

OpenAI說,和2022年的text-davinci-003相較,每字符(token)成本已經降低99%,該公司也致力於未來持續降低成本同時提升模型能力。

熱門新聞

2026-02-06

2026-02-06

2026-02-06

2026-02-06

2026-02-09

2026-02-09