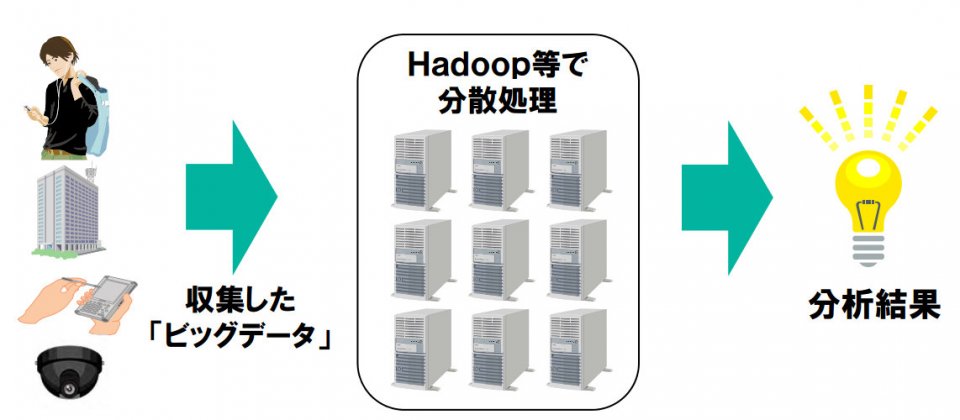

日本NEC週二(10/8)發表巨量資料高速分析技術,可解決目前普遍利用Hadoop開放源碼平臺分析巨量資料時,所需耗費時間較長的問題,宣稱處理速度約可提升10倍。

用Hadoop平臺分析巨量資料時,一般規模的資料量至少要花一週以上的時間才能得到最終分析結果,導致企業無法立刻進行各項決策,例如利用消費者購物習慣決定商品定價、預估商品需求等,如此等於損失了當下可能產生的商機。

Hadoop是一種透過機械學習方式來分析巨量資料的平臺,因此十分仰賴重複演算與矩陣演算。重複演算方面,NEC把過去利用MapReduce分散運算資料時必須經由硬碟的方式,改由記憶體來處理,就能提升重複演算的效率。另外,使用矩陣演算法就必須組合許多個MapReduce,運算資料時與伺服器之間的通訊就變得很沒效率,所以改由另一種分散運算法--訊息傳遞介面(MPI,Message Passing Interface)來取代。透過整合運用以上兩種方式,Hadoop平臺處理速度可提升為目前的10倍以上,原本分析需費時一週的巨量資料,套用此技術後不到一天就能完成。

由於Hadoop平臺在伺服器故障時,仍可透過輸入至硬碟的資料繼續處理在故障伺服器上執行的運算分析工作,穩定性很高,但改用高速化新技術後,MapReduce輸入的資料就改輸入至記憶體上,這代表伺服器一旦故障,資料就會消失,因此NEC研發了能定時將記憶體上的資料運算狀態高速轉存到硬碟的技術。

以往若要保存資料運算狀態,就必須將程式使用到的所有記憶體內容一起保存,但這個高速轉存技術可以只選擇繼續處理資料時所需用到的部分,大幅減少保存的資料容量,並保有高速保存的特性。運用本技術定時將資料運算狀態轉存到硬碟,伺服器故障時就能將保存在硬碟的資料運算狀態交由記憶體讀取繼續處理。

本次研究成果已於10/8在美國加州舉辦的國際學會IEEE International Conference on Big Data 2013中展出。(編譯/張嵐霆)

熱門新聞

2026-02-06

2026-02-06

2026-02-06

2026-02-06

2026-02-09

2026-02-09

2026-02-06