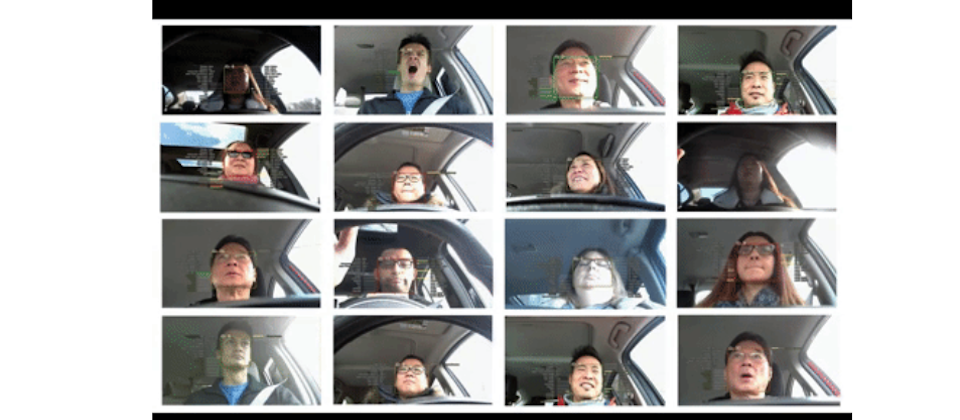

圖片來源:

Affectiva

由麻省理工學院多媒體實驗室成員創立的一家,專注於分析人類情感的AI新創Affectiva,最近推出偵測駕駛人情緒的服務,透過鏡頭拍攝分析駕駛人開車時的臉部表情與聲音,判斷駕駛人的情緒、精神狀況和分心程度,若系統判定駕駛人不適合開車,可以轉為自動駕駛模式。

Affectiva與汽車設備製造商合作,並結合傳統的RGB鏡頭和近紅外線鏡頭,偵測駕駛人每分鐘眨眼的次數、臉部表情,透過深度神經網路擷取臉部特徵,經由預先建立的評分機制,辨識疲勞、打呵欠等狀況的AI模型,來判斷駕駛人適不適合開車。

Affectiva的AI模型中,包含臉部情緒、表情、嗜睡評估標準、頭部姿勢、聲音情緒等特徵,臉部情緒分為開心、憤怒和驚訝3種,表情則有微笑、眼睛放大、眉毛上升等,嗜睡評估標準包括閉眼、打呵欠、眨眼和眨眼頻率。(來源:Affectiva)

為了能夠打造更準確的演算法,Affectiva目前已在87個不同的國家中,收集了650萬名駕駛人的開車臉部影像,來訓練辨識模型,讓模型學習如何從臉部表情與聲音,判斷情緒。

Affectiva認為,這項服務將可以監控駕駛人的疲勞和分心程度,並適時提出預警,若駕駛人處於憤怒的情緒,系統會建議沿途先停止駕駛,甚至,虛擬助手可以播放使情緒放鬆的音樂,而若駕駛人處於疲勞狀態,也可以轉換為自動駕駛,減少事故發生。

熱門新聞

2026-02-11

2026-02-11

2026-02-12

2026-02-09

2026-02-10

2026-02-10

2026-02-06

Advertisement