臺灣人工智慧學校第一期結業典禮暨成果展示,內容多樣,涵蓋股市預測、房價預測、疾病預測、植物影品種辨識,以及影像敘述自動生成。

攝影/王若樸

臺灣人工智慧學校第一期於4月28日結業,當天除了結業典禮外,還包括了技術領域班這三個月以來的學習成果發表。各組別出心裁,有將AI運用到便民服務的,比如預測未來四周的腸病毒疫情局勢,和自動生成腸病毒周報的速訊寫稿機器人,給民眾和專業人士閱讀。另外一些學員也發揮創意,將AI用於不同領域,像是臺股中短期預測、結合地理環境資訊來進行房價預測,以及用影像識別來辨識植物品種(如艷紫荊、洋紫荊和羊蹄甲),另外還有精準度高的影像敘述自動生成系統(Image Caption)。

首先展示的主題,是對未來四周腸病毒感染趨勢的預測。有鑑於腸病毒對於家中有小孩的父母、學校老師和醫生都影響重大,這組組員就想建立一個可以準確預測腸病毒未來四週趨勢的模型,來服務大眾。他們運用了疾病管制署的資料,取用了臺北市的腸病毒急診與門診資料加總來分析,將2008年至2016年的腸病毒急、門診資料當作訓練資料集,並以2017年的腸病毒急、門診資料作為測試集,來檢測預測模型的準確度。該組分別以XGBoost模型和LSTM模型,針對四周做出4種相對應的模型來訓練、預測。在沒有加入任何特徵之前,第一周的兩個模型預測結果都十分準確,但第二、三、四周就有所差異,LSTM模型也有所偏移。因此組員回顧疾病管制署資料,把感染人次、氣候溫度、人口數、空汙資料和是否放假等7種特徵,加到訓練模型中。測試結果顯示,第一周表現依然良好,第二、三、四周的XGBoost模型也有改善,LSTM模型也修正了偏移現象。

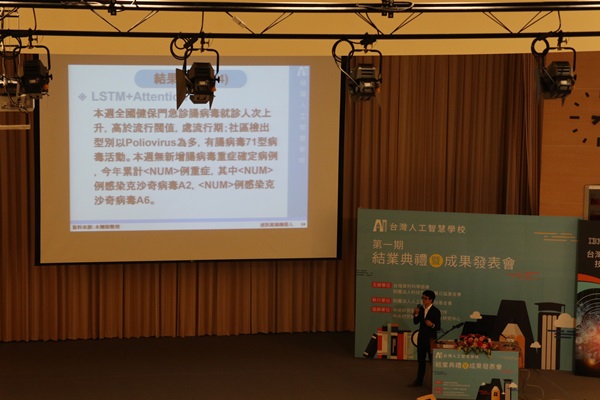

另一個與腸病毒相關的主題,則是自動寫出腸病毒疫情周報的速訊寫稿機器人。腸病毒疫情周報由疾管署提供,範圍涵蓋了國內外疫情摘要、社區病毒監測、重症監測和停課監測等,內有各式圖表和統計圖,公開給專業人士和一般大眾閱讀。由於腸病毒每年都會發生,這組組員希望能透過文章自動生成的速訊寫稿機器人,將腸病毒資訊更快地傳播出去。為此,他們使用了疾病管制署的腸病毒疫情周報資料(自2010年至今,共209篇),以及腸病毒社區檢驗、監測摘要、門診資料等共8個cvs檔案,來訓練可自動撰寫腸病毒周報和數值的系統。也由於他們希望機器寫的文章,讀起來要像人寫的一樣自然,因此在評估方法方面,他們就透過人工檢驗、與過去周報比較,並且修正。而用來訓練的模型,則為混合型,包含了Char-RNN、LSTM加上Attention機制,以及法則式模型(Rule-based model),將文章中的每一段用一個模型來訓練。組員說,雖然系統最終產生的文章,數值沒辦法擺在正確位置,而且需要人工審核,但疾管署人員看了之後,表示他們只需要30秒到1分鐘來審核,其實已經節省不少時間。

除了將AI用在與臺灣息息相關的腸病毒防治,這次成果發表還有其他有趣的應用,像是臺股中短期走勢的預測。這組學員運用了2006年至2015年的臺股資料、訓練出一個長短期記憶神經網絡(LSTM)模型,來預測2015年到2016年的臺股盤勢。該預測模型由6個LSTM網路堆疊而成,小組成員也做了幾項預處理(像是修正標籤等),加入技術面、基本面和籌碼面等共450項特徵(feature),使模型的預測更加精準。

另一項應用,則是以地理環境資料來預測房價。組員從過去房屋成交的案件中,撇開房屋本身條件(比如坪數、屋齡、設備等),來尋找、歸納出影響房價的地理空間因子,像是生活便利程度(便利商店的有無、數量和距離等),以及房屋所在的位置(是否為精華區、重劃區,或是與交通設施站的距離等)。而他們所使用的資料,主要由成功大學測量及空間資訊學系提供。取得房屋交易資料後,組員先將房屋門牌號碼進行座標定位,再來觀察地理空間因素,排除一些不相關因素如親屬間交易後,取3萬筆資料作為訓練素材。在特徵選取方面,則包含行政區、便利商店、學區等,加進演算法中,來預測房價。不過,由於當天介紹時間有限,有些重點還沒有機會完整揭露。

AI不只運用在預測上,其中一組組員自行發想,將AI應用來辨識植物,也就是植物品種:艷紫荊、洋紫荊和羊蹄甲的辨識。他們希望透過這項辨識技術,讓對植物有興趣的民眾,帶著手機就可以認識大自然。在辨識方面,這組組員表示,雖然花相似度低、是最容易辨識的主體,但由於艷紫荊、洋紫荊和羊蹄甲並非全年開花,所以組員還是以這三種植物的葉子作為辨識主體。為了蒐集資料,他們親自到臺灣各地取樣拍照。當中也遇到了些困難,像是嫁接的植物、上下部為不同品種;而4月正好是羊蹄甲花季,所以拍照取樣時,背景有花,而洋紫荊正好非花季,這樣的差異,就會影響模型辨識率,模型會認為有花的是羊蹄甲,而為了讓模型把重點放在葉子上,資料集因此設為兩個部分,第一是Public Set(Pure)純葉子辨識,準確率可達95%,另一個是Private Set (Noise),準確率為85%。另外,組員表示,該辨識技術已經上線,民眾可以網路版和App版使用。該組也將繼續擴大辨識物種,讓植物識別的品種更豐富。

另外一個登場的是,影像敘述自動生成。這項技術,除了使用痞客邦提供的資料,也運用了COCO資料集的8萬多筆照片資料,另外還包括組員提供的大量生活照等。而用來訓練的模型,則是Show, Attend and Tell。組員表示,Attend加強了系統識別的能力,比如顏色識別(Color Attend);在現場示範中,一張影像如果拿掉Color Attend,對影像的顏色敘述就消失了。而在使用部分,使用者只要將照片上傳到http://104.199.193.55/galleries,系統就會自動生成影像文字敘述。這組組員也當場對著大家照了張相,上傳後自動產生的文字敘述為「一群人在國際會議廳的觀眾席上」(如下圖),高準確度也贏得大家掌聲。

除了這些,成果發表也還有其他應用,像是3D細胞語義分割、臺灣動物聲音辨識、新聞標題產生器、文章自動標籤生成、人與物的互動辨識,以及AOI瑕疵檢測和影像多元瑕疵檢測等。

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-12

2026-02-10

2026-02-06