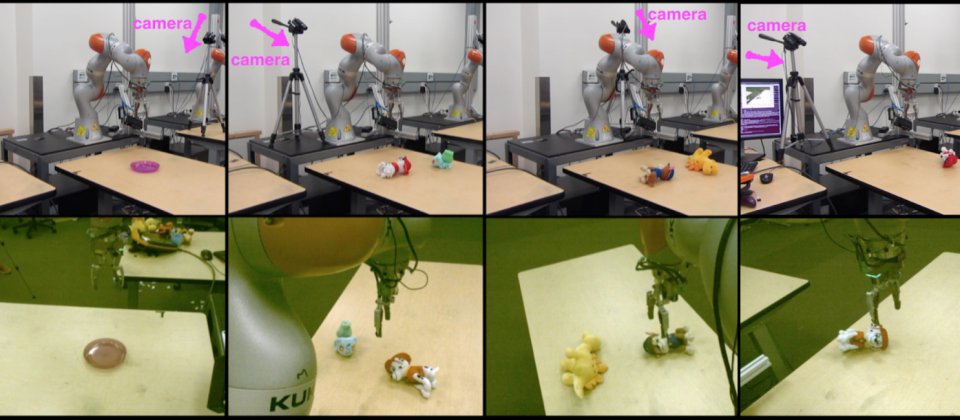

上排為攝影機安排在機械手臂不同的位置,下排為不同角度攝影機輸入手臂的視覺影像。

Google發表了一項新研究,讓機器人手臂不再需要人為設定固定的軌跡與姿勢,而能自己從過去歷史經驗中學習,並透過觀察環境自我校準後,從不同的視角抓取物體。Google使用了全新的深度網路架構,結合兩個完全卷積網路以及一個短期記憶單元,讓機器人能夠在視覺上達到自我適應。

之所以人類可以從不同視角不同姿勢操作物體,是因為從童年就透過操作各種物體學習,不斷自我調整並使用豐富的感官線索以及視覺作為錯誤修正的反饋,訓練出優秀的視覺動作整合能力。而Google這個研究目的,便是要賦予機器人同樣的能力,因為現行視覺控制機器人的物體操作能力,通常需要大量的人類介入,而且輸入影像資料只能來自於固定的攝影機視角,但Google認為,讓機器人擁有跟人類相似的視覺動作整合能力,將大幅提升機器人的實質功能,像是在緊急情況或是災難現場進行救援。

要從未知視角的單一影像中,探索可控自由角度如何影響視覺動作,可能是一個模糊且範圍廣泛的問題,Google嘗試進一步縮小問題,要識別在影像空間動作的行動影響,並成功執行被要求的任務,需要一個以過去動作記憶增強的感知系統。研究團隊設計了一個具備7個自由度的機器人手臂,要讓機器人以一張物體的圖像,從一個完全不一樣的視角,在一群物體中抓取圖像中的物體。

Google提到,要收集機器人資料非常的困難且耗費時日,尤其這項訓練資料還需要模擬複雜行為,因此Google決定使用模擬資料增加資料的多樣性,模擬資料不只能夠收集無限的機器人試驗,而且還能隨意的變換攝影鏡頭,當然他們也透過在機器人手臂周圍安裝多個攝影鏡頭,提供現實的訓練資料。而且為了讓機器人在未知的環境仍然擁有強健的視覺功能,他們採用領域隨機化技術,讓機器人在虛擬世界受訓練,並將經驗應用在現實世界中。

為了加強在未知環境中的應用,Google特別設計了一個深度神經網路,結合感知和控制訓練進行端對端的模擬,但同時在需要時也允許獨立學習,透過解構控制與感知,使機器人更能適應未知環境,由於兩部分都能獨立適用環境的小量資料,這樣的設計讓模型更加有效也更具彈性。

在這項研究的早期結果中顯示,機器人手臂無論從各個角度,都可以抓取到視覺指引的物體,而另外的實驗是在桌面上擺放兩個物體以混淆機器人,要求機器人同樣要從各種角度抓取指定物體,Google提到,雖然模擬網路具有良好的泛化能力,但由於網路的靈活架構,只有少量的靜態可視覺化資料能夠視覺化適用於控制器,進而提升了整體效能,即使在多樣環境仍有良好的自我適應能力。

熱門新聞

2026-02-06

2026-02-06

2026-02-06

2026-02-06

2026-02-09

2026-02-09