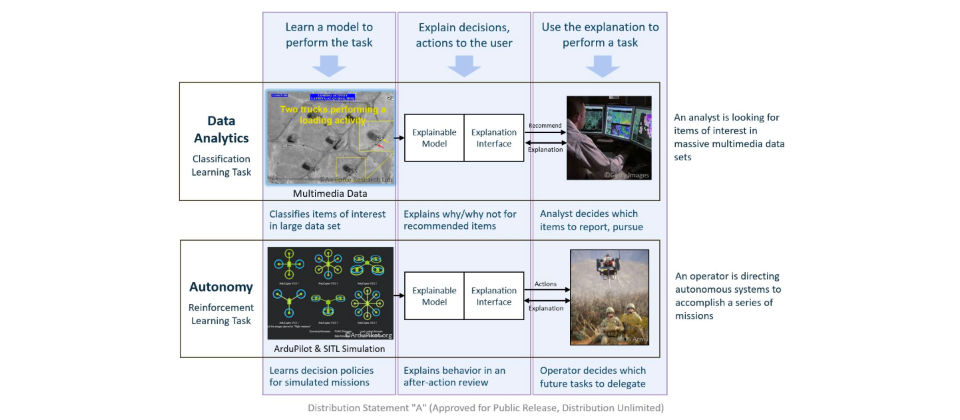

想要打造出可解釋AI並非易事,美國國防部旗下DARPA發起的 AI研究計畫XIA,也提出了兩大挑戰領域,第一個是資料分析中分類訓練(Classification Learning)挑戰,而第二個挑戰領域是自主性(Autonomy)難題,這也是增強式學習(Reinforcement Learning)的課題。(圖片來源_DARPA)

美國國防部旗下DARPA早在2016年8月提出的Explainable Artificial Intelligence(XAI)研究補助計畫中,就詳細地整理出可解釋AI的需求和發展方向。尤其列出了5個,人們對AI黑盒子的提問,包括了為何AI決定這麼做?為何不那麼做?為何可以成功?為何會失敗?為何人們可以信任AI?人們該如何修正錯誤?這些問題,也正點出了可解釋AI科技要解決的挑戰。

美國國防部發起可解釋AI研究補助計畫,來吸引產學界投入

XAI計畫書中指出,現有AI應用模式是,先蒐集訓練資料,再建立機器學習流程之後,就可以訓練出所需功能的模型來執行推論工作,對使用者提出的任務(需求),來提供推薦或決策資訊,但卻無法說明上述5項問題的內容。而XIA計畫提出的可解釋AI模式,一來要尋求新的機器學習流程,並且要建立可解釋模型和可解釋介面,讓使用者可以得到心理層面上的了解。

進一步從XIA對研究成果的衡量指標,更可一窺美國國防部期待XIA可解釋模型要實現的效果,包括了使用者滿意程度、心智模型成效(如個人可以理解、整體模式可理解、可預期會做什麼、可預期如何介入),任務成效(如提高決策或任務的成效,或是輔助人的理解),未來是否可用或可信任,以及修正能力(錯誤辨識、自動修正,以及能用於持續訓練)。

實現可解釋AI有兩大挑戰

不過,想要打造出可解釋AI,不是一件容易的事。XIA計畫就提出了兩大挑戰領域,第一個是資料分析中的分類訓練(Classification Learning)挑戰,尤其要針對人類興趣來分類各種異質的多媒體資料,如何解釋AI為何推薦或不推薦這些內容,讓人們可以使用這些解釋來完成任務,是第一類可解釋性難題。

第二個挑戰領域是自主性(Autonomy)難題,這是增強式學習(Reinforcement Learning)的挑戰,如何在一個模擬的自主性系統(如VR虛擬世界)中,來建立決策政策,是機器學習的第二類難題。例如在模擬世界中訓練自動駕駛系統時,如何能夠提供AI決策的解釋,以供事後分析,讓人們得以了解。XIA計畫目標是能在2021年時提出可解釋AI的模式、工具和相關軟體。

科技業界紛紛投入可解釋性AI研發

產業上的需求,再加上美國政府力推,也帶動了可解釋AI的相關研究。例如華盛頓大學3位研究人員就提出了一套LIME(Local Interpretable Model-agnostic Explanations)框架,在訓練出DNN模型後,再針對一筆訓練資料(一張圖或一句話)中的局部資料進行干擾,來觀察是否會影響預測結果,而來判斷訓練資料中的那個部分對預測結果,具有更關鍵的作用,例如就可以判斷出,一張狗彈吉他照片,狗臉是辨識出動物物種的關鍵區域。這個作法也引起不少業界關注,例如Teradata技術長也特別看重LIME的應用。

或像今年3月時,打造出AlphaGo的DeepMind公司也發表了可解釋AI的作法,利用神經元刪除法(Neuron deletion),來了解深度學習的運作過程。不同於LIME是從訓練資料來尋找解釋力的作法,神經元刪除法則是從訓練後的神經網路模式來尋找解釋力。由於在深度神經網絡模型中,利用大量神經元來訓練模型,DeepMind團隊透過刪除獨立的特定神經元,或在隱藏層中的神經元,來觀察對模型預測力的影響。不過,DeepMind發現,那些可解釋的獨立神經元,對模型的效力不如那些「不可解釋」的神經元,其次,越有能力分辨未知圖片的神經網絡模型,越不受刪除神經元的影響。儘管,DeepMind這個方法還無法找出更有解釋力的新方法,但已經可以對神經網絡的運作,有更多的了解。

沈向洋指出,大多數神經網絡分析技術,只處理關連關係,而非因果關係,才會難以得到解釋。

不過,想要建立可解釋性,沈向洋認為,短期發展上,不外乎有兩種作法。第一是DNN訓練完成後,採取縮減規模的作法,例如減少中間處理的隱藏層,來比對出哪些是影響解釋力的關鍵。

例如康乃爾大學兩位研究者就曾在2013年發表了一篇卷積神經網路視覺化的論文《Visualizing and Understanding Convolutional Networks》,這是CNN模型視覺化的開始,試圖透過反向推算,來找出每一層如何所辨識的圖片特徵,來說明CNN模型的辨識原因。

不過沈向洋認為,這種作法容易用於視覺辨識,因為可由人眼來驗證,但對於語音辨識或自然語言理解就不容易實作。而第二種作法,他直接建議,可以利用更基礎的方法,如大數據或統計方法就夠,來建立預測模型,而不需使用到DNN。

而在長期作法上,沈向洋認為,還是得回到因果關係的處理。例如微軟正從張量空間著手(Tensor Space),試圖要建立一個數學模型,來串連符號AI和神經網絡兩種AI技術,希望能做到兼顧DNN的優勢,又能提供可解釋的能力。

因果關係研究是AI未來課題

沈向洋強調,今天AI成功的關鍵是,利用「大數據解小問題」,例如AlphaGo的圍棋對奕,但這不易類推,而人的智慧則善於靠「小數據解大問題」,透過蛛絲馬跡,從因果關係來歸納、推論出一般性(Generalization),這是AI未來應該研究的課題。目前AI連對世界的理解,認知理解的發展,都還在非常初期的階段,所以,「我不擔心,在有生之年,AI會統治人類。」他笑說。

不論是DNN或是可解釋性AI,他指出,都只是聚焦在感知型AI技術,能夠處理因果關係,就會進入認知型AI的領域。儘管,因果關係的AI研究,還有很長一段路要走。但他認為,DNN真的有用,甚至未來會變成一種工具,成開發工具的功能之一,5年、10年後,人們想要使用DNN將會非常易。

不過,今天的AI技術已經非常強大,而且隨著資料越多、運算晶片的能力越強,更多新算法的出現,他認為,DNN這類AI技術對社會和政治的影響,已經非常嚴重了,尤其在社交平臺、搜尋引擎上。

也因此,沈向洋提醒,不論是AI設計者,或使用AI的人都需要開始重視AI倫理議題。「倫理就是克制,儘管能做,但不代表應該去做(Just because we can do it ,doesn’t mean we should do it)」他說,AI對人類的影響,不知不覺地,已經遠遠超越了核子武器,因為這是更深入你的大腦,深入心理的技術。「AI會不斷前進,人們需要克制的能力。」

DNN這類AI技術對社會和政治的影響,已經非常嚴重了,AI設計者與使用者都需要重視AI倫理議題。「倫理就是克制,儘管能做,但不代表應該去做(Just because we can do it ,doesn’t mean we should do it)」──微軟AI及研究事業部負責人沈向洋

AI輔助開發,靠嘴巴寫程式未來也能成真

因為DNN的出現,現在也開始出現了專為AI或大數據分析而設計的開發語言,如剛於8月8日發布了1.0版本的程式語言Julia,除了要具備像C語言一樣的執行速度外,還要如同資料科學愛用的Python語言那樣,成為一個一般可用性的語言,也設計成像Matlab般支援線性代數演算法,在字串處理能力上更以Perl為目標。

不過,微軟AI及研究事業部負責人沈向洋指出:「機器所用的語言和人類所用的語言有很大的差異。」人類所用的語言,和機器需要的語言,截然不同。機器語言得盡可能地準確,才能按照開發者的意思來執行,尤其要排除不確定性。「人類語言是故意設計成不精確的形式,」

沈向洋解釋,故意要讓話語留有餘地,讓對方解釋。同一句話,講給太太或同事,感受到的意義會有很大不同。「這是人類語言的一項功能,不是錯誤 (Bug),因為句子真正的意義,是取決於讀的人,聽的人,而非只有說的人決定。」

不過,「懂語言者,得天下,能夠深度理解語言,才是關鍵」沈向洋解釋,語言是人類非常重要的發明,語言讓人們可以建立組織,散播思想,人類之所以延續至今,就靠語言組織起來,才能打敗其他物種。而「我認為,AI目前最重要的進展是對語言的理解,AI可以幫助我們對現有語言有更好的了解。」他強調。

像Julia這套開發語言,微軟也正在評估是否要支援,因為這個語言可以比較方便地描述AI所要做的工作,也能提供更有效率的程式碼,「對用戶來說,相對容易理解。」 他解釋,也因此,不只MIT力推,微軟也正在評估是否要支援。

不只有AI專用開發語言,在開發工具上,沈向洋表示,AI越來越容易輔助程式轉寫,可以推薦參考程式碼,協助除錯,甚至可以建議開發者如何優化,微軟也會將AI引進開發工具中。

「關鍵是得有資料,過去Visual Studio的使用已累積了不少開發資料,未來還可以藉助GitHub這個全世界最大的開發知識庫。」

沈向洋更預言,未來甚至有可能,開發人員只要對著數位助理說出想要的功能,數位助理就能自動幫你寫出程式。

熱門新聞

2026-02-11

2026-02-09

2026-02-11

2026-02-10

2026-02-10

2026-02-06

2026-02-10

2026-02-10