臉書現在以機器學習工具,評估可能支持ISIS和蓋達組織的貼文。系統在評估文章之後,會給一個恐怖分數,當恐怖分數夠高時,系統確認該貼文支持恐怖主義,則會自動刪除,但不少情況還是會經過審核人員進行人工判讀。

恐怖組織現在會在網路平臺上傳播恐怖主義,臉書提到,這是剛出現的新現象。恐怖組織對反恐工具有很好的滲透以及能力,出現在各社交平臺都不令人驚訝。最新一波的恐怖主義傳播,恐怖組織成員棄用了遭破解的舊帳號,重新創立帳號並使用新的暗號語言,還將訊息切分成多重碎片,以規避遭到反恐工具的偵測。

為此,臉書現在應用機器學習評估可能支持ISIS和蓋達組織的貼文,這個工具會對貼文產生一個分數,以判斷是否違反反恐政策,而這能用來幫助審核小組,優先關注分數最高的的貼文,對急需要處理的內容採取行動。在部分情況下,系統認為貼文嚴重違反反恐政策時,會自動刪除內容,雖然多數得情況下,仍然需要仰賴專業的審核人員評估貼文內容,但當機器學習工具出現極高分,可信度高於人類判斷時,就會立即刪除貼文。

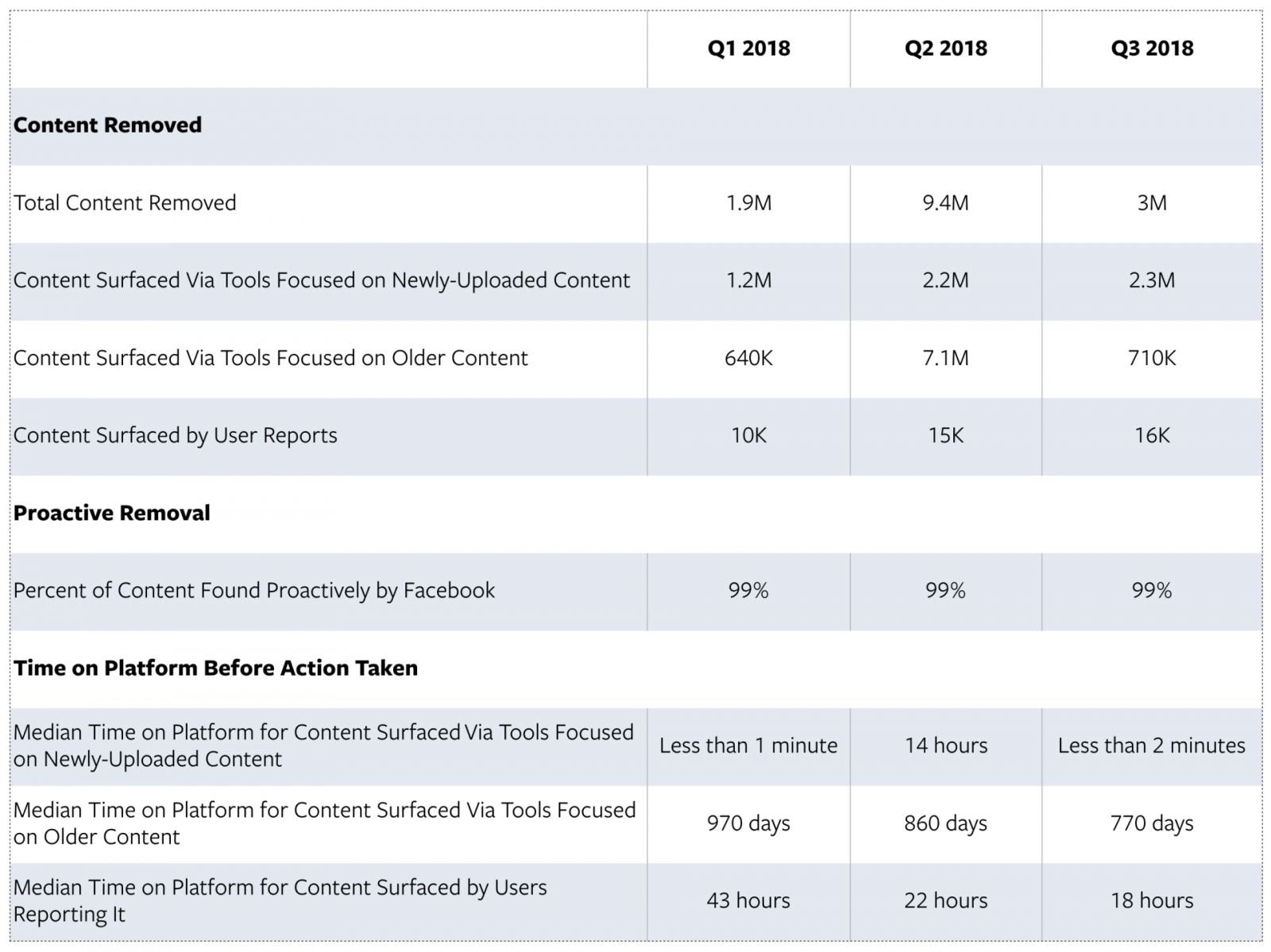

臉書提到,在臉書平臺上龐大規模的內容,無論是人類或是機器都會犯錯,因此他們在擴大申訴程序後,才啟用自動刪除機制。這項工具大大減少了臉書處理使用者回報恐怖內容的反應時間,從2018年第一季報告的43小時,在第三季降低到了18小時。

另外,臉書還改進了一些現有主動技術,現在已能更有效的發現恐怖主義內容,透過自然語言理解技術發展,可以支援識別19種語言,演算法能更敏銳的找出違反政策的貼文。過去臉書使用在圖像和影片雜湊技術,透過將檔案轉換成對應數字字串,來作為辨識檔案的數位指紋的技術,現在也應用在檢測文字以及聲音中的恐怖內容。臉書也持續的和GIFCT(Global Internet Forum to Counter Terrorism)成員技術合作分享數位指紋,同時也正開發新的雜湊技術,供該聯盟其他成員使用。

在2018年第二季,臉書移除了ISIS和蓋達組織相關的940萬則內容,而到了第二季下降到了300萬則,其中80萬則為過時的老舊內容,臉書表示,這樣的數據改變,顯示他們在第一季的努力有了成果,而在第二季和第三季的報告顯示,有超過99%的恐怖內容,在有人檢舉之前就已經被系統刪除,比起在第一季他們對190萬件採取行動,其中64萬件採用專用工具識別的成果來說,效率更快也更全面。

另外,比起恐怖主義內容在平臺停留的時間,觀看人數是一個更直接衡量傷害的指標,因為內容可能在短時間就獲得大量地關注,而這比起內容在平臺存在一段時間沒被使用者觀看,造成的影響更大,因此臉書提到,一味追求最小化移除恐怖貼文的時間,會讓尋找最大傷害的內容效率降低,反而降低整體反恐工作的效能。

恐怖份子不停的尋求規避臉書偵測技術的方法,臉書需要不斷的改進技術、訓練和流程來應對這類攻擊,雖然在一開始的時候成果有限,但在系統成熟後,已經能發揮良好到功能。臉書資料顯示,第二季系統對新上傳恐怖內容的反應時間為中位數14小時,而第三季系統的反應時間下降低於2分鐘,臉書認為,這是系統成熟的指標。為了避免刺激恐怖份子對抗這些新的反恐技術,臉書沒有透露太多的系統細節,而要應付極具彈性的恐怖份子,也代表這個問題沒有完全解決的一天。

熱門新聞

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-09

2026-02-06

2026-02-09