Google宣佈以AI技術BERT,來提升對話式查詢(conversationl queries)的搜尋結果品質和相關性,讓Google Search向自然語言搜尋更進一步。

Google雖然是搜尋巨人,過去也努力改進對用戶搜尋語言的理解能力,但也坦承有時仍然會出錯,尤其碰上較複雜或對話式查詢時,人們還是得輸入一長串個別關鍵字,而無法運用自然語言進行搜尋,。但Google最近引用了機器學習技術,可望改善它的搜尋理解能力。

去年底Google推出並開源一項自然語言處理(NLP)預訓練的神經網路技術BERT(bidirectional encoder representation from Transformer)。和傳統技術相較,BERT會考慮關鍵字的上、下文以理解意義。而且BERT發展成的模型複雜度之高,讓其運算量超過傳統硬體,迫使Google還必須用最新的Cloud TPU來跑搜尋引擎。

最近Google將BERT模型,同時運用在Google Search的排序和精選摘要(Featured Snippets),以便提升搜尋結果相關性。事實上,Google評估BERT可以提升它對1/10美式英語查詢輸入的理解能力,並表示日後會用於改善其他地區和語言搜尋。

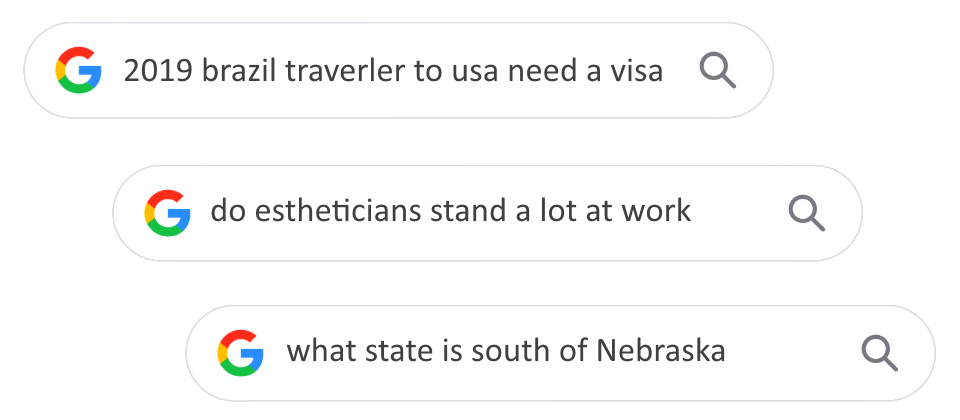

Google搜尋院士Pandu Nayak說,運用BERT的成效反映在對話式或是包含較多to及for等介系詞的長字串查詢上。例如「2019 brazil traverler to usa need a visa」搜尋句當中,「to」是很關鍵的,決定了是從巴西到美國旅客才需要簽證。但以前Google的演算法會忽略「to」,而回傳從美國公民到巴西旅客的資訊。BERT更能理解to的意義,進而提高搜尋結果相關性。又如在「do estheticians stand a lot at work」一例中,過去系統以字詞比對方式,會搜尋出有「stand along」的字句。但BERT模型就能理解,此句在上下文的意思中表示,美容專家需要經常站著工作。

此外,Google指出,BERT學習力之強大,也能用在其他語言的搜尋服務上,例如現在Google也將BERT模型套用在其他12國,包括韓文、北印度語及葡萄牙語地區的精選摘要。

但BERT仍然會犯錯,如果使用者想查內布拉斯加州以南是什麼州(what state is south of Nebraska),BERT會回傳一個位於佛州名為South Nebraska的社區。Google說這也是驅策他們持續改進的動力。

熱門新聞

2026-02-09

2026-02-10

2026-02-06

2026-02-09

2026-02-10

2026-02-10

2026-02-10

2026-02-09