紐約大學訓練深度卷積神經網路(CNN)用於判讀乳房X光片,找出乳癌病徵,並期望將機器學習模型偵測整合進乳癌篩檢流程,能提高篩檢效率,而實驗也證實,機器學習模型預測乳癌的精確度已經高於單位放射科醫師,而且在篩檢流程中,同時結合醫師的專業和模型預測,將能有效減少醫生人力並提升判讀精確度。

研究人員提到,乳癌的研究主要遭遇兩項困難,第一是訓練資料集不足,另一個則是乳房攝影的圖像解析度過大。由於採用深度學習方法的電腦視覺技術,需要大量的訓練圖像資料集,資料集的多寡會直接影響模型預測的精確度,而通常一般的電腦視覺應用,會使用擁有1,400萬張圖片的ImageNet資料集,作為訓練資料。

不過,可用的公共乳癌資料集非常少,像是DDSM(Digital Database for Screening Mammography)資料集僅有一萬張圖像,因此為了要解決這個問題,紐約大學自己建構了乳癌篩檢資料集,這是擁有大量乳房篩檢X光片的龐大資料集,總共包含超過一百萬張乳房X光照片。

另一個問題便是乳房X光照片的解析度非常大,而且也必須要這麼高的圖片解析度,模型才能良好地預測結果,但因為這些照片比起像是ImageNet這類資料集裡的圖像解析度還要高上許多,礙於GPU記憶體的限制,研究團隊必須要調整模型架構,他們創建了與一般ImageNet模型相比,相對較淺的22層ResNet模型。由於完整的乳房X光照片,是由4張乳房X光照片組成,因此研究團隊也就同時為篩檢應用4個ResNet模型。

.png)

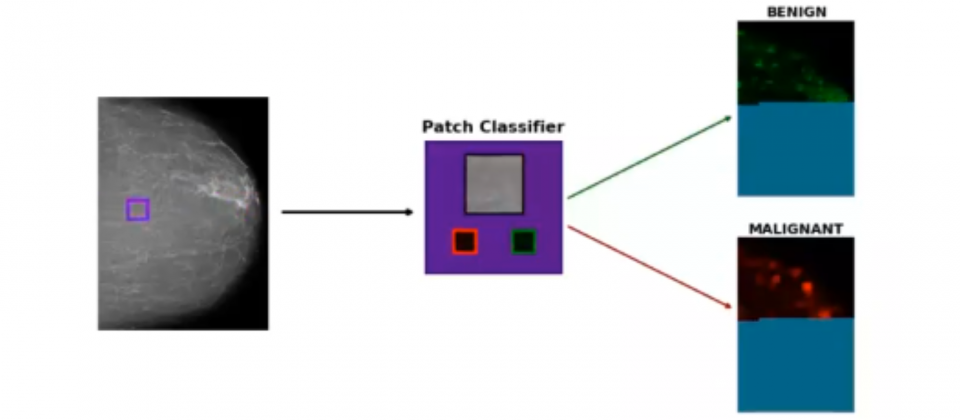

研究人員解釋,使用較淺的模型架構,意味著模型可能無法偵測到較小且局部的癌症組織,因此為彌補不足,他們也同時訓練一個完整50層的ResNet-50模型,但僅用來分類圖片區塊(Patch),而非整個乳房X光照片。採樣的圖片區塊大小為224×224畫素,這個區塊會在完整的圖片上滑動,以判斷區塊中是否存在病變,藉此繪製出癌症熱點圖。結合局部區塊與全域預測方法,該模型能偵測乳房X光照片中全域與局部特徵。

研究團隊對模型進行多個實驗,該乳癌預測模型判讀精確度比單個放射科醫生還要高,而當一位放射科醫生結合使用乳癌預測模型,則判斷的精確度會比多位放射科醫生的綜合判讀精確度還高,當多位放射科醫生的判讀加上乳癌預測模型,則精確度就更高了。總體而言,深度神經網路能有效的減輕放射科醫生判讀乳房X光片的負擔,且能明顯提高精確度。

熱門新聞

2026-02-13

2026-02-13

2026-02-13

2026-02-13

2026-02-13