【美國拉斯維加斯現場報導】以雲端服務起家的AWS,近年來開始投入硬體晶片的開發,並且以此推出執行個體服務(instance)。

例如,他們在去年的re:Invent大會宣布推出Graviton處理器,就是他們所設計的Arm架構晶片,並且基於這顆處理器,在EC2旗下發展出執行個體服務A1,今年他們再接再厲,運用自行設計的第二代Arm架構處理器Graviton2,發展出三套執行個體服務,分別是M6g、C6g、R6g。相較於採用x86處理器架構的M5、R5、C5等執行個體,新推出的三套執行個體的性價比可高出4成。

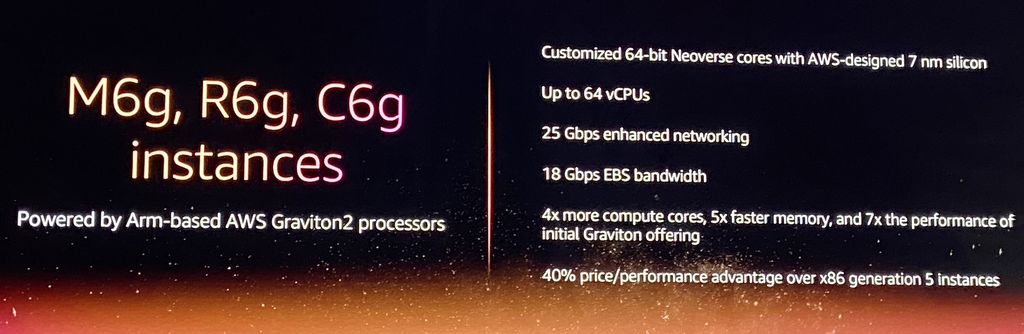

在硬體架構上,Graviton2處理器包含了64位元的Arm Neoverse核心,以及AWS設計的矽晶片,使用了7奈米製程,每顆核心在科學與高效能運算的工作負載上,可提供2倍的浮點運算效能、額外的記憶體通道、兩倍容量的每核心快取,能將記憶體存取速度提升至5倍,整體效能增長至7倍。針對機器學習的推論,這顆處理器也提供最佳化指令集,面對壓縮工作負載,它也提供可自定的硬體加速機制。

安全性的部份,Graviton2支援DDR4記憶體全程加密,而在每顆核心加密效能上,可提升50%。

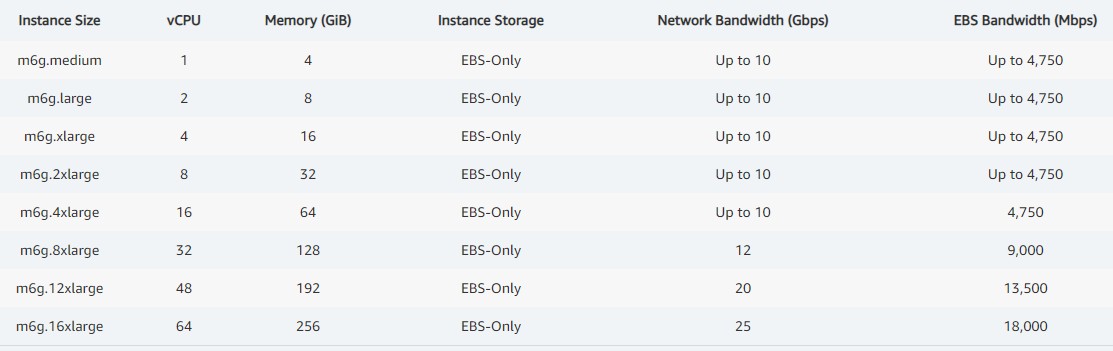

而基於AWS Graviton2的執行個體,在規格上有那些特性?最高可配備64顆 vCPU、25Gb網路,以及18Gbps頻寬的EBS雲端儲存服務,用戶可搭配不同的NVMe SSD作為執行個體(例如M6gd、C6gd、R6gd,加上d字表示搭配NVMe本機儲存),或選擇裸機型態的執行個體。相較於第一代Graviton剛推出時的A1執行個體(16顆vCPU、10Gb網路、3.5 Gbps頻寬的EBS),這批新採用Graviton2的執行個體,運算核心提升至4倍,而記憶體存取速度與整體效能的增長,也同於上述Graviton2高於Graviton的幅度。

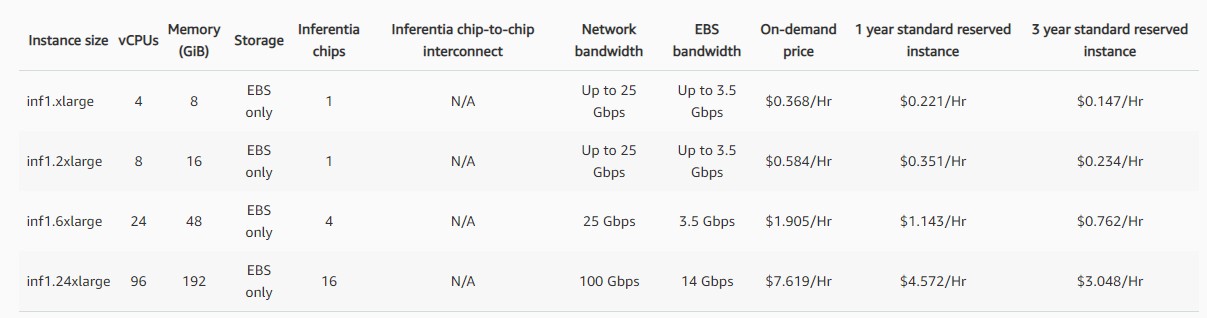

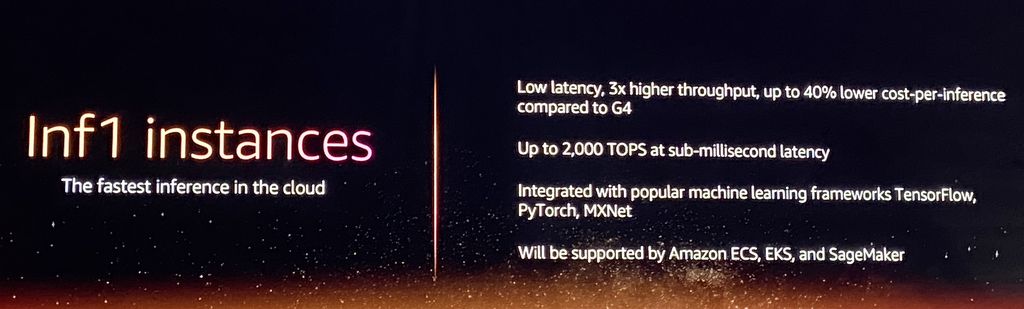

另一個例子,則是AWS設計的高效能機器學習推論專用晶片Inferentia,在今年的re:Invent大會上,AWS宣布推出基於這個晶片的執行個體Inf1。Inferentia能夠針對一些需要極度成本效益的即時與批次推論應用,提供高吞吐量、低延遲性與持久的效能。

一般而言,在面對多個機器學習的框架與多種資料類型時,Inferentia可提供的運算力是128 TOPS,而每個Inf1的執行個體當中,最高可達到2,000 TOPS。若相較於EC2旗下同樣可執行推論處理的GPU執行個體G4,Inf1在進行推論作業時,可得到較低的延遲度,吞吐量能達到3倍之高,更重要的是,單位推論成本(cost-per-inference)也少了4成,AWS認為,綜觀目前提供機器學習推論的雲端服務項目當中,Inf1可說是成本最低的執行個體。

熱門新聞

2026-02-11

2026-02-12

2026-02-11

2026-02-10

2026-02-09

2026-02-13

2026-02-10