一般來說,量化能讓模型更輕、更快,但會損失準確度。然而,經測試,Google釋出的QAT API可保有幾乎相同的模型準確度。

重點新聞(0410~0416)

量化意識訓練 API 機器學習模型

Google釋出QAT API,加速部署更輕、更快的ML模型

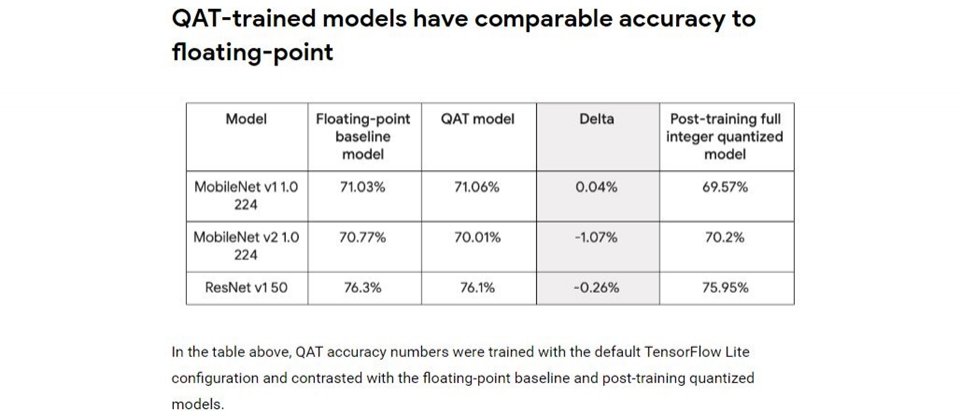

Google日前發表一款量化意識訓練(QAT)API,要讓開發者開發和部署更輕、更快的ML模型,同時又保有與原始狀態相當的精確度。QAT API是深度學習框架TensorFlow模型優化工具包的一部份,進一步來說,量化是指將模型轉化為較少參數、使用較少運算資源的過程,但精確度會有所損失。

而QTA是要在向前的訓練過程中,模擬低精確度的推論運算時間。Google指出,這個方法可將量化誤差,視為訓練過程的雜訊和整體損失,可透過演算法來優化。也因此,模型能學習到更彈性的參數。Google也用ImageNet的圖像分類模型來測試QAT API的準確率變化,結果發現,經量化的模型準確度,和原本浮點基準模型相比,可從71.03%提高至71.06%,就算有所下降,最多也才差了0.76%,但卻可以加速訓練和減少參數。(詳全文)

TensorFlow BERT 輕量模型

TensorFlow Lite不只新增輕量BERT模型,還推新工具來簡易模型客製

Google輕量版深度學習框架TensorFlow Lite問世近三年,日前發表一系列更新,主打能輕易客製高階模型的Model Maker工具,可透過遷移學習,來讓內建模型更適應使用者的資料集。特別的是,Model Maker只用了一個直覺式的API,來打包複雜的機器學習概念,因此,就算使用者不具AI專業背景,也能快速上手。Model Maker支援TensorFlow Hub上的多數模型,使用者只要用一行程式碼,就能轉換模型架構,達到更高的準確度。Model Maker目前只支援圖像和文字分類模型,未來將新增更多NLP和電腦視覺相關的模型。

另一方面,這次新增也納入3種模型架構,包括EfficientNet-Lite、MobileBERT和ALBERT-Lite。第一款是輕量的圖像分類模型,可使用較少的運算資源和參數,達到高階準確率;MobileBERT則是優化版的BERT,比BERT更輕,執行速度快上4倍,準確率也相近。ALBERT-Lite也是優化版的BERT,比BERT小了6倍,延遲性也相當。(詳全文)

成大 武漢肺炎 科技防疫黑客松

成大肺炎AI從上千組團隊脫穎而出,上榜WHO科技防疫黑客松Top 25

成大團隊繼2月開發出武漢肺炎(COVID-19)胸腔X光片判讀AI後,不斷精進、優化,日前更組隊參加由WHO和科技龍頭舉辦的國際COVID-19科技防疫黑客松大賽,以92%準確度和1秒的判讀時間,從全球1,560個團隊中脫穎而出,成為醫療組25個獲選團隊中,唯一入榜的臺灣團隊。

這套AI系統由上千張經標註的胸腔X光片訓練而成,只要1秒就能判斷是否有武漢肺炎病癥,可縮短人工判讀時間,加速檢測流程。這次黑客松大賽分為七大主題,像是醫療、教育、經濟、社群等,團隊挑戰競爭激烈的醫療組,並成為獲選的25組團隊之一。成大團隊指出,未來開發完成後,即便是在缺乏醫師的地區,也能透過AI迅速偵測疾病,阻止擴大蔓延。(詳全文)

自然語言處理 跨語言 XTREME

Google釋出跨語言通用任務基準測試

近來深度學習崛起,出現許多處理跨語言通用任務的方法,但卻沒有有效的評估方法。為此,Google近日釋出跨語言通用任務基準測試XTREME,針對40種語言設計了9種不同程度的語意與句法推理任務,要來評估AI模型是否具備跨語言的知識。

Google指出,顧及現有訓練資料,團隊盡可能挑選40種特色鮮明的語言(包含12種語系),來加強多樣性。當中也包含了鮮少研究的語言,像是印度達羅毗荼語系的泰米爾語、非洲尼日剛果語系的斯瓦希里等。而XTREME中的任務,涵蓋了句子分類、結構化預測、句子檢索和問答等。如此一來,AI模型要通過XTREME測試,就必須學習許多可以跨語言且通用的標準特徵,直接促進了跨語言的研究。(詳全文)

聲音標註 資料集 武漢肺炎

聲音標註有解!Google開源聲音分離模型資料集FUSS

Google發表了一套通用聲音分離資料集FUSS,來推動聲音分離的研究。FUSS可讓研究人員利用模型,從多個聲音來源的錄音中,分離出各種聲音。

一般來說,就算擁有高品質、多重音源的錄音,也難以用參考基準來標註這些聲音,反而要用錄音室模擬器,來設計逼真的參考基準音。FUSS可解決這個問題,它採用了freesound.org上CC授權的音訊剪輯,取得約23小時的錄音,其中包含12,377種可用於混音的聲音,接著,Google再用TensorFlow開發的模擬器,來處理這些音訊剪輯,共建立了2萬個用於訓練的混音,1千個驗證用混音和1千個評估用混音。這次釋出的內容,包含各種聲音的FUSS資料集、音訊樣本的聲音組成程式碼,還有基準模型。(詳全文)

Cloud Dataprep 智慧資料 簡化

Google智慧資料服務Cloud Dataprep增強AI功能簡化資料清理

Google更新自家智慧資料服務Cloud Dataprep by Trifacta,加入新AI功能,強化資料疊加功能(Wrangling)、改善Dataprep核心轉換功能,讓清理資料和操作變得更簡單。

Cloud Dataprep讓用戶可利用圖形介面,來瀏覽、清理和準備相關資料的服務,可處理結構化與非結構化資料。這次的更新,讓用戶使用Dataprep準備資料時,可透過探索模式來找出有用的資料,或是使用資料的方式,甚至用來強化現存資料倉儲。用戶可以使用快速指定目標功能,將資料疊加方案(Wrangling Recipe),快速映射到BigQuery中的資料架構或Cloud Storage中的檔案,不需要自行將資料轉換規則,來配對資料結構。(詳全文)

聯合學習 智慧醫療 個資隱私

Appier首席人工智慧科學家孫民:聯合學習是大規模醫療AI部署關鍵

Appier首席人工智慧科學家孫民指出,聯合學習具備遷移學習、分散式訓練,還有把關資料安全的差分隱私這三個特色,是實現醫療AI大規模部署的關鍵技術。假設,有多個分院想建置腦腫瘤電腦斷層掃描影像判讀的AI,團隊可透過遷移學習,收集各分院的醫療影像,訓練出母模型後,再部署到各分院。

再來,為減少資料傳輸時間和成本,可在各分院利用分散式訓練,以自行產生的數據來訓練子模型,不需將所有資料回傳至母模型端,只須回傳模型統計值。為避免駭客從中作梗,聯合學習利用差分隱私機制,在回傳資料中增添雜訊,讓駭客無法推敲出特定個資,同時又不影響模型表現。孫民認為,聯合學習會是未來5年的熱門AI技術。(詳全文)

Nvidia 人臉偵測 AR SDK

臉部偵測和重建更簡單,Nvidia釋出串流媒體人臉特徵偵測AR SDK

Nvidia推出AR SDK公開測試版,是一套專為視訊會議和遊戲等串流媒體,所設計的AR開發工具,可用來進行人臉偵測、人臉特徵標記偵測,或結合一般網路攝影機來建立人臉3D模型。

AR SDK臉部偵測和追蹤功能,可在圖像或影片中,透過定界框(Bounding Box)偵測、定位和追蹤所有出現的人類臉部,或用來預測和追蹤人臉特徵標記,在臉部形狀、嘴唇、眼睛、眉毛和鼻子標記特徵點,還可用這些人臉特徵點,重建和追蹤3D人臉與頭部姿勢。這些功能可用於多種情境,像是追蹤相機中的臉部,或為圖像中的人臉加上各種特效,也能利用臉部表情,控制動畫或是遊戲角色。(詳全文)

圖片來源/TensorFlow、成大、Google、Nvidia

AI趨勢近期新聞

1. Nvidia聯手海德堡大學,用自監督學習打造視點預測AI

2. 臉書RegNet模型超越Google EfficientNet,在GPU上跑快5倍

3. 結合多種AI輔助功能,Webex提升與會者彼此認識與語音控制

4. 史丹福大學、Fitbit合作研究以穿戴裝置偵測病毒感染症狀

資料來源:iThome整理,2020年4月

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-10

2026-02-06

2026-02-10

2026-02-10