Google發布了藉由大規模預訓練方法,微調出能夠快速轉移運用其他資料集,以解決各種電腦視覺任務的預訓練模型BiT(Big Transfer),強調能更有效率地應用轉移圖像資料集,並獲得極佳的Top-5精確度。

Google提到,雖然目前對電腦視覺研究人員來說,要讓深度神經網路表現得越好,就需要用更多的標籤資料進行訓練,以要訓練CNN為例,研究人員可能需要使用OpenImages或是Places這類資料集,以上百萬的標籤圖像進行訓練,但是對許多應用程式開發者來說有其困難度。

而預訓練便是一個替代的好方法,可以先以通用的資料訓練模型,而在通用資料上學習到的視覺特徵,模型就能拿來重用在目標任務上,雖然這種方法在實踐上相當有效,但在不同的環境中,模型仍無法快速地掌握新概念,Google表示,取自改良語言模型BERT和T5的概念,他們認為大規模的預訓練可以提高電腦視覺模型的效能。

為了驗證資料規模的影響,Google使用了ILSVRC-2012、ImageNet-21k和JFT三個不同規模的資料集進行實驗,三個資料集內含圖像數量,分別為1百多萬、1千多萬和3億張,Google將這些資料集拿來訓練ResNet架構,發現要讓更多的訓練資料發生作用,必須要同時增加模型的容量,而且訓練持續時間也變得非常重要,在預訓練較大資料集時,不調整運算時間,將會使得結果更糟,一旦能根據資料集調整運算配置,將會大幅改進效能。另外,Google還提到,用群組正規化代替批次正規化,也是提高效能的重要關鍵。

Google將BERT上在語言領域所建構的方法,拿用來調整預訓練的BiT模型,Google提到,由於預訓練模型已經能夠很好地理解視覺世界,因此這種簡單的策略非常有效。只不過有許多超參數需要微調,Google運用了啟發式的超參數調校方法BiT-HyperRule,透過使用一些圖像辨識率以及標籤範例數量等高層級的資料特徵,調整參數配置,Google成功將BiT-HyperRule應用在20多種不同的任務中。

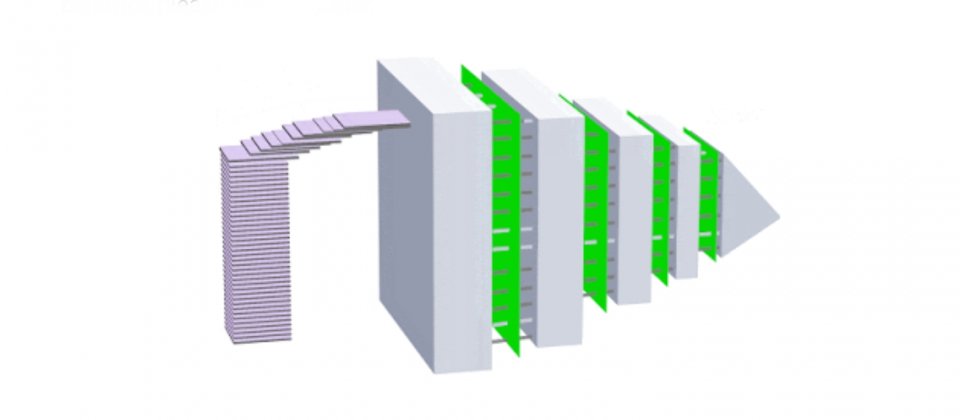

要使用很少的範例轉移BiT解決其他任務時,只要增加預訓練的通用資料量,以及基礎結構的容量,所產生的模型,其適應新資料的能力就越好,(下圖)BiT轉移處理CIFAR-10資料集,使用圖片最少的資料集ILSVRC-2012所訓練的模型,較其他兩個資料集的精確度都差,而JFT則是使用較大的資料集在較大的基礎架構預訓練,明顯資料效率更高。

.png)

在其他的實驗也都呈現相同的結果,包括將BiT模型用到ObjectNet資料集上,Google提到,ObjectNet資料集與現實場景很像,物體可能出現在非典型的背景,並以非典型的視角和旋轉呈現,而Google光使用ILSVRC-2012訓練並進行微調的模型,Top-5精確度就可以達到80%,比之前最好的成果還要高25%。

.png)

Google現在發布了以ImageNet-21k進行預訓練的BiT-M模型,並且提到,這將可以用來代替常用的ImageNet預訓練模型。

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-10

2026-02-06

2026-02-10