Google開發出新的物體偵測演算法Context R-CNN,會將時間因素納入考量,利用攝影機一個月拍攝到的影像,提升電腦視覺模型效能,這將使得新部署的攝影機,可在不依賴大量攝影機訓練資料的情況下,提高物體辨識的能力。

生態學家為了有效地進行生態監控,像是了解全球生態系統變化,或是評估人類活動對生態造成的影響,需要耗費大量的精力擺設攝影機,以取得高品質的監控資料。雖然建立監控網路的成本越來越低,但是收集用於全球生物多樣性資料的即時生態監控技術,仍然有其瓶頸。

Google提到,目前存在各種利用機器學習技術,自動執行分析的方法,但是用來監控山路狀況以及生態系統的靜態攝影機,其拍攝的影像品質不佳,無法良好地應用在現有的電腦視覺技術中,原因在於野外靜態攝影機電源以及儲存容量的限制,使得影像採樣頻率太低,甚至一秒不到一影格,再加上部分攝影機以運動偵測觸發,畫面採樣頻率可能更不穩定。

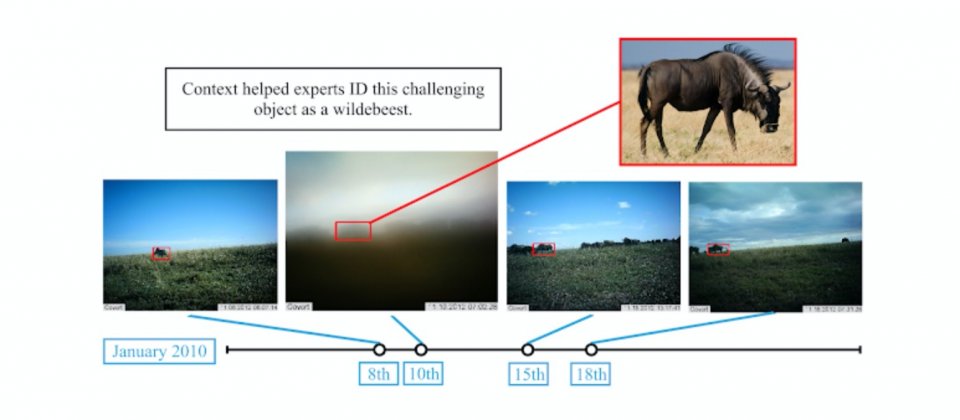

此外,電腦視覺模型還需要能強健地處理模糊(下圖)、沒有對焦、物體在邊緣或是光線不足等影像,而且除非靜態攝影機被移動,否則便會始終拍攝同一個場景的圖像,這使得來自任何一臺的攝影機的圖像,都有高度的重複性,在資料多樣性不足的情況下,機器學習模型會將學習聚焦於背景關聯,使得模型難以適用到新部署的攝影機。

.png)

現在許多研究團體合作,收集並由專家標記訓練資料,每個研究小組提供一到數百個相機陷阱拍攝到的圖像,以提高資料的多樣性,但是因為資料收集和標記的過程很慢,而且要同時在跨地理區域和分類中達到多樣性,是很不容易的事。為了解決這些問題,Google開發出了Context R-CNN,能夠不依賴大量攝影機訓練資料,而是利用時間上下文(Context)提高新部署攝影機辨識物體的能力。

Context R-CNN是由熱門的兩階段物體偵測基礎架構Faster R-CNN改良而來,簡單的來說,Context R-CNN利用同一臺攝影機中長達一個月的圖像作為上下文,以提升分類圖像物體的正確性,這種方式與專家判斷圖像內物體的方法相似,圖像中除了物體的形狀以及大小之外,時間也是很重要的判斷資訊,像是一天中特定的時間或是習慣性放牧等背景資訊,都有助於專家從大霧朦朧的圖像中,辨識圖像中的物種是牛羚。這種方法能夠良好地應用於擺放在野外,專門拍攝野生動物的相機陷阱,同時能改進對新攝影機部署的通用性,且不需要額外的人工資料標記。

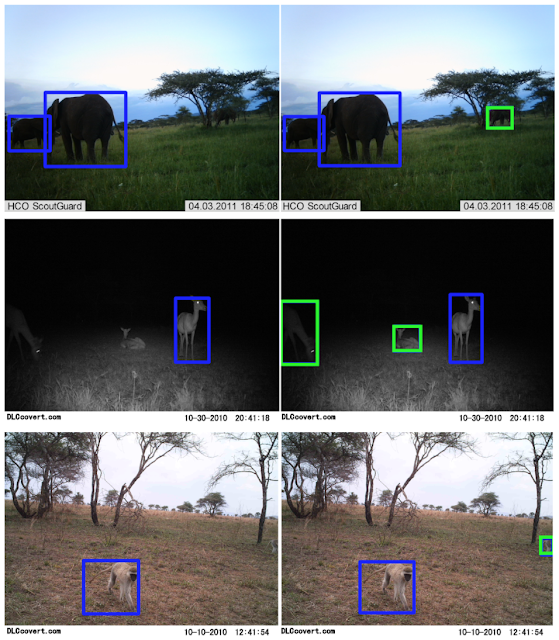

與Faster R-CNN baseline(圖左)相比,Context R-CNN(圖右)能夠從相同的圖像中,辨識出更多的動物,Google在Snapshot Serengeti(SS)Caltech相機陷阱(CCT)生態資料集測試了Context R-CNN法,這兩個資料集分別收集自坦尚尼亞以及美國西南部,Context R-CNN在SS資料集的平均精度均值相對提高了47.5%,而在CCT的平均精度均值,則相對提高了34.3%。Google發現模型的效能,隨著上下文時間範圍的增加,從一分鐘到一個月逐漸增加。

現在Google正於Wildlife Insights平臺中實作Context R-CNN,計畫利用相機陷阱進行大規模全球監控,Google提到,由於他們所開發的Context R-CNN是通用的,因此利用個別感測器的上下文資料,可提升任何靜態感測器的效能。

熱門新聞

2026-02-09

2026-02-10

2026-02-06

2026-02-10

2026-02-10

2026-02-09

2026-02-10