Google釋出了新的實驗性TensorFlow隱私測試模組,這個模組可以讓開發人員評估其分類模型的隱私屬性,該模組會產生一個漏洞評分,以表示模型是否會因訓練資料集而洩漏資訊。

官方提到,隱私是機器學習領域重要的新興話題,目前還沒有能夠產生私密模型的規範,但有越來越多研究顯示,機器學習模型會洩漏訓練資料集中的敏感資訊,對使用者造成隱私上的風險。

去年的時候,TensorFlow推出讓開發人員使用差分隱私(Differential Privacy)方法,來訓練模型的功能。所謂的差分隱私,是一種密碼學方法,透過在資料集中加入雜訊,以完全隱藏個人資訊,使個人身份無法被辨識,不過TensorFlow Privacy所使用的雜訊,是為學術中最糟的情境設計,可能會嚴重影響模型的準確性。

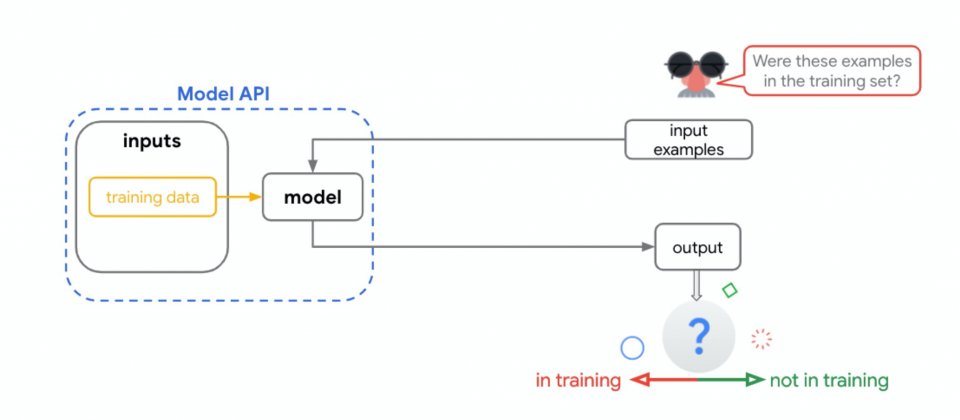

為此,官方想以不同角度來處理隱私問題,而TensorFlow隱私測試函式庫這能促進相關的研究,其使用的測試方法,來自於成員推理攻擊(Membership Inference Attacks),官方表示,該攻擊手法可以預測模型訓練期間使用的特定資料,當攻擊者能夠進行高精準度的預測,就能成功獲取訓練集裡的資料。

原本官方在內部利用成員推理進行測試,該測試會產生一個分數,顯示模型是否洩露資訊,而官方提到,經實驗證實,差分隱私可以有效的降低漏洞分數,即便雜訊很小,漏洞評分也都能夠降低。

現在Google將該測試方法以模組的形式對外釋出,協助開發人員建立更私密的模型,並探索更好的架構,並表示,這些測試結果都將回饋到開發人員社群,共同發展出更好的隱私設計原則和資料處理方法。

熱門新聞

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-09

2026-02-09

2026-02-06