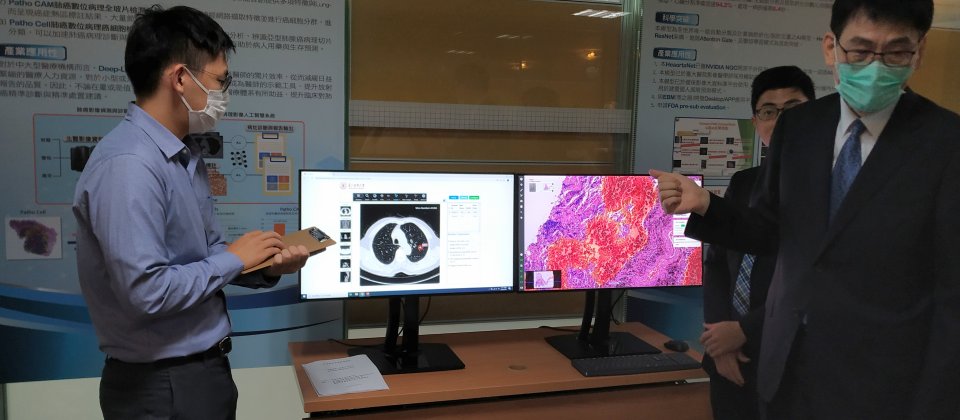

臺北醫學大學展示肺部AI診斷系統,包括肺部CT影像及病理影像,透過AI找出病灶。

在政府推動精準醫療及精準健康政策,以及AI產業應用之下,科技部與衛福部聯手推動國內醫療影像AI應用,本周臺大、臺北榮總(北榮)、臺北醫學大學(北醫)三個研究團隊展示成果,透過AI輔助判斷醫療影像,協助醫師判別心、腦、肺重大疾病,大幅縮短診斷時間。

科技部推動「醫療影像之巨量資料建立與應用研究專案計畫」,2018年與臺灣大學、臺北榮總、臺北醫學大學合作,啟用國內第一個跨院所的醫療影像資料庫,涵蓋心、腦、肺部醫療影像資料,由三個醫療團隊以人工方式標註資料,並進一步和其他業者、研究單位聯手,發展醫療影像AI診斷模型。

隨著專案即將在今年底結束。科技部政務次長謝達斌表示,衛福部、科技部及經濟部將展開合作,從2021年推動4年期的精準健康大數據永續平台,結合醫療影像、病理、基因資料形成複合式的巨量資料,可以加速臨床轉譯開發研究,除了可為國人健康把關、更有效率的治療,也能幫助國內生醫產業發展。

謝達斌指出,醫療影像對臨床診療有相當大的幫助,也是AI最有明顯效果的領域,透過補助學研界對心、腦、肺重大疾病,在AI輔助檢測判斷醫療影像下,短時間內就能產出具國際標準的檢測報告,讓醫生覆核的依據,臨床上從傳統20、30分鐘降到5分鐘,研發過程標註的模型及資料庫放在國網中心,在保障個人隱私下提供給其他團隊使用,帶動進一步的發展。相信對小醫院及偏遠地區的輔助判斷能夠帶來幫助,未來影像數據加值發展精準醫療,也能建立良好示範,加上共享機制和個資保護,有助於加速我國醫療AI及產業發展,這些成果也為複合式資料運用的精準醫療發展打下里程碑。

衛福部健保署為了協助三個團隊在醫療影像AI診斷模型訓練上能突破訓練用資料的侷限性,健保署和科技部合作,開放三個團隊運用健保署從前年開始蒐集民眾在各個醫療院所做CT、MRI、X光檢查影像資料,現在約有超過17億張的影像資料,運用這些多樣性資料進一步優化AI模型辨別的準確性。

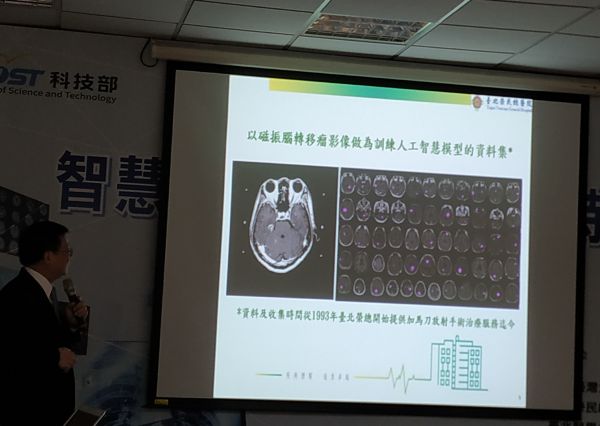

北榮展示腦轉移瘤AI輔助診斷系統,開設多個AI輔助門診

臺北榮總針對腦部轉移瘤展示了AI診斷系統DeepMets,該團隊使用榮總歷年累積的各種腦部腫瘤影像資料,共超過160萬張影像,經過篩選、標註,2018年他們和臺灣人工智慧實驗室合作展示第一個版本。雖然第一版已有不錯的辨識準確性,但由於訓練資料仍有侷限性,因此他們除了使用自家的1,100個病例,也利用健保署資料庫中的3,100多個腦轉移瘤病案,利用開源的聯合學習(Federated Learning)套件Harmonia進行聯合學習,開發出DeepMets+,強調在不同的主要MR設備廠牌上能夠找出腦轉移瘤病灶,計算數量、最大徑、體積等。DeepMets+在腦轉移瘤判斷的Precision達到97%、Recall召回率達95%、F1 Score達96%。

AI輔助診斷也對民眾看病流程帶來影響,在未導入AI輔助診斷之前,傳統的肺癌檢查流程,從患者在胸腔科看門診,安排磁振及電腦斷層檢查,理論上放射科醫師花費5至7天時間製作報告,病患再回診看報告,由醫師決定治療方針。

導入AI輔助診斷後,臺北榮總放射線部主任郭萬祐指出,原本的流程縮短了,例如病患在早上看過胸腔科門診,循綠色通道,中午為病人安排影像檢查,當天下午第二次門診,由AI輔助診斷系統協助醫師判別腦轉移瘤情形,判別肺癌發展至哪一階段,及早決定病人的治療方針。醫學影像檢查的正式報告,仍由放射科醫師花費5到7天製作。

北榮已將DeepMets應用在該院的神經影像及胸腔內科AI輔助門診,偵測腦轉移瘤病灶,已應用在超過1,500個病例上,醫生閱片時間從人工至少10分鐘降為30秒,診療流程從2週縮短為半天。

目前北榮已開發出約10支AI模型,郭萬祐表示,DeepMets未來不只放射科,模型也放至胸腔科,可以想像診間內有各種模型,輔助醫師診斷肺結節、結核、腦轉移瘤、肺癌。

北榮在去年2月已在三個門診使用AI輔助診斷,包括AI輔助心房顫動電燒門診、AI輔助腦影像門診、AI輔助脊椎骨折門診,今年新增青光眼門診。

北醫靠AI縮短醫師檢視、診斷肺癌時間

根據衛福部統計,肺癌為國內癌症死亡率第一,病患五年的存活率只有15%,且高達7成的串者診斷時已是末期,為了及早診斷肺癌,北醫在科技部補助下,開發肺部人工智慧診斷輔助系統Deep-Lung,這套系統分為兩部份,分別檢測CT電腦斷層影像、數位病理影像。

北醫展示的肺部AI診斷系統Deep-Lung,包括左邊螢幕的CT影像,靠AI找出肺結節,右邊則是數位病理全玻片影像,找出切片中的癌細胞,並對其分群:

在肺部CT影像方面,北醫運用影像標註、語意標註,共計6千例,肺結節標註系統,北醫運用3D-RPN偵測肺結節位置,可偵測多顆肺結節,北醫副校長陳震宇表示,精準度Sensitivity已達到近86.9%。進一步透過特徵提取、深度學習模型,對良惡性分類的準確率可達到98%。綜合偵測、分類、自動報告發展出肺結節CT診斷輔助系統Deep-lung:LungRads,利用AI輔助偵測、分類,以及按照肺結節處置自動分級,建議醫生處置方式。

至於數位病理影像方面,北醫以3千片肺部病理影像,和雲象科技合作開發數位病理全玻片檢測系統Deep-Lung:Patho CAM。由於全玻片病理影像檔案高達1GB,他們和國網中心合作,運用臺灣杉二號的運算能量,利用CNN架構結合專利技術對癌細胞分群,同時以視覺化方式標示出全玻片影像中病灶位置。

陳震宇強調Patho CAM已能在全玻片影像中,只要10秒鐘找出癌細胞的位置,準確率可達90%,猶如在Google Earth中找到某一棟建築物,由於80%的肺腺癌混有兩種以上的亞型癌細胞,不同亞型對治療方式的效果也有差異,這套系統還能進一步分辨癌細胞的亞型分布及定量,協助醫師擬定適合的治療方針。

根據北醫的測試,在肺部CT影像方面,放射科醫師檢視CT影像所需時間約需20分鐘,AI自動產出診斷報告只要10秒,而醫師覆核時間只要5分鐘,大大節省時間。而病理科醫師檢查全玻片影像,一般需要45到60分鐘,透過Patho CAM協助,AI偵測約10秒完成,醫師覆核只要20分鐘。

「Deep-Lung可以降低醫生偵測、診斷的時間,對經驗不足的中小型醫院來說,也能帶來相當大幫助」,陳震宇說。

臺大開發心臟主動脈鈣化、脂肪的AI分析模型

專注在心臟血管重大疾病的臺大團隊,結合臺灣大學及臺大醫院團隊,並和8個醫學中心聯手,運用8個醫學中心的去識別化CT電腦斷層影像,在心臟及放射科醫師標註心包膜、升降主動脈輪廓,經他們自行開發的Heaortnet神經網路,跨多個醫學中心CT設備進行聯合學習,開發心臟主動脈鈣化、脂肪的AI分析模型。

現場展示的心臟主動脈鈣化、脂肪的AI分析模型:

臺大醫院內科教授王宗道強調,心臟分割準確率達到94.2%,單一病例分析只需0.4秒,目前已應用在臺大醫院影像醫學部的輔助報告上。

該研究也運用健保署影像資料庫平臺,近3,000筆共10萬片CT影像在20分鐘內完成分析,以預測民眾的健康風險。臺大也和商之器合作開發桌上及行動App,預計在部立醫院使用。

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-10

2026-02-06

2026-02-10