民視

對新聞來說,適當利用3D動畫,可重現事件經過,也能呈現災害樣貌或古蹟外觀,帶給觀眾身歷其境的感受。民視在今年GTC大會上,揭露自家新聞3D動畫發展歷程,從最初利用遊戲引擎Lumion製作新聞動畫,像是2015年復興航空空難還原影片,進化到去年以遊戲引擎Unreal Engine串連達明機器手臂攝影機,靠自行撰寫的程式打造電視新聞實驗AR虛擬棚。今年,他們更導入觸控螢幕,開發一套獨門的AR觸控控制系統,讓主播可自行啟動AR物件。

打造新聞3D動畫,從遊戲引擎著手

民視新聞視覺創意團隊專案動畫師林耿暉指出,過去,新聞3D動畫常受限於算圖時間和流程,一直是製作新聞3D動畫的瓶頸。不過2014年時,團隊找到一款有效工具,也就是遊戲引擎Lumion,來製作新聞動畫。

當時,Lumion即以GPU資源來渲染畫面,且擅長擬真環境、材質、水文、天氣,還具豐富的資料庫,讓「使用者容易上手。」他也強調,Lumion快速算圖的優點,有利於製作時效性高的新聞動畫,他們也以此製作2015年復興航空235號班機空難的還原動畫,也用來發展風災與戰爭的模擬動畫。

這個經驗,讓民視團隊意識到GPU算圖的重要性,更讓團隊開始思考,即時算圖是否能應用於新聞虛擬棚。

接下來,2018年,團隊看上另一款操作自由度更高的遊戲動畫引擎Unreal Engine(簡稱UE),來取代原本的Lumion引擎。民事視創團隊指出,UE有幾個好處,像是可快速預覽、修正和算圖,而且,相較於同類型平臺,UE也更容易上手。此外,UE也支援電視臺常用的IO卡和編輯套件Composure。這些因素,也讓許多國際知名電視臺,都以UE來製作AR/VR應用。

而民視第一個採用UE的新聞專題,就是自家歷史節目臺灣演義中的橋頭事件。團隊利用UE來製作1979年戒嚴時期的高雄橋頭鄉場景,景中不乏舊式建築和穿著舊式服裝的群眾。團隊發現,UE能快速加入更多角色,也能更細緻地修正角色動畫。也因此,他們也以UE來打造臺灣演義的3D測試場景,將主播融入3D影像中。

在另一個採用UE的新聞專題馬祖通商史中,團隊除了運用UE的遊戲素材來呈現主題,比如武士刀、黃金、器皿和布疋外,還將主持人導入遊戲場景,成為首次類沉浸式虛擬實境(IMR)的測試。而另一個新聞專題臺灣鐵道旅館,則是系統效能負載測試的試煉石。

視創團隊指出,臺灣鐵道旅館屬日式建築,在1945年時遭美軍空襲炸毀,因此為重現當時建築場景,團隊除耗費心力考究史料外,還得建構大規模3D模型來呈現舊城樣貌,這測試了硬體效能的負載力。

UE加速IMR發展,建立新聞虛擬實境

視創團隊指出,IMR在新聞領域不算新鮮,但UE的出現,「大幅提高了場景擬真度,讓IMR在這幾年有所突破。」比如,國外知名天氣預報臺The Weather Channel就以UE,模擬出暴風雨場景並結合真人主播,來播報天氣新聞。

這意味著,虛擬場景能更加真實,真人主播也更能融入故事場景、與虛擬人物互動。對民視來說,這也是奠下未來電視智能棚的基礎。

在實際應用上,民視團隊在馬祖通史新聞專題中,將主播融入虛擬故事場景(如下圖),還與虛擬場景中的人物有微幅互動,比如做出禮讓手勢,讓碼頭搬運工人順利通過等。

另一個案例,則是臺灣鐵道旅館中的電梯和理髮廳場景。在電梯場景中,團隊整合了垂直上下的虛實動畫,將真人主播融入虛擬的電梯流籠場景,並從2樓下降至1樓。主播離開流籠前,還與虛擬運轉手點頭示意、互動。在理髮廳場景中,團隊以UE整合人物角色與場景,將真人主播融入虛擬場景,來敘述故事。

結合UE和機器手臂,自行撰寫程式打造實驗電視AR虛擬棚

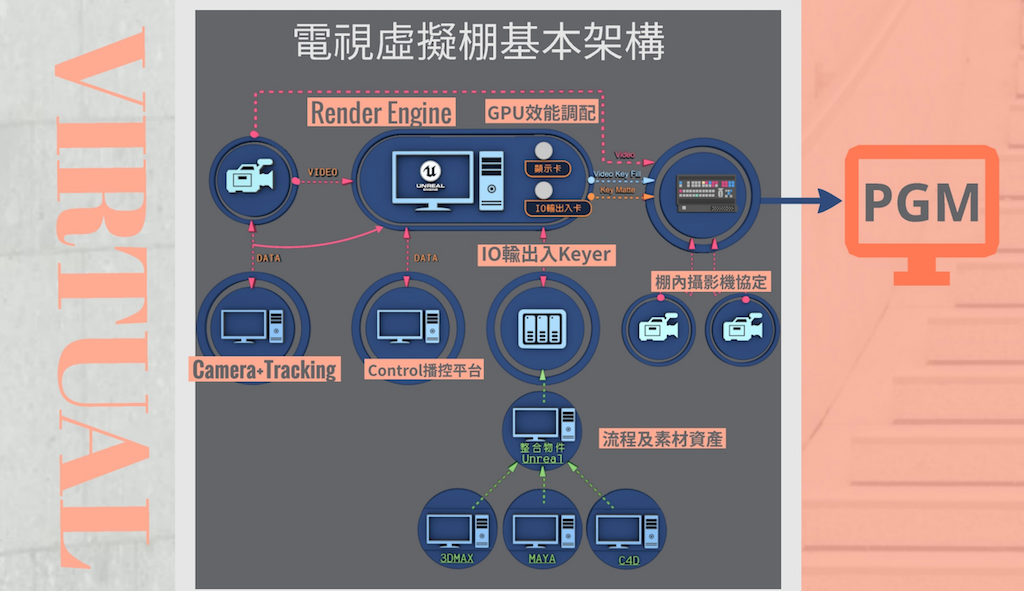

在這個基礎上,去年,民視導入了TM 12型號的6軸達明機器手臂,結合專用攝影機和UE,來發展AR電視虛擬棚。首先,電視虛擬棚在架構上,以工作站為核心,工作站包括了UE算圖引擎、GPU效能調配模組,以及IO輸出入口;

除了工作站,電視虛擬棚還涵蓋負責同步虛擬攝影機和棚內攝影機的Camera tracking模組、棚內多機作業的攝影機協定模組,以及傳輸攝影機訊號的IO輸出入Keyer。在Keyer之下,還串接了流程與素材管理模組,可細分為製作3D動畫的軟體Maya、3DMAX、C4D,並由UE統合(如下圖)。

為串接虛實攝影機(也就是機器手臂攝影機與UE攝影機),在操作上,可定義為三個加速X、Y、Z(即攝影機水平、垂直和前後移動)與三個角速度RX、RY、RZ(即攝影機上下搖擺、左右搖擺、順逆時鐘轉變等)。為連動虛實攝影機,民視團隊還自行編寫一套程式,來傳送手臂數據至UE,使UE中的虛擬攝影機能隨機器手臂攝影機移動。

為進一步精準對位,通常會採用數據包資料來校對,也就是攝影機定位參數。一般來說,專用攝影機會提供原廠數據包,但是,「達明機器手臂專用的攝影機,並未提供數據包,」因此,民視團隊得自行測量和網路搜尋,才找出關鍵的參數,比如鏡頭焦段、焦距轉換率、感光元件尺寸、鏡頭畸變等,才能同步定位虛實攝影機。

在硬體方面,民視採用的工作站是HP Z8 G4,具64GB記憶體、採英特爾Xeon Silver 4114CPU。團隊指出,工作站有兩個最重要的部分,就是GPU和IO卡。就GPU來說,民視使用過M4000、M6000、P5000,以及具48GB RAM的RTX 8000,甚至採用過遊戲顯卡如2080 Ti、Titan RTX等。

民視團隊也比較了3款GPU效能,也就是RTX 8000、2080 Ti和P5000。「就小場景而言,2080 Ti雖與RTX 8000有些差距,但CP值最高,」然而,一旦開啟IO capture、使用內部Keyer時,差距便明顯提升。團隊也指出,若處理大場景且使用光影追蹤(Ray-tracing),差距又更大了,「RTX 8000的穩定性最高。」

另一方面,就工作站中的IO輸出入卡來說,則負責將棚內實體攝影機的訊號,送至UE虛擬攝影機中。團隊嘗試了兩款IO卡,分別是接口數量較多的AJA Corvid 88和較少的AJA Kona 4,根據兩款合成方式的不同,又可分為內外Keyer。

團隊指出,內部Keyer是最理想的條件,因為可一條龍作業、不必仰賴外部合成,而且,「角色與虛擬物件場景能夠互動,」但缺點是耗引擎效能,也會增加延遲。

然而,機器手臂攝影機能否與棚內其他攝影機協作,也是一大考驗。視創團隊指出,為解決棚內攝影機的延遲和色差問題,他們以機器手臂攝影機為基準,來調校棚內其他攝影機。

另一方面,針對電視虛擬棚中的流程與素材管理,民視採跨平臺分工作業,比如動畫師以Maya或3DMAX先進行建模,而熟悉UE的成員,則可整合場景和各平臺的資訊,掌控整體模型完成度及其面數。

之後,開發團隊會將這些素材儲存,再利用自行撰寫的程式,來配合廣播錄影。

用AR虛擬棚打造2020大選觀測站,今年更納入觸控平板來操控AR物件

後來,民視團隊將達明機器手臂攝影機和UE,用於自家2020大選觀測站節目中,打造一套AR虛擬棚平臺。大選觀測站是民視獲得2018年亞洲電視獎的動畫節目,自2004年總統大選以來,就一直持續至今,而這次,團隊設計了兩個場景,也就是圓盤和柱狀投影(如下圖)。

此外,團隊也用這個方法,來呈現自家福爾摩沙音樂廳節目。團隊表示,有別於新聞播報,該音樂節目涉及大量文化傳統,團隊也依此建立許多具有臺灣文化的歷史物件,像是農村景象等,來襯托音樂會主題(如下圖)。

今年,民視更導入觸控平板,發展出一套AR觸控系統,讓主播或主持人可直接觸控來控制AR物件。他們也在棚內測試,以觸控螢幕來控制飛機、火箭和火車等虛擬物件的啟動(如下圖)。未來,團隊要以此再開發出更智能的電視虛擬棚。

熱門新聞

2026-02-09

2026-02-10

2026-02-06

2026-02-09

2026-02-10

2026-02-09

2026-02-10