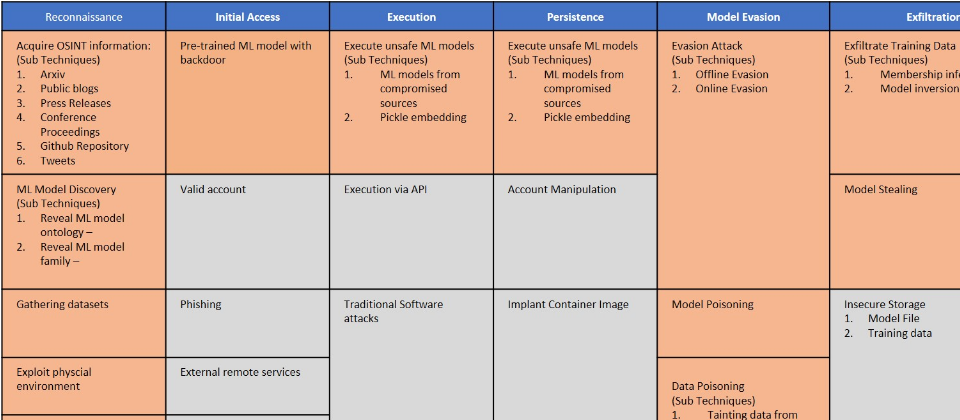

Adversarial ML Threat Matrix框架圖(局部示意),圖片來源/ramtherunner on https://github.com/mitre/advmlthreatmatrix/blob/master/images/AdvMLThreatMatrix.jpg

微軟與MITRE在本周釋出了Adversarial ML Threat Matrix開放框架,該框架蒐集了各種可用來攻擊機器學習(ML)系統的安全漏洞與對抗性行為,以供研究分析師評估這些惡意行為並找出因應之道,確保未來ML系統的安全性。

MITRE為一接受美國各個政府組織贊助的非營利研發機構,曾釋出ATT&CK知識庫,集結了在全球所觀察到的各種對抗性手法與技術,並供全球存取,而Adversarial ML Threat Matrix的架構則類似ATT&CK,只是把主題從傳統的攻擊行動轉為針對ML系統的攻擊行動。

除了微軟與MITRE外,還有其它11個組織也對Adversarial ML Threat Matrix作出了貢獻,包括IBM、Nvidia與Bosch等。

MITRE實驗室總經理Charles Clancy表示,人們既歡迎卻又擔心人工智慧(AI),AI無庸置疑地加速了各種應用的發展,但在IoT裝置結合機器學習之後,一定會帶來某些風險,不管是系統故障,或是遭到攻擊,都可能對AI帶來重大破壞,然而,他相信AI的風險經常被高估,因為AI通常不會是造成關鍵基礎設施損害的頭號殺手,例如電網中最危險的對手其實是啃食電線的松鼠,但AI同樣也能引起駭客的覬覦。

事實上,在最近的3年內,不管是Google、Amazon、微軟或特斯拉(Tesla)的ML系統都曾受騙或被誤導,而且此一趨勢只會日益升溫。例如Gartner就曾預估,2022年的網路攻擊將有30%來自於資料投毒、模型竊盜及對抗性樣本。此外,微軟調查了28個各種規模的組織,發現有25個組織完全不知如何防護他們的ML系統。

因此,Adversarial ML Threat Matrix框架中收納了各種針對ML系統的攻擊行為,從偵察、存取、執行、持續、模型逃避、匯出資料,到可能造成的影響等,以供分析人員在AI尚未普及之前作好安全準備。

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-12

2026-02-10

2026-02-06