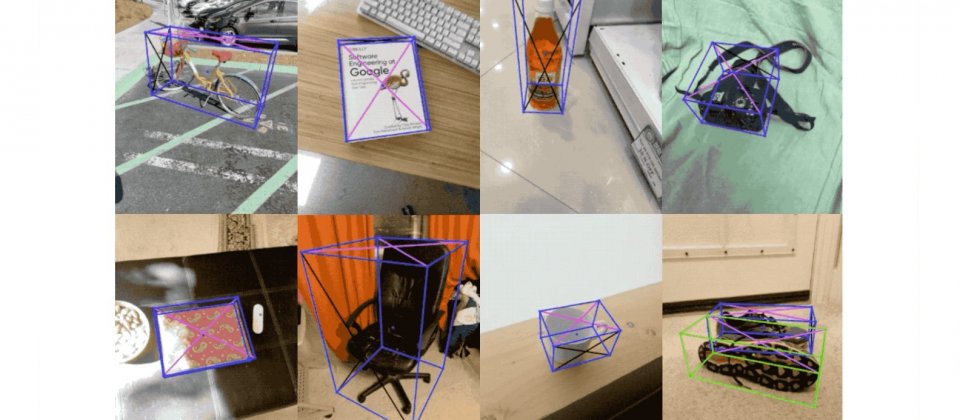

Google釋出最新的Objectron資料集,這是一個從不同角度,拍攝大量日常物體的影片集合,影片的特色是長度短,且物體總是位於中央,每個影片片段包含AR對話元資料,像是相機的位置以及稀疏點雲,還有由人工標記的3D定界框(Bounding Box),以描述物體的位置、朝向和維度。

利用許多照片資料來訓練機器學習模型,可使電腦視覺功能的表現越來越好,但Google提到,相較於目前應用在2D任務的影像資料集,例如ImageNet、COCO和Open Images,真實世界3D物體資料集仍不足,使得運用機器學習模型理解3D物體,仍是一項具有挑戰性的任務。

因此Google發布了Objectron資料集,來補充不足的3D物體資料集,該資料集收集多角度拍攝物體影片,可以捕捉物體更多的3D結構之外,也提供方便用於諸如影片和攝影機串流等,電腦視覺任務的資料格式,有助於機器學習模型的訓練以及建立基準。

Objectron資料集總共有1.5萬個註解影片片段,並且有400萬張註解圖片作為補充,圖片內容包括腳踏車、書、瓶子、照相機、穀物盒、椅子、杯子、筆電和鞋子。為了確保資料集的多樣性,資料集內容來自5大洲10個國家。

除了釋出Objectron資料集,Google還在MediaPipe中釋出,可用來偵測4類物體的3D物體偵測模型,包括鞋子、椅子、杯子和照相機,這些模型是利用Objectron資料集訓練而成。MediaPipe是Google跨平臺可客製化機器學習解決方案框架,能用來處理即時和串流媒體,開發諸如裝置上虹膜或是姿勢追蹤等應用。

與Google之前發布的單階段Objectron模型不同,這些新版的模型採用雙階段基礎架構,第一階段應用TensorFlow物件偵測模型,來找出模型的2D剪裁,進到第二階段,使用圖像剪裁來估算3D定界框,並同時為下一個影格計算2D剪裁,Google提到,這個新方法不需要在每一個影格,都執行物體偵測器,使得效能更好,在Adreno 650行動GPU上,能夠以83 FPS的速度執行。

熱門新聞

2026-02-13

2026-02-13

2026-02-13

2026-02-13

2026-02-13