歷經7年的發展,AWS已自行研發IT基礎架構必備的多種運算晶片,供自家使用,這當中包含了:提升效能與安全性的Nitro,提供成本更低執行個體服務的Graviton,加速機器學習處理的Inferentia、Trainium。

關於運算型態的公有雲服務提供,AWS的EC2發展至今已長達14年之久,每年新推出的執行個體(instance)服務,往往反映了當時的運算技術發展重點,而在今年的全球用戶大會上,AWS基於他們自行設計的矽晶片,以及其他廠商最新發表的中央處理器(CPU)、圖形處理器(GPU),也發表新的執行個體服務。

舉例來說,AWS去年發表他們設計的Arm架構處理器Graviton2,以及採用這個運算技術的多個執行個體,像是一般用途類型的M6g與M6gd,運算密集型C6g與C6gd,記憶體密集型R6g與R6gd,而在今年年中,這些服務都已陸續上線提供。而在12月,AWS宣布推出新的執行個體C6gn,搭配100 Gbps網路連線效能。

在x86架構處理器的部分,AWS在今年12月,基於英特爾第二代Xeon Scalable處理器,發表M5zn、D3/D3en、R5b等3套執行個體服務。其中的M5zn,屬於一般用途的執行個體,主要特色是可針對單緒執行提供最高效能,處理核心運作時脈可達到4.5GHz;針對儲存應用的D3/D3en,可搭配相當巨大的硬碟儲存容量,單臺執行個體最大可配置336TB;R5b屬於可搭配大量記憶體的執行個體服務系列,與區塊儲存EBS之間的存取頻寬,最大可達到60Gbps,並且提供26萬IOPS的儲存效能,以此支援超大型資料庫工作負載。

關於搭配圖形處理器的執行個體服務,AWS基於AMD Radeon Pro V520的圖形處理器,以及AMD第二代EPYC處理器,在12月推出G4ad,可針對圖形處理密集型應用,提供更理想的性價比。

推出多款自行設計的晶片,支援高效能與低成本的應用需求

在2013年,AWS開始研發第一代Nitro晶片,到了2015年,他們併購晶片製造商Annapurna Labs,於是,AWS除了持續發展Nitro硬體系統架構,也開始研發Arm架構晶片Graviton。2017年AWS正式公開Nitro系統架構,2018年11月發表基於Graviton的執行個體服務A1,以及機器學習推論晶片Inferentia。

Graviton提供性價比更高的通用運算

在2019年底,AWS基於第二代Graviton晶片,推出支援Arm架構的執行個體服務,像是:M6g、C6g、R6g,以及搭配NVMe SSD的C6gd、M6gd、R6gd,強調相較於x86架構的執行個體服務,性價比更好(提升40%)。

今年AWS在自研晶片的應用上,又有哪些進展?5月M6g正式推出,6月C6g與R6g上市,7月M6gd、C6gd、R6gd也開始提供。9月,AWS宣布推出另一個Arm執行個體服務T4g,支援效能需求爆漲型(Burstable Performance)負載,可在短時間內迅速提供大量運算能力。

在12月初的全球用戶大會期間,AWS又發表可搭配100Gbps超大網路頻寬的C6gn,預計將於稍後正式推出。而且,C6gn沿襲了AWS現有Arm架構執行個體服務的特色,以及效能成本效益,但擁有更大的網路頻寬(M6g、C6g、R6g最大可配置25Gbps)。

在此之前,他們原本就有強調網路最佳化用途的執行個體服務,如M5n、C5n、R5n,可支援網路密集型工作負載,例如,防火牆、路由器、負載平衡、視訊轉碼、資料分析等應用需求,讓用戶可運用超大型的頻寬吞吐量,以及封包傳輸效能,執行這些網路處理。但這些執行個體的最大封包傳輸率都面臨局限,用戶甚至需啟動多個執行個體,才能得到更大封包傳輸效能。

而即將問世的C6gn,不僅與M5n、C5n、R5n一樣,用戶可選擇配置100 Gbps的執行個體,與區塊儲存服務EBS之間的頻寬,可提供到38 Gbps(M5n、C5n、R5n最高可提供19,000 Mbps)。另外,在封包傳輸效能上,相較於上述執行個體服務,C6gn可再提升40%。

AWS設計了基於Arm架構的處理器Graviton,目前他們運用第二代晶片,也就是Graviton 2,推出了多個執行個體服務,可分別針對一般用途、記憶體密集型、運算密集型、超大型網路頻寬,以及效能暴漲等使用情境。

Inferentia提供低成本推論加速應用

在2018年11月,AWS發表自行設計的Inferentia硬體運算晶片,每顆晶片可提供數百TFLOPS的運算效能,搭配這款晶片的單個執行個體,可提供數千TFLOPS的運算效能。

隔年12月,他們基於這顆晶片,推出用於機器學習推論的執行個體服務Inf1,可提供2000 TOPS的運算效能,並強調這是市面上最便宜的機器學習推論執行個體。相較於搭配GPU的G4執行個體,Inf1可提供3倍的推論處理吞吐量,以及減少4成的單位推論成本,至於單顆Inferentia晶片的運算效能,他們則表明是128 TOPS(INT8),以及64TOPS(FP16、BF16混合精度)。

而在組態配置與部署方式上,用戶可選擇搭配1個、4個或16個Inferentia晶片的Inf1執行個體,而且可搭配AWS專為深度學習所整合的AMI軟體映像使用。這些映像內含當時剛推出的AWS Neuron SDK,這套軟體開發套件提供多種指令,IT人員可藉此在Inferentia編譯、調校、執行機器學習模型

AWS也預告,可在多種代管服務裡面搭配使用Inf1,像是專攻機器學習應用的SageMaker,以及Kubernetes代管服務、EKS容器調度服務ECS。

到了今年,上述三個代管服務陸續支援Inf1。9月AWS宣布兩個自家案例。

首先,就是母公司Amazon的Alexa語音助理應用服務團隊,已將大量基於GPU的機器學習推論工作負載(80%的語音回應處理作業),遷移到Inf1。

他們得到了哪些成效?AWS表示,各層面的延遲度降低25%,若單就文字轉語音的工作負載而言,以GPU執行個體為基準,改用Inf1後,成本降低30%。

另一個採用Inf1的案例,是AWS的圖片與影片辨識服務Rekognition。執行物體分類這種機器學習模型時,若以交由GPU執行個體來處理為基準,改用Inf1後,延遲度降至1/8,吞吐量提升1倍

關於Inferentia的硬體設計架構,AWS今年也首度透露更多細節。他們表示,每顆Inferentia晶片包含4個名為NeuronCore的核心,而每個核心實作脈動陣列(systolic array)矩陣乘法引擎,可大幅提升卷積、變形這類典型深度學習處理的速度。

Trainium鎖定機器學習訓練應用需求

今年AWS全球用戶大會期間,該公司執行長Andy Jassy宣布,他們將在2021年推出另一款硬體晶片,名為Trainium,專門用於機器學習的訓練,他們希望在雲端服務環境當中,提供更具成本效益的訓練應用,可針對任何機器學習執行個體,提供TFLOPS等級的處理效能。

而在軟體搭配的部份,Trainium能支援TensorFlow、PyTorch、MXNet等深度學習框架,並可繼續採行原本專用於Inferentia的軟體開發套件Neuron。

至於結合雲端服務供應的形式上,AWS預計將在EC2提供搭配這套機器學習訓練晶片的執行個體,或是在SageMaker裡面提供。

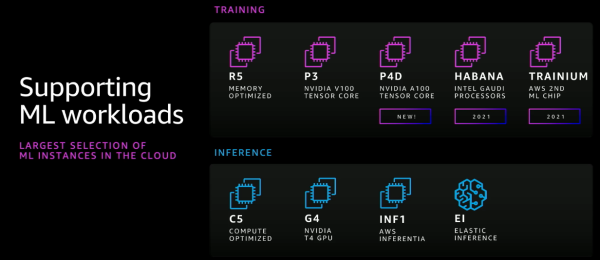

針對機器學習的應用需求,AWS提供多種執行個體服務,除了搭配英特爾的中央處理器,以及Nvidia的圖形處理器,他們也採用自行研發的加速晶片Inferentia,以及明年即將推出的Trainium。

熱門新聞

2026-02-11

2026-02-12

2026-02-11

2026-02-10

2026-02-09

2026-02-13

2026-02-10