Google在開發者大會Google I/O 2021上,發表了最新的對話AI模型LaMDA(Language Model for Dialogue Applications),官方提到,這是一個非常複雜的語言模型,比當前所有模型,在理解對話上下文方面的能力都還要好。

Google在語言處理耕耘已久,從早期的網頁翻譯功能,到最近應用機器學習技術,以更好地了解用戶的查詢意圖。但語言表達非常的細緻,除了字面上的意思,許多時候還包括象徵意義,並且具有平鋪直敘、詞藻華美,或是僅提供資訊的實用性用途,Google提到,這些多樣的語言特性,使其成為電腦科學的一大難題。

而Google最新發展的LaMDA技術,能夠更好地克服這些問題,特別是在語言處理的對話應用上。官方表示,雖然對話都是從特定主題展開,但是由於對話的開放性,即便從同一個話題開始,卻會在完全不同的話題上結束。與朋友聊天話題可能從電視節目,一路聊到拍攝的國家,甚至是該國的美食。

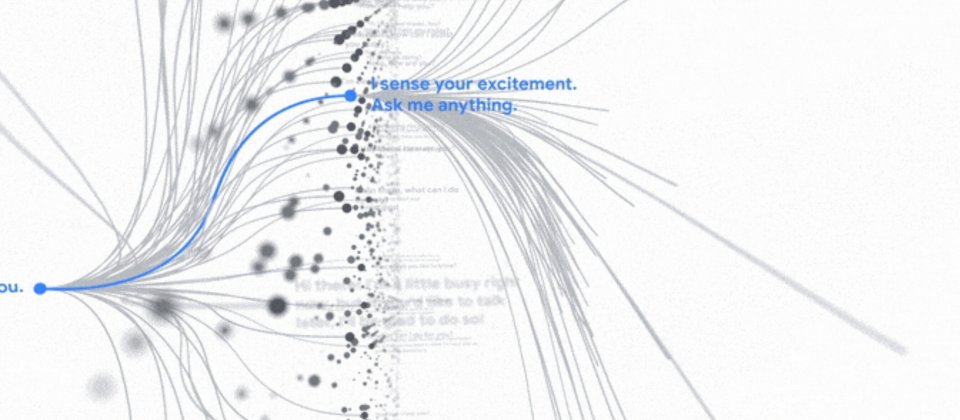

Google認為漫談的品質,是當前聊天機器人處理對話的困難之一,因為這些機器人的對話,傾向遵循狹隘且單調的預定義路徑發展。而最新的這個LaMDA語言模型,能以自由流動的方式,處理無數個主題,Google認為,該技術可以提供更自然的互動能力,並且開啟應用程式更多的可能性。

LaMDA對話技術已經發展許久,如同BERT和GPT-3等語言模型,LaMDA也是以Transformer為基礎建構。Transformer是由Google研究院在2017年所發明,並且開源的神經網路基礎架構,該架構能夠生成一種特別的模型,可被訓練來讀取單詞,並且關注單詞間的關聯,甚至是預測緊接在單詞之後的字詞。

但與大多數語言模型不同的是,LaMDA特別接受了對話訓練,在訓練過程,LaMDA學習開放式對話與其他語言應用之間的細微差別,Google提到,對話不只要是合情合理,如果符合談話上下文的回應,就會更有意義。Google以「我剛剛開始上吉他課」對話為例,合理的回應包括「那很好」和「我不知道」,在語義上都沒有問題,但如果能夠回應「太令人興奮了吧!我媽也很喜歡彈奏他的老吉他」,透過明確地回應與對話上下文有關的內容,可讓回應不只合理並且更具體。

LaMDA是建立於Google在2020年所發布的早期研究基礎上,研究顯示,透過對話訓練的Transformer語言模型,可以學會談論任何內容,並且經過訓練,還能微調LaMDA,提高該模型在回應內容上的敏感度和具體性。

除了在LaMDA的初期結果,研究團隊追求合理且具體的回應之外,Google還希望LaMDA可以回答更有趣、出乎意料甚至是機智的內容,而且Google也想讓LaMDA更關注事實,確保LaMDA的回應不只吸引人而且正確。官方也提到,語言模型可能內化歧視、複製仇很言論,甚至散布誤導性訊息,即便是經過仔細審查的語言模型,仍可能被濫用。

Google在創建LaMDA的同時,便試著減少這些可能的風險,除了開源研究之外,研究人員也對LaMDA開發的每一個步驟進行審查,避免在將LaMDA應用到產品中時,發生機器學習模型可能出現的問題。

熱門新聞

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-09

2026-02-10

2026-02-09