Google和導盲犬學校Guiding Eyes for the Blind公司合作,發布了一個無障礙研究專案Project Guideline,該專案使用機器學習技術,引導視障者在有標線的馬路上獨自慢跑。Guideline系統需要用戶使用特別訂製的腰帶配掛行動裝置,搭配骨傳導耳機,並且只能跑在有油漆或是貼有膠帶的路徑上。

Guideline的核心技術是裝置上分割模型,該模型會使用行動裝置影格作為輸入,並將影格中的每個畫素分割為標線或是非標線(下圖),官方提到,這個簡單的遮罩會應用到每一個影格中,供Guideline應用程式可以不需位置資料,就能夠預測跑步者相對於路徑上標線的位置。使用模型的預測資料,應用程式會向跑步者發送音訊,指引他們保持在直線上,一旦跑步者遠離標線太多,系統也會透過聲音警告跑步者。

.png)

在不可預測的環境中,要引導視障者跑步存在許多挑戰,Google提到,系統必須具備足夠的準確性、系統效能,還要有許多訓練資料。由於視障者的行動能力受到限制,在馬路上跑步存在危險性,機器學習模型要足夠精確且通用,才能確保跑步者在不同位置,和各種環境條件的安全性。

除了用戶的安全問題,系統效能還必須至少每秒處理15影格,才能對跑步者提供即時回饋,當跑步的路徑沒有資料服務就只能離線運作,且裝置執行時間必須至少3小時,不能耗盡手機電池。Google提到,為了訓練分割模型,需要用到大量包含標線的道路行進影片,而且為了使模型更加通用,資料多樣性和豐富度都相當重要,必須要收集一天中不同時間、光照、天氣條件和拍攝位置的影片。

由於要滿足延遲和功耗要求,研究人員選擇在DeepLabv3框架上建構標線分割模型,並且利用MobilenetV3-Small作為主幹。考量到行動裝置的處理速度,研究人員將攝影鏡頭影片畫素下降到513x513,作為DeepLab分割模型的輸入,且為了要進一步加速DeepLab模型在裝置上的執行速度,研究人員決定略過最後的升採樣層,直接輸出65x65畫素的預測遮罩,作為後處理的輸入。藉由在兩階段最佳化輸入解析度,研究人員得以改進分割模型執行,並且加速後處理。

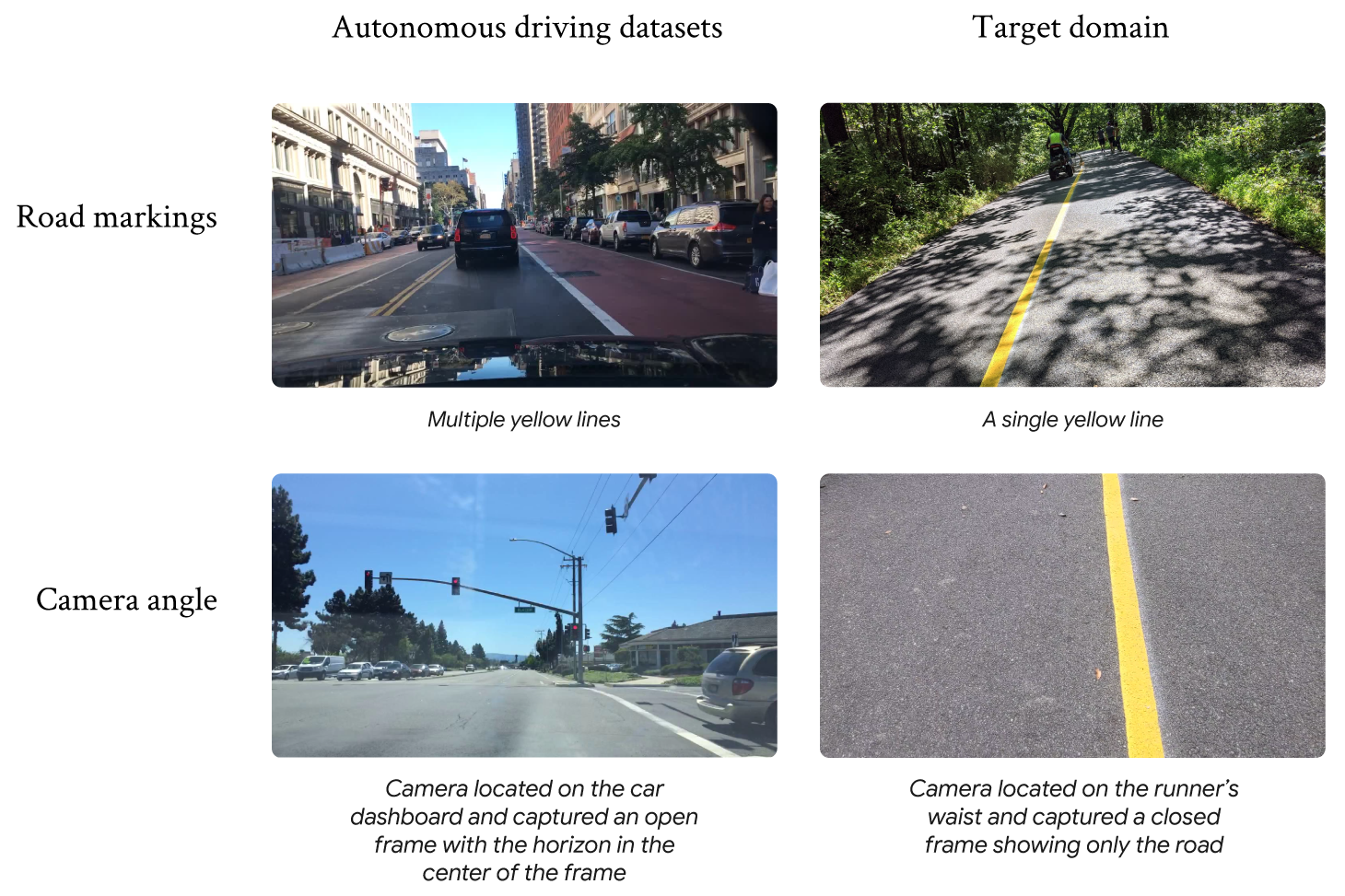

收集訓練資料是Project Guideline專案困難之處,研究人員解釋(下圖),訓練資料之所以無法使用公開資料集的道路訓練影像,是因為這些資料集都是在車頂安裝攝影鏡頭,並且車輛駕駛在標線中間所拍攝的影片,這與Project Guideline專案需求差距甚遠,該專案需要的訓練資料,是要在人的腰間掛上攝影機,並且直線前進的影片。

現有的公開資料集都幫不上忙,因此研究人員只好重頭開始創建資料集,以人工收集資料的方法,在道路上手動鋪設膠帶,拍攝在不同時間和天氣條件下,行走於標線周圍的影片,研究人員也建立自定義渲染工作管線,以合成的方式快速產出各種條件的訓練資料。

端到端系統使用深度學習函式庫Tensorflow Lite和機器學習工具ML Kit,可在Pixel裝置上快速執行,Pixel 4 XL上達到29+ FPS,而在Pixel 5上則達到20+ FPS,分割模型在Pixel 4 XL延遲為6毫秒,Pixel 5則為12毫秒,模型的影格成功率達到99.5%,平均交併比(mIOU)則有93%。

Guiding Eyes for the Blind執行長Thomas Panek作為Project Guideline測試者,只使用了一副骨傳導耳機和執行Guideline技術的行動電話,在無輔助的情況下,成功在紐約中央公園慢跑5公里。Google提到,現在該專案仍處於探索階段,他們仍持續改善該系統,除了要收集更多的使用者回饋資料外,也要改進分割模型使其更加通用強健。

熱門新聞

2026-02-09

2026-02-10

2026-02-06

2026-02-09

2026-02-10

2026-02-10

2026-02-10

2026-02-09