Nvidia推出TensorRT 8,這是最新的人工智慧軟體開發工具包,能加速搜尋引擎、廣告推薦、聊天機器人等人工智慧應用,官方提到,與之前的版本相比,TensorRT 8可縮短一半的語言查詢推理時間。

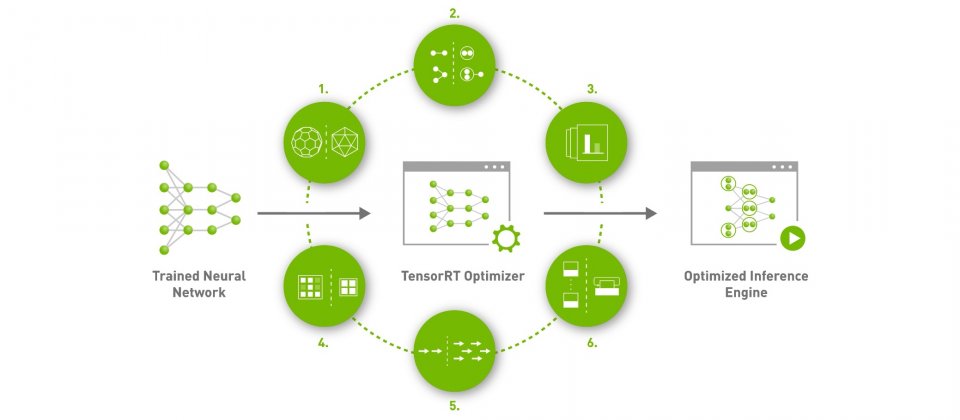

TensorRT是一個包含推理最佳化器和Runtime的高效能深度學習推理SDK,能夠提供低延遲和高吞吐量的運算,TensorRT廣泛支援各個產業,像是醫療保健、金融服務與製造業等。官方提到,以TensorRT作為基礎的應用程式,推理速度比純CPU平臺快了40倍,而在TensorRT 8中,又針對熱門的Transformer模型最佳化。

TensorRT 8加速了所有基於Transformer模型的對話式人工智慧,使推理時間縮短為TensorRT 7的一半,使用A100 GPU運算,執行具有3.4億個參數的語言模型BERT-Large,其推理延遲能降低到僅剩1.2毫秒。

這個TensorRT新版本的更新重點,除了能加速語言模型,在使用Quantization Aware Training時,使用INT8精度就能夠實現相當於FP32的準確度。另外,稀疏性是Ampere架構GPU的一種效能技術,而在TensorRT 8中,可以利用這項技術減少運算操作,以大幅提高效率。

熱門新聞

2026-02-11

2026-02-09

2026-02-11

2026-02-10

2026-02-10

2026-02-06

2026-02-10

2026-02-10

Advertisement