Nvidia自2017年開始,就在GTC大會上啟用I am AI人工智慧旁白,來說明議程或技術。直到去年上半年,團隊開發出一套更細緻的AI語音生成系統,終於讓AI旁白聽起來更像富有感情的真人。

Nvidia

前陣子,Nvidia才揭露今年GTC大會上的創辦人黃仁勳演講,有14秒是「虛擬的」。最近,Nvidia應用深度學習研究部門副總裁Bryan Catanzaro親自上線說明,GTC大會中穿插的旁白,也大多是虛擬合成的聲音。

他盤點了近年來Nvidia對話式AI的成果,像是輕量語音合成模型、高效能語音分析模型、降噪模型、語音資料集,其中,語音合成模型不只能細緻地呈現音高、腔調和節奏,還能轉換聲音。這是Nvidia首次公開揭露語音合成技術進展。

GTC大會上穿插的AI旁白

自2017年開始,Nvidia就在GTC大會上啟用AI語音旁白I am AI,來介紹大會議程或技術應用。不過,剛啟用的那幾年,AI旁白還是有著生硬的機器人口音。

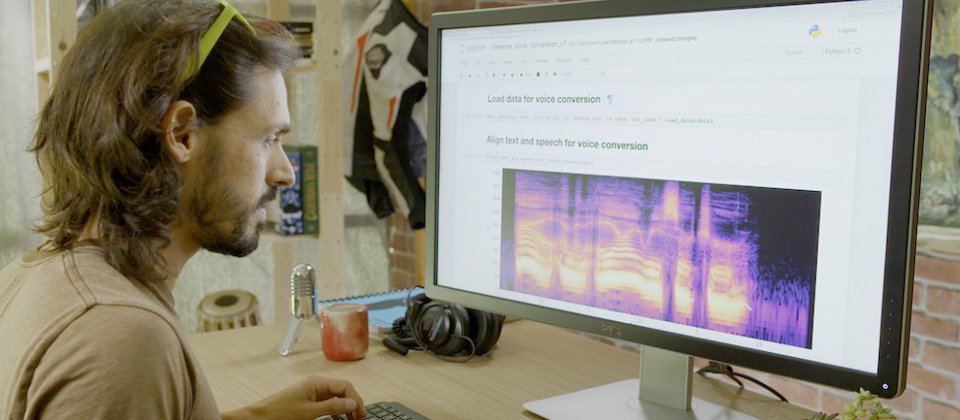

直到2020年上半年,Nvidia研究團隊成功打造出AI語音合成系統Flowtron,才一改機器人的生硬口音,變得更像一個有感情的真人。Flowtron中有套關鍵的文字轉語音模型RAD-TTS,不只能產生語音,還能轉換語音風格。在設計過程中,團隊借鏡了語音合成中的重要技術自迴歸流(Autoregressive Flow)概念,並以此改善Google發表的經典語音合成模型Tacotron,來提高語音合成品質。

比如,RAD-TTS能更好地控制音高、音調、語速、節奏和口音,甚至能轉換聲音。也就是說,畫面上雖然是A男說話(甚至是唱歌),但AI能立即轉換為B女的聲音,而且栩栩如生保留了A男說話的腔調、節奏和速度等特徵。

如此一來,使用者可錄製自己讀出的影片腳本,再用Flowtron將說話內容改變為不同性別的聲音。此外,使用者也可透過系統調整合成語音,來強調特定字眼或放慢節奏,搭配影片調性。Bryan Catanzaro指出,這個AI模型不只用於配音,還能用在遊戲、協助語言機能障礙者理解,甚至能以使用者自己的聲音,翻譯成不同語言。

不只是AI旁白,Nvidia對話式AI研究還聚焦多種領域

不過,AI旁白只是Nvidia對話式AI研究領域的一部分。

Bryan Catanzaro表示,Nvidia這幾年來鑽研對話式AI,包括自動語音辨識(ASR)、音訊增強和降噪、文字轉語音、語音合成、音檔壓縮,甚至是相關資料集的建置、語音合成技術的分支文本正規化(Text normalization)以及建模技術。

他舉例,研究團隊訓練一套輕量級語音生成模型TalkNet 2,參數量只有1,300萬,不到時下SOTA模型的二分之一,但因採非自迴歸架構,能快速訓練、準確發音,適合用於嵌入式語音生成的應用場景。

另一個例子則是逆向文本正規化。文本正規化是ASR中不可或缺的技術環節,它將語音辨識結果轉換為文字,來提高ASR輸出值的可讀性。但傳統方法對文法錯誤的容忍度相當低,於是,Nvidia設計一套開源Python WFST函式庫,來改善這個問題,同時還能用在語音轉文字任務。

另一方面,Nvidia也建置訓練語音生成AI所需的資料集,包括高傳真英語TTS資料集、5,000小時且完整格式化的金融語音資料集。

除了技術研究,Nvidia也推出不少語音相關工具,其一就是GPU加速的開源對話式AI工具包NeMo,能讓使用者快速微調、試驗語音模型。NeMo具備API和預訓練模型,能用來進行文字轉語音、自然語言處理和自動語音辨識等任務,而這些預訓練模型,大多已在Nvidia DGX專用系統上進行超過十萬小時訓練,使用者在Nvidia Tensor核心GPU上微調即可。

另一方面,Nvidia也與Mozilla聯手,建置世界上最大的開源語音資料集Common Voice,包含橫跨數十種語言共1萬3,000小時的群眾外包語音資料,已於7月底釋出。Nvidia也用這些資料訓練NeMo,並免費提供給全球使用者利用。

Bryan Catanzaro坦言,這是Nvidia第一次揭露對話式AI研究進展,也是首次將這些成果,發表在最近舉行的INTERSPEECH國際學術會議上。

熱門新聞

2026-02-06

2026-02-06

2026-02-06

2026-02-06

2026-02-09

2026-02-09

2026-02-09