4種Grace伺服器參考設計,包括CGX、OVX、HGX及整合Hopper GPU的全新HGX,對應雲端遊戲及繪圖、Digital Twins與Omniverse、高效能運算、AI訓練及推論。

Nvidia

Nvidia去年揭露旗下首款資料中心CPU,採用Arm架構的Grace CPU後,在今年Computex上發表了Grace伺服器參考設計,將聯合多家伺服器品牌及代工業者,在明年上半年推出採用Grace的運算系統。此外,還推出液冷式A100 GPU,將液冷技術推向主流GPU市場。

去年GTC,Nvidia擴大資料中心布局,揭露將發展CPU、GPU、DPU三種運算技術的戰略,以擴大對支援愈來愈多人工智慧應用的新型態資料中心布局,除了GPU與DPU之外,在CPU方面受外界注目的是,Nvidia首款資料中心CPU,採用Arm架構設計的Grace,強調專為超大規模AI及高效能運算所設計,可帶來TB級的資料處理量。

Grace支援第4代NVLink互連技術,讓CPU與GPU間可以每秒900GB的速度互連,並支援LPDDR5X記憶體,帶來更高的容量、頻寬及能源效率。官方稱,配備Grace CPU的DGX,和現今的DGX相比提升5倍效能。

今年Computex電腦展,Nvidia揭露更多Grace CPU資訊。Grace將包括兩種產品規格,兩種規格設計均支援Nvidia的軟體堆疊及平臺,包括Nvidia AI和Omniverse。一種是專為大規模人工智慧及高效能運算設計的Grace-Hopper的CPU與GPU規格,以NVLink-C2C作為CPU與GPU間的快速互連,每秒可達900GB的速度;另一種規格是Grace CPU Superchip,以NVLink-C2C互連兩顆Grace CPU,提供144個Arm v9核心與每秒1TB的記憶體頻寬,鎖定高效能及雲端運算。

同時,該公司也公布4種伺服器系統的參考設計,CGX、OVX、HGX(Grace)及全新的HGX,針對單路、兩路、4路不同的系統設計,分別對應雲端繪圖及遊戲、Digital Twins及Omniverse、高效能運算、AI訓練推論及高效能運算。

前三種參考設計採用Grace CPU Superchip,搭配A16或Nvidia GPU,以及Bluefield-3,第四種的HGX參考設計則採用Grace-Hopper Superchip規格,搭配Bluefield-3,以及OEM自定的I/O或是第4代NVLink互連技術。

Nvidia表示,目前已有多家伺服器業者計畫推出產品,包括華碩、富士康工業互連網、技嘉、雲達、緯穎、Supermicro,準在2023年上半年推出數十款伺服器。 Nvidia將繼續在伺服器投入X86與Arm架構伺服器,提供企業不同的選擇。

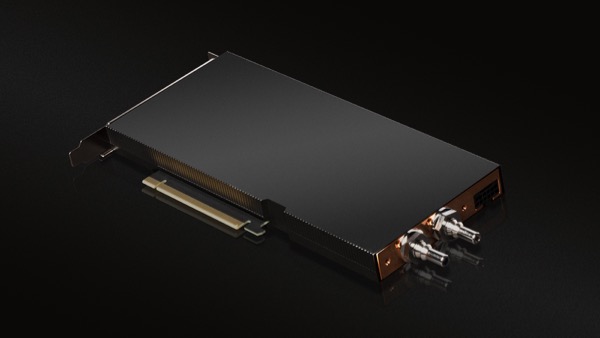

推出液冷式GPU

趕上全球節能減碳的趨勢,資料中心節能成為企業的減碳淨零的目標之一,Nvidia也發表液體冷卻的Nvidia A100 PCIe GPU,為主流GPU中首款液冷產品。Nvidia表示,液冷將是Nvidia GPU加速運算發展的下一步,其AI推論和高效能運算效能比CPU提升20 倍。Nvidia目前已開始提供樣品給客戶,預計在今年夏天上市。

Nvidia已和資料中心業者Equinix合作測試液冷GPU產品,並表示和傳統氣冷技術相比,使用液冷技術可減少約3成的能源消耗,進而降低資料中心的PUE值,預估可達到1.15,低於採用氣冷技術資料中心的平均1.6。另外,由於液冷式的Nvidia A100只使用1個PCIe插槽,代表能提供更高的密度。

包括華碩、永擎電子、富士康工業互聯網、技嘉、英業達、雲達、Supermicro等業者,計畫推出Nvidia液冷式GPU。

A100之後,Nvidia透露明年液冷技術將擴大至採用Hopper架構的H100 Tensor核心GPU。未來也會擴展至高效能運算資料中心的GPU及HGX平臺。

熱門新聞

2026-02-11

2026-02-11

2026-02-12

2026-02-09

2026-02-10

2026-02-10

2026-02-06