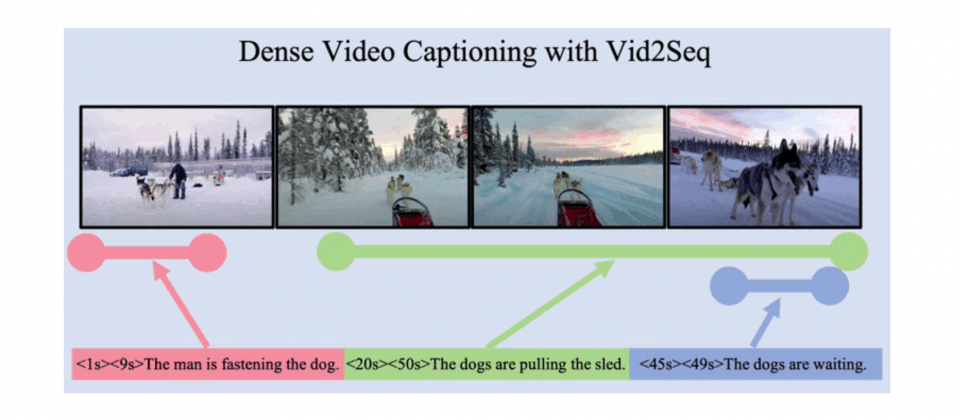

無論是娛樂、教育還是商業等領域,影片都是內容傳遞的一個重要媒介,以人工智慧理解影片內容,則能進一步擴大內容的傳遞,而Google新發表的預訓練視覺模型Vid2Seq,則是一個新型的視覺語言模型,能夠生成密集影片說明(Dense Video Captioning),標記影片中的多個事件邊界,並生成相對應的文字內容說明。

研究人員解釋,要人工智慧理解影片,生成密集影片說明並非一件簡單的工作,因為影片通常包含不同時間尺度發生的多個事件。研究人員以雪橇犬拉雪橇的影片為例,影片中便會包含狗拉雪橇這個長事件,還有狗被拴在雪橇上這個短事件。

所謂的密集影片說明,與單一圖片說明或是標準影片說明不同,密集影片說明是針對影片中的事件所產生的說明,因此事件與事件的時間軸可能會交疊,而傳統標準影片說明則是以單一語句描述一段影片的內容。密集影片說明能夠支援多種應用,包括可協助視障與聽障人士了解影片內容,也能夠自動產生影片章節,或是改進大型資料庫中的影片時間軸搜尋功能。

目前密集影片說明都還停留在,用於處理高度專業化任務的階段,因此要整合到基礎模型存在一些障礙,而且過去這些模型使用手動註釋的資料集訓練,因此也難以擴展。Google新發表的預訓練視覺模型Vid2Seq,則能生成事件說明和時間的單一密集影片說明序列。

Vid2Seq的架構組成為一個視覺編碼器和一個文字編碼器,以分別執行編碼影片影格,以及轉錄語音輸入兩項工作,這些編碼會被輸入到文字解碼器中,自動回歸預測密集事件說明序列在影片中的時間。

手動收集密集影片說明的註釋成本高昂,因此研究人員選擇使用未標記的口說影片預訓練Vid2Seq模型,像是YT-Temporal-1B這類資料集,便比手動註釋的資料集相對容易取得。研究人員使用口說影片資料集的方式,是將轉錄語音的句子邊界當作虛擬事件(Pseudo-event)的邊界,並且以轉錄的語音句子作為虛擬事件的說明。Vid2Seq使用數百萬個口說影片訓練,在YouCook2、ViTT和ActivityNet Captions等密集影片說明基準測試,達到目前模型的最佳表現(下圖)。

.png)

研究人員提到,Vid2Seq也能夠很好的泛化,應用到僅有少數鏡頭的密集影片說明任務,或是影片段落說明任務,甚至也能用於標準影片說明任務中。

熱門新聞

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-10

2026-02-10

2026-02-10