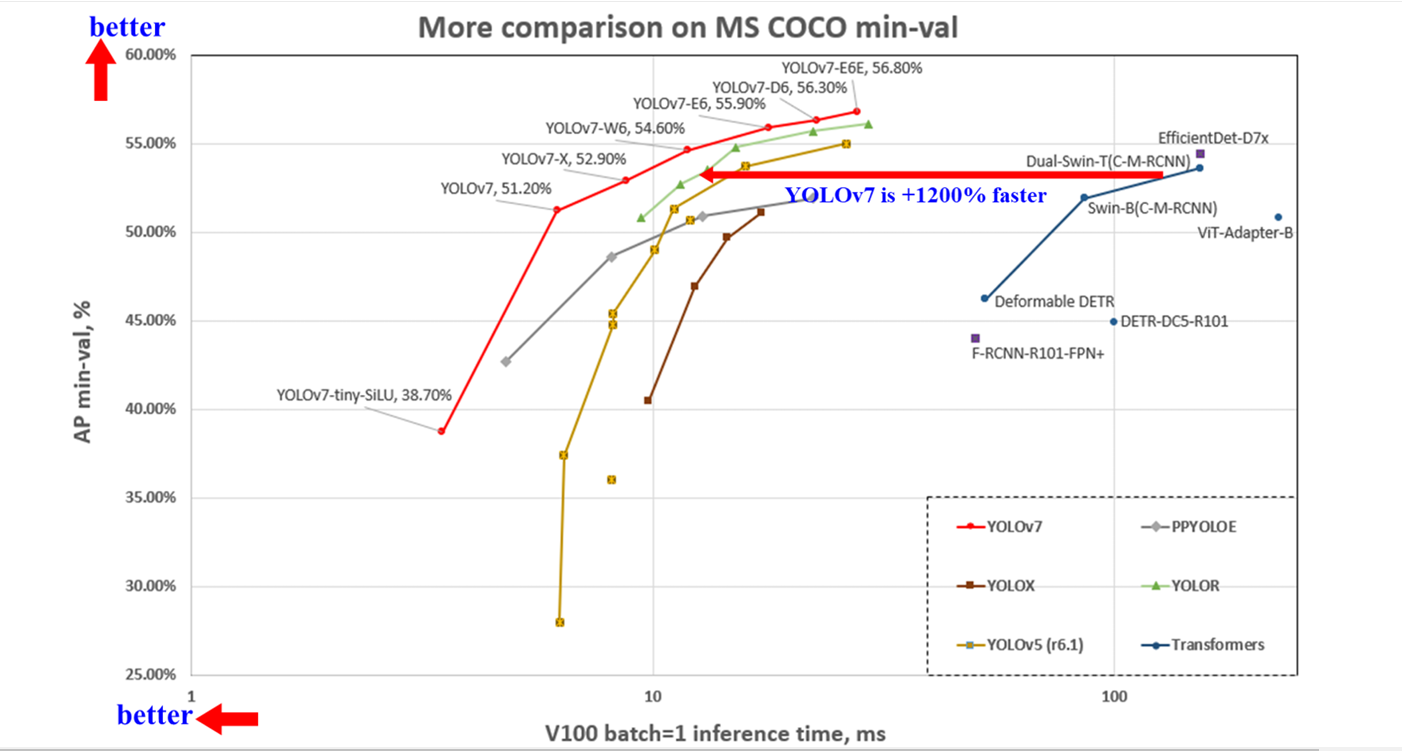

中研院團隊將YOLOv7與另一主流電腦視覺架構Transformer評比。結果顯示,不論速度還是準確度,YOLOv7皆優於Transformer系列模型。(圖片來源/王建堯)

就在2020年,臺灣催生出世界第一物件偵測模型YOLOv4,完勝當時各大科技巨頭打造的物件偵測AI,也將臺灣推向世界級電腦視覺技術研發重鎮行列。2年後,YOLOv4原班團隊中研院資訊所所長廖弘源與中研院資訊所助研究員王建堯推出另一物件偵測新作YOLOv7,去年7月正式登場,再次擊敗當時各大SOTA模型。

這一次,團隊同樣研發新技術和新策略,來設計這套模型。這包括更輕巧更有效率的網路架構ELAN、多任務模型YOLOR,以及特殊優化的訓練策略Trainable bag-of-freebies。

這些新技術跳脫傳統機器學習思維,各有突破,互相加成之下,使YOLOv7更輕、更快,也更準確,還能執行多種任務,如物件偵測、實例分割和關節點偵測,是少數兼具輕巧與多任務特色的電腦視覺模型,更與近來崛起的多模態多任務AI趨勢不謀而合。

開發經驗連點成線,從物件偵測到多任務

中研院團隊過去的開發經驗,催生出這些技術創新,而這些技術創新,也揭示下一步走向。

2017年,臺灣開始推動AI產業化、產業AI化,當時的科技部(現國科會)提出「業界出題、學界解題」AI計畫,來媒合產學雙方,用AI解決產業問題。當時,中研院團隊與義隆電子媒合,制定出2018年至2021年解題目標,要在4年計畫中打造又輕又快又準確的物件偵測模型,好部署在道路監視器上,發展智慧交通應用。

身為解題核心成員的廖弘源與王建堯,先是在2018年以ResNet為基礎,改良學習策略,發展出局部殘差網路(PRN),來進行影像辨識。PRN雖比YOLOv3快兩倍,但準確度略遜YOLOv3,為此,團隊隔年打造出跨階段局部網路(CSPNet),改善卷積網路梯度消失問題、解決學習效率不佳原因,並增加梯度組合、最大化梯度多元性,提高網路學習能力。

也因為CSPNet,YOLO Darknet框架維護者Alexey Bochkovskiy與中研院團隊牽上線,共同改良CSPNet,於2020年發表YOLOv4,在同年MSCOCO物件偵測競賽中,拿下全球第一。

那時起,中研院團隊將目光從物件偵測轉向另一領域,挑戰難度更高的單一模型多任務方法,要通吃各大電腦視覺任務。於是,中研院團隊往2方向同時前進,一是設計輕量網路架構,他們同樣從梯度來改良,以梯度路徑分析方法讓模型更好地學習特徵,跳脫傳統機器學習特徵工程思維,並在2020年11月開發出ELAN。另一方向則是多任務表徵學習方法,透過設計一個能保存所有輸入資料特徵的統一網路,來實現一心多用,並在隔年5月發表成果模型YOLOR,一登場就在國際競賽奪下實戰成果。

這2大技術,再加上改良的模型訓練策略,團隊整合發展出YOLOv7,不論速度、準確度,都超越當時的主流網路架構,包括卷積網路(CNN)和Transformer類模型,以及熱門物件偵測模型如YOLOR、YOLOX、Scaled-YOLOv4、YOLOv5,和Transformer類的DETR、Deformable DETR、DINO-5scale-R50、ViT-Adapter-B等。

可以說,第七代模型集結了中研院YOLO團隊數年來的開發結晶,不僅有過往訓練策略優化的影子,也有新穎的單一模型多任務方法。

這個多任務元素,更與時下AI圈發展趨勢吻合,同時點出團隊接下來的發展焦點。他們下一步將繼續朝單一模型多任務領域前進,但也瞄準知識圖譜和圖神經網路,要來輔助模型執行多任務,並以此打造更安全的模型。因為,擅長處理關係網路的圖神經網路和知識圖譜,能幫助拆分AI黑盒子,將問題拆解為更細的子問題,協助開發者推導出問題所在,解釋決策原因。

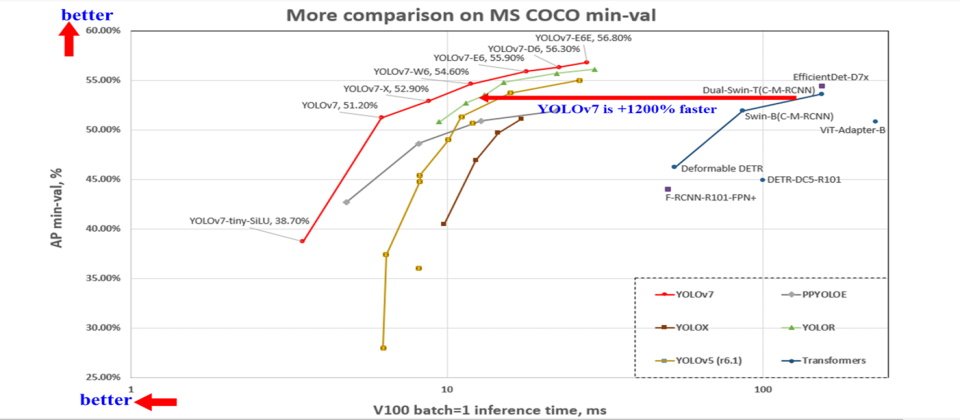

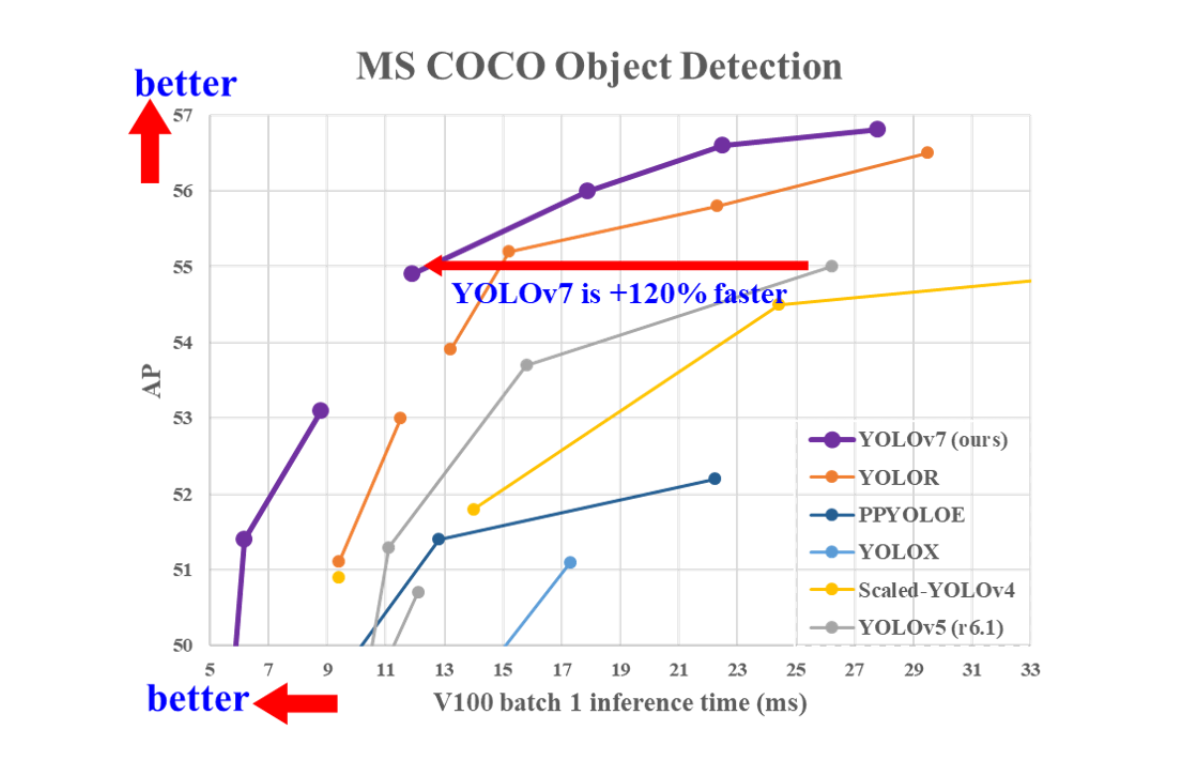

開發物件偵測模型YOLOv7的中研院團隊以MSCOCO資料集測試YOLOv7與其他SOTA模型效能,發現不論是推論速度還是準確度,YOLOv7都比其他模型好,甚至比YOLOv5快上1.2倍。圖片來源/王建堯

不只與YOLO系列模型比較,中研院團隊也將YOLOv7與另一主流電腦視覺架構Transformer評比。結果顯示,不論速度還是準確度,YOLOv7一樣優於Transformer系列模型。圖片來源/王建堯

兼顧研發和部署生態圈,推動AIoT發展

中研院團隊開發的YOLOv7,不只有新技術的突破,發展策略也有很大的變革,更聚焦生態圈的布局,改用主流開發框架PyTorch開發,並自建轉換器,同時支援Darknet框架版本,滿足開發與部署需求。

以前,團隊開發第四版時,仍舊沿用YOLO系列模型慣用的Darknet框架來開發。因為許多邊緣裝置的主要語言為C,所以,Darknet開發者也慣用C++和CUDA語言,方便將物件偵測模型部署到邊緣裝置上。但是以Python語言為主的PyTorch框架,使用者族群龐大,更是先進技術開發者優先使用的框架之一。

因此,中研院團隊這次決定同時支援2種框架,不只因應不同生態,也因應未來的技術發展相容性。

甚至,第七代模型的精簡架構改變,還能降低AIoT應用門檻,讓物件偵測AIoT更普及,一如產學AI計畫的初衷。這是因為,AI模型設計越精簡、使用的運算單元越簡單,對晶片設計的要求也就越簡單。這意味著,運算資源有限的低階設備或邊緣裝置,也可以部署輕巧精準的AI模型,企業不必砸重本客製化晶片,也能擴大AIoT的使用。這個架構簡單的模型,不但不需大量硬體運算資源,還能成為節能的新選擇,呼應淨零排碳趨勢。

在這次專題中,進一步分別從技術面和生態圈兩大面向,來介紹臺灣團隊再一次打造出世界冠軍物件偵測模型背後的成功關鍵。

冠軍模型研發里程碑

2018年 中研院團隊以ResNet為基礎,改良學習策略,打造局部殘差網路PRN

2019年 修正梯度消失問題,發表跨階段局部網路CSPNet

2020年 以CSPNet為基礎,發表物件偵測模型YOLOv4,拿下世界第一;同年打造高效率網路ELAN

2021年 發表多任務模型YOLOR

2022年 整合ELAN、YOLOR與新訓練策略,發表YOLOv7

2023年 持續研究單一模型多任務方法,包括藉助知識圖譜與圖神經網路

資料來源:中研院,iThome整理,2023年3月

熱門新聞

2026-02-11

2026-02-12

2026-02-11

2026-02-10

2026-02-09

2026-02-13

2026-02-10