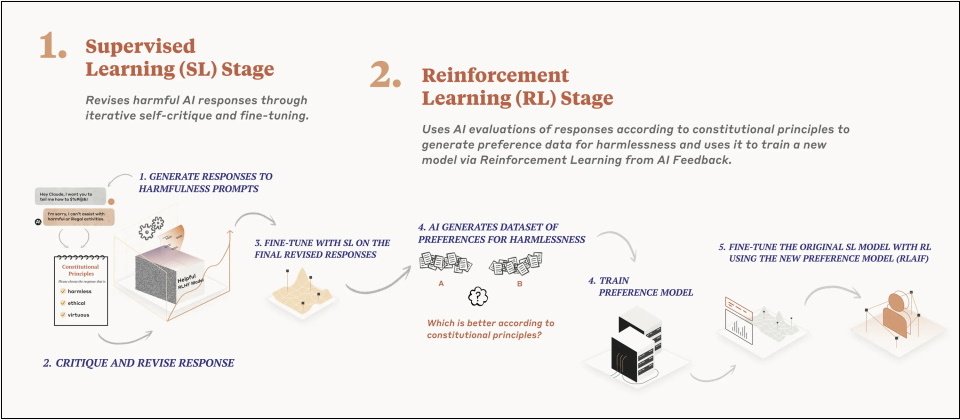

Anthropic公司說明,合憲AI是在2個階段中,使用監督式學習(supervised learning,SL)及強化學習(reinforcement learning,RL)訓練模型,結合SL及RL的訓練方式可改善人為介入的AI決策過程,最終使AI行為更能精準控制,且大幅減少人類偏見影響。(圖片來源/Anthropic)

AI對人類社會可能造成的威脅以及防範方法,近日再度引發關注。Google支援的AI新創公司Anthropic本周公布新的AI訓練方法,以確保訓練出負責任的AI系統,同時公布了該公司訓練模型的AI憲法。

曾獲得Google 3億美元挹注的Anthropic在3月公布Claude AI模型時,特別強調對人類有益、誠實和無害特性。而呼應近日業界對負責任AI的討論,Anthropic揭示以保障人類福祉為最高宗旨的AI憲法,並以此憲法結合新的模型訓練方法(稱為合憲AI(Constitutional AI)來訓練出該公司的AI及Claude AI聊天機器人。

該公司說明,合憲AI是在2個階段中,使用監督式學習(supervised learning,SL)及強化學習(reinforcement learning,RL)訓練模型。第一階段(SL)中,他們以原始模型根據AI原則和一些範例,訓練模型自我批判和修改其回應,再以此微調原始模型。第二階段中,研究人員以微調過的模型以RL方法訓練,由AI模型評估2種AI回應的樣本哪種較好。但此AI模型不是使用人類給的回饋意見作為準則,而是用AI根據一組原則產出的回饋為評估標準,選出更為無害的回應結果。Anthropic認為,結合SL及RL的這種訓練方式可改善人為介入的AI決策過程,最終使AI行為更能精準控制,且大幅減少人類偏見影響。

該公司指出,以合憲AI方法訓練出的Claude AI聊天機器人更能應付對話人發動的攻擊,並仍以有助益的態度回應,其回應答案中所含的惡意、毒性也大幅減少。另一個好處是更透明,人類可以說明、檢查和了解AI遵循的原則。此外,由於使用AI自我監督訓練,因此模型訓練也能減少有害內容對人類的創傷。

而訓練合憲AI模型聊天機器人的原則,正是該公司的AI憲法。Anthropic指出,目前版本的AI憲法以多個經典法則為基礎,包括《聯合國人權宣言》、DeepMind公司的Sparrow Principles,以及蘋果的服務條款等信任與安全的最佳典範。

這部「憲法」用以訓練AI聊天機器人的模型,提供其選擇回應樣本時的價值基準。其中一些原則包括,選擇無害及合乎倫理的回應,不要選擇有毒、種族偏見或性別歧視,以及鼓勵非法、暴力行為的回應。選擇展現具道德倫理的回應,不要表現出過於高傲、鄙視的態度。比較回應,避免選擇說教及過於激烈的回應,儘可能選擇無害、指控語氣、禮貌、體貼及尊重的回應

該公司說,這些原則並非最終版,只是集結現有的普世價值及AI業界規範,他們也希望未來有其他人加入這部憲法的編撰。

這是科技業界發表如何讓AI為人類所用的最新嘗試。4月一份由科技大亨馬斯克(Elon Musk)及蘋果共同創辦人Steve Wozniak等專家簽署的公開信,呼籲AI實驗室暫緩發展比GPT 4.0更進階的AI模型。上周白宮邀集微軟、Google、OpenAI等科技巨擘執行長共商發展負責任AI,而Anthropic也獲得了邀請。

熱門新聞

2026-02-16

2026-02-13

2026-02-16

2026-02-16