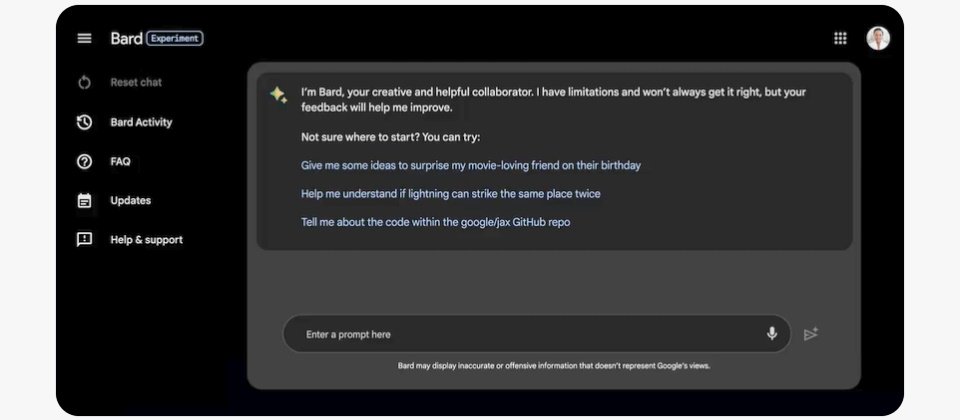

AI聊天機器人可提高生產力,但也引發資料外洩疑慮,《路透社》報導,就連開發Bard的Google母公司Alphabet也提醒員工在公司要小心使用。

報導引述消息人士指出,Alphabet近日對內發布AI使用規範,提醒員工不要將機密文件內容輸入聊天機器人,以免造成公司資訊外洩。此外,即使Google不久前為其Bard加入程式碼檢查、抓臭蟲的功能,消息人士指出,Alphabet新規範也警告其工程師,不得直接使用AI聊天機器人產生的程式碼。

Alphabet官方指出,雖然Bard有時建議的不是開發人員想要的程式碼,但卻也提高了他們的工作效率。該公司也清楚表達,他們不會隱瞞其聊天機器人的技術限制,也會明確告知使用者可能的風險。

Alphabet的新政策並不令人意外。輸入AI聊天機器人的公司資料都會成為開發廠商訓練底層AI模型的資料集,可能造成資料外洩。不少知名企業已發布企業內AI聊天機器人使用指引,包括三星、Amazon、德意志銀行等,其中三星曾發生員工將公司開發專案的程式碼輸入ChatGPT的事件。

此外,不正確的結果輸出,更是AI一大隱憂。生成性AI聊天機器人包括Google Bard、ChatGPT及微軟Bing Chat都被報導過AI幻覺(hallucination)問題,但使用者往往無法判斷或察覺,例如曾有律師不慎將ChatGPT捏造的判例用於法庭文件。安全廠商甚至發現,AI幻覺產出不存在的程式碼、套件庫或下載網頁,反而給了攻擊者製造惡意網站或程式加以頂替,由聊天機器人建議給使用者。

熱門新聞

2026-02-11

2026-02-12

2026-02-11

2026-02-10

2026-02-09

2026-02-13

2026-02-10