蘋果

蘋果為建立AR空間運算開發的生態系積極展開布局,其中一個關鍵策略就是整合現有的開發工具和資源,全面提升對於新AR平臺應用的支援能力,不只是旗下IDE開發平臺Xcode,就連眾多iOS行動開發者熟悉的開發工具或框架,現在也可以用於visionOS平臺應用的開發,讓他們更容易利用這些框架或工具在明年設備上市前,開始構建新的AR應用,或者測試現有行動應用程式在蘋果AR頭戴設備上的轉換效果。此外,蘋果還釋出visionOS的軟體開發工具套件(SDK),加快開發者的採用和測試。

在這些行動應用開發工具或框架中,SwiftUI是開發iOS和iPadOS應用程式主要的介面開發框架,SwiftUI現在也支援空間運算平臺,意味著,開發者可以使用SwiftUI來建立能夠支援空間運算的三維介面。不論是設計應用程式的按鈕、切換和TabView等UI元素,還是開發影音和瀏覽器應用程式(如TV或Safari),或是建立3D數位白板和沉浸式簡報功能,都能夠利用SwiftUI的功能來完成。

不僅如此,在SwiftUI中,還提供了全新的3D功能,方便開發者在介面視窗中增加深度效果或3D物件,例如增加具有體積感的Volume視窗,使應用程式的視窗看起來不再是平面,而是具有3D幾何的立體感。SwiftUI還提供了混合、漸進式和完全沉浸式三種不同風格的場景類型,開發者能夠根據應用需求來選擇適合的沉浸程度,並能夠直接預覽和檢視UI介面在沉浸式空間的效果。

在UI設計配置上,SwiftUI提供了一個名為z-index view modifier的全新功能,該功能可以讓開發者為UI元素增加深度上的細節變化,使得視覺上具有深度感。原本用來建立圖層分層的ZStack,現在可以建立更複雜的層次關系,營造出類似於3D效果的深度外觀。

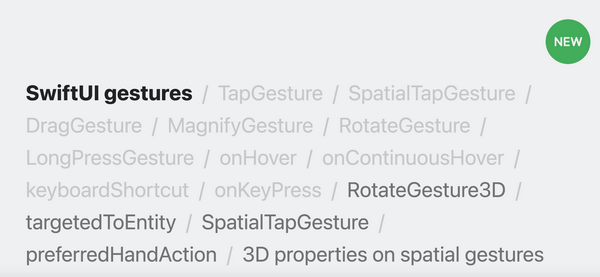

由於在空間運算世界中,眼睛和手勢是主要的應用程式或UI操作方式,因此,在SwiftUI中,除了原有的手勢輸入模式(如TapGesture或DragGesture)之外,還提供了一種新方法,來與三維空間中的3D物件互動,讓開發者可以利用這種新手勢與他們的應用程式結合,提供更多元的互動體驗。RotateGesture3D就是其中一個例子,這個新手勢可以讓使用者使用雙手或觸控板來旋轉三維空間中的物件。

不只能使用SwiftUI框架開發,行動開發者還能利用UIKit框架中新的空間API,設計和開發支援三維介面的AR功能。

RealityKit新API支援更逼真的3D模型模擬和渲染效果

除了支援三維使用者介面,蘋果目前行動開發工具或框架中也有包含了AR或空間運算開發相關工具,其中包括了RealityKit與ARKit兩大AR框架。

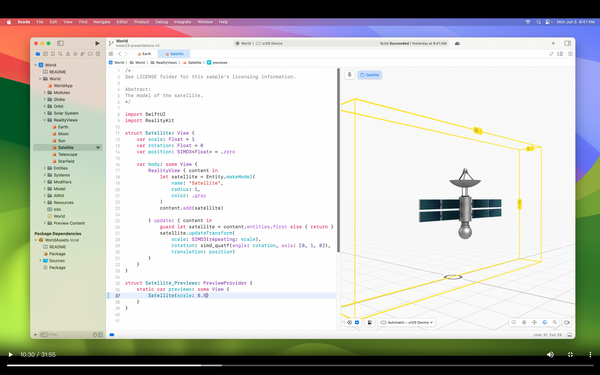

尤其,RealityKit在AR應用程式開發中具有關鍵作用。RealityKit是蘋果於2019年推出的AR擴增實境框架,提供強大的3D模擬和渲染功能,開發者現在可以在visionOS平臺上使用RealityKit模擬和渲染應用程式中的3D內容,讓3D內容呈現更真實,更貼近使用者所處的環境。

為了提高AR應用程式的沉浸式體驗,RealityKit增加不少新功能,例如推出名為Model3D的新API,讓開發者能使用這個API在SwiftUI的應用程式中嵌入各種逼真的3D模型,並支援了USDZ與Reality檔案格式。RealityKit還推出全新的沉浸式渲染器RealityRender,使3D模型在環境中呈現更真實、生動。還有新推出的RealityView功能,則是可以讓開發者在SwiftUI中檢視用RealityKit製作的各種3D模擬場景或內容。如果要展示渲染後的3D圖形的效果,也能夠使用ARView工具來完成。

為了提高AR應用程式的沉浸式體驗,RealityKit增加不少新功能,例如推出名為Model3D的新API,讓開發者能使用這個API在SwiftUI的應用程式中嵌入各種逼真的3D模型,並支援了USDZ與Reality檔案格式。圖片來源_蘋果

RealityKit與SwiftUI整合也更加緊密,開發者現在可以利用RealityKit API來渲染介面,在SwiftUI中建立具有更強烈空間感的UI介面,例如可以改變背景材質增加視覺感,或是加入hover懸停效果或裝飾性UI等視覺元素,呈現更加逼真立體的外觀輪廓,進一步貼近使用者周圍環境的真實質感。

大多數虛擬物件會使用RealityKit工具來建立3D物件的物理材質,來呈現真實世界的材質。RealityKit使用外部感測器數據,提供真實世界的照明狀態等資訊並融入到這些材料中。

更強大ARKit工具現身,能在真實環境呈現複雜3D場景並互動

蘋果還有一個名為ARKit的AR開發工具,比RealityKit更早2年推出。與用於3D內容模擬和渲染的RealityKit用途有所不同,ARKit則是蘋果用來實現應用程式中的3D內容與使用者周圍環境互動的關鍵。透過LiDAR光達掃描器,ARKit能夠快速而準確地捕捉周圍環境的深度資訊,提供更精準的幾何場景定位和物件放置,讓開發者可以建立與真實環境高度互動的AR體驗。

ARKit針對visionOS平臺推出了一系列追蹤及感測新功能,來增強AR互動體驗,包括平面評估功能,可以根據真實環境水平位置檢測數據,準確放置虛擬物件,還有場景建構功能,用來重建真實場景的3D模型,以及提供圖像錨點和實體世界追蹤機制,可以在真實圖像錨點上附加媒體內容,或是讓虛擬內容可以根據用戶在現實世界中位置和移動方向來進行配置。

蘋果還因此在ARKit中推出名為DataProvider的新協定,可以即時更新真實環境中的數據,讓開發者能夠設計出根據實際環境的變化,來調整應用程式與周邊環境的互動方式,例如,將球彈跳到地板上或水濺到牆璧的效果。

在全沉浸模式中,ARKit的API還提供了更多與環境互動的操作,例如,只要經過用戶同意後,開發者就可以透過手勢追蹤來獲得使用者手部詳細資訊,進而在畫面中呈現使用者的虛擬手部模型,使其能夠與周圍環境或應用程式進行互動。

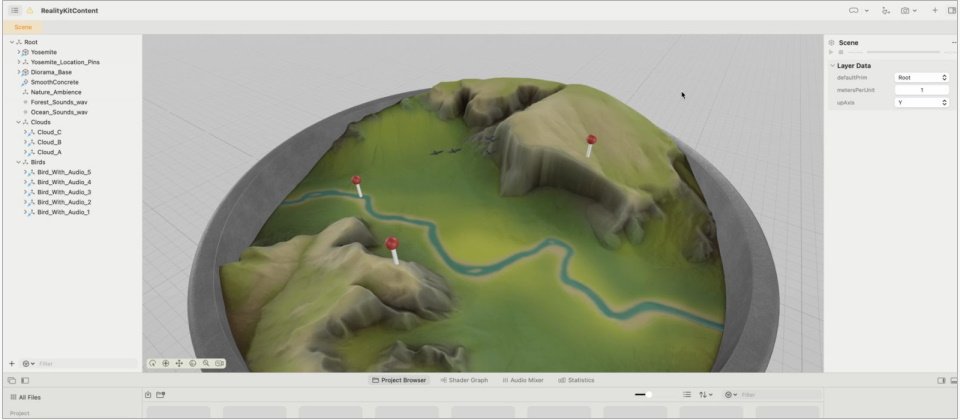

為了簡化AR應用程式開發流程,蘋果推出一個全新視覺化工具平臺,稱作Reality Composer Pro,能將開發者利用ARKit和RealityKit工具建立的各種3D場景、物件、環境互動體驗統一集中管理,除了能夠在visionOS中預覽這些場景視覺或沉浸效果,也能進行3D內容創作和編輯。圖片來源_蘋果

全新視覺化工具平臺推出,簡化AR應用程式開發流程

為了簡化AR應用程式開發流程,蘋果推出一個全新視覺化工具平臺,稱作Reality Composer Pro,可以協助開發者準備AR App需要使用的各種3D內容,還提供預覽功能,能夠將這些3D內容整合到一個AR場景中來觀看。

此外,Reality Composer Pro還提供創作、編輯功能,能用來建立和編修AR應用程式所需的各種3D物件、動畫,還提供材質客製化的功能,透過MaterialX開放標準,就能使用關聯式節點圖來設計出想要的物理材質,不需要撰寫任何程式,就可以立即看到輸出的效果。

.png)

Reality Composer Pro有提供材質客製化的功能,透過MaterialX開放標準,就能使用關聯式節點圖來設計出想要的物理材質,不需要撰寫任何程式,就可以立即看到輸出的效果。圖片來源_蘋果

又如在Reality Composer Pro工作流程中,開發者能使用RealityKit工具的particles粒子功能在場景中迅速模擬雲朵、雨或火花效果,還可以將音訊加入到場景中,與其他3D物件相關聯,也能夠及時預覽,並能夠進一步配合場景中內容修改,組合出更複雜且規模更大的互動場景。

Reality Composer Pro也與Xcode緊密結合,可以像在Xcode中構建和執行程式碼一樣,很容易進行3D內容編修與預覽,如調整場景大小或將其旋轉,來從不同角度觀看。

熱門新聞

2026-02-11

2026-02-11

2026-02-12

2026-02-09

2026-02-10

2026-02-10

2026-02-06