AMD執行長蘇姿丰在舊金山現場親自展示新款資料中心GPU加速器,鎖定生成式AI的Instinct MI300X。

AMD

AMD更新資料中心產品布局,最高128核心EPYC處理器搶攻高密度雲原生需求,新款GPU攻生成式AI市場(上)

【舊金山現場直擊】隨著AI應用興起,AI或機器學習模型在資料中心訓練、推論需求增加,以及ChatGPT生成式AI更帶動新的AI浪潮,背後需要大量的運算資料,提高資料中心內的AI加速運算。

Nvidia在HPC高效能運算、AI運算耕耘已久,看準生成式AI運算市場,今年稍早發表生成式AI運算引擎DGX GH200,採用Grace Hopper加速卡。

外界也期待AMD如何端出牛肉與其競爭AI市場。6月在美國舊金山發表會中,AMD執行長蘇姿丰指出,全球資料中心AI加速運算規模還只是開始,市場商機仍在成長之中,她相信資料中心的AI加速運算總規模,將從現在300億美元,成長到2027年超過1500億美元。

AMD在AI的3大策略,首先是旗下高效能CPU、GPU產品,從資料中心、邊緣運算到智慧終端裝置具備AI訓練或推論的能力,其次是結合開源、經驗證的軟體平臺,讓硬體更容易被部署及使用,最後是和AI產業的夥伴的合作及共同創新,來深化生態系發展。

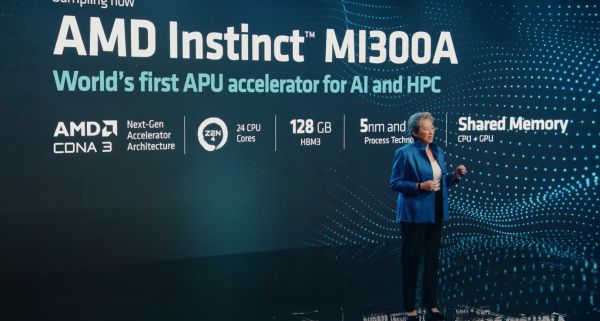

在產品部分,AMD正式發表了新的資料中心GPU產品Instinct MI300系列,和前一代採用CDNA 2 GPU架構的Insinct MI200系列不同,MI300系列採用CDNA 3架構,包括APU架構的MI300A,另一款MI300X強調專為生成式AI設計,頗有和Nvidia互別苗頭的意味。

在新的MI300系列中,MI300A為AMD首款資料中心APU,過去AMD在PC個人運算導入APU已有好幾年時間,MI300A將APU帶到資料中心市場,MI300A內含1,400億電晶體,鎖定AI及HPC運算,支援第4代AMD Infinity 3D封裝技術,包括24個Zen 4 CPU核心,混合GPU核心。

MI300A支援128GB的HBM3記憶體,在效能表現上,比先前的Instinct MI250提升8倍的效能,在能源效率方面也提升5倍。MI300A已開始送樣。德國Max Planck Society計畫打造的超級電腦Atos,已準備採用第4代EPYC處理器及MI300加速器,應用在天文物理、AI、生命科學、材料等研究。

MI300X同樣為CDNA 3 GPU架構,針對LLM大型語言模型、生成式AI計算所需要的更高計算能力、記憶體資料吞吐效率,MI300X最高可支援192GB HBM3記憶體,記憶體頻寬可達每秒5.2TB,若搭配AMD Infinity fabric,記憶體頻寬可達每秒896GB,更大的記憶體容量、更高記憶體頻寬,使得MI300X得以支援大型語言模型。MI300X預計在第3季送樣。

AMD也現場展示400億個參數的Falcon-40B,能夠安裝在一個MI300X加速器的系統中執行,蘇姿丰表示,MI300X最高可支援800億個參數的LLM。同時,她也不忘拿競爭對手作比較,以MI300X和Nvidia H100相比,MI300X在HBM密度上高於對手1.4倍,記憶體頻寬則是1.6倍。更大容量的記憶體、更高的記憶體頻寬,意謂執行LLM推論需要更少的GPU,降低生成式AI加速的TCO成本。此外,透過AMD Infinity連接8個MI300X組成Instinct平臺,支援1.5TB的HBM 3記憶體,打造更大的生成式AI訓練及推論環境。

推廣AI軟體平臺以拉攏更多AI、HPC社群

在資料中心興起的AI運算方面,光有運算硬體還不夠,AMD也提供軟體平臺,強調開放、經過驗證、可立即使用的特色,希望能吸引更多的AI、HPC社群應用,逐漸壯大AMD在AI、HPC市場的生態發展,趕上Nvidia。

AMD在AI的戰略是,在各種裝置上提供AI運算功能,從資料中心CPU與GPU、邊緣運算到智慧終端裝置使用的CPU與GPU,搭配各種軟體平臺,包括EPYC處理器搭配的ZenDNN,Instinct加速器搭配的ROCm軟體平臺,邊緣及終端運算裝置的Vitis AI。

其中針對AMD Instinct加速器提供的ROCm軟體平臺,目前已推出第5代ROCm軟體平臺,近期宣布和PyTorch基金會合作,目前AMD Instinct加速器與ROCm 5.4.2版本已支援PyTorch 2.0,提供Day-0支援。

日前更釋出ROCm 5.6版,增加PyTorch 2.0模式下對OpenAI Triton的支援。另外,還對PyTorch、TensorFlow和JAX提供OpenXLA支援,支援更廣泛的AI社群。讓PyTorch社群使用AMD加速器,可立即使用相關的AI模型。

目前已有超級電腦的專案利用Instinct加速器及ROCm進行研究。此外,AMD也和AI模型平臺Hugging Face合作,針對EPYC處理器、Instinct加速器、Radeon等裝置最佳化Hugging Face的平臺。

儘管AMD開始在AI、HPC生態上急起直追,以硬體加速計算、軟體平臺,希望壯大自家的AI、HPC生態系,為搶攻相關市場奠定基礎,但相較於在這些領域已經營多年的Nvidia,目前仍有不小的距離需要追趕。

熱門新聞

2026-02-11

2026-02-12

2026-02-11

2026-02-10

2026-02-09

2026-02-13

2026-02-10