Xanadu與Nvidia合作,運用PennyLane函式庫和cuQuantum SDK加速量子模擬,而這是科學家第一次以超級電腦規模加速量子模擬,透過將量子模擬分散到256個Nvidia A100 Tensor Core GPU上,模擬高達36個量子位元的運算。

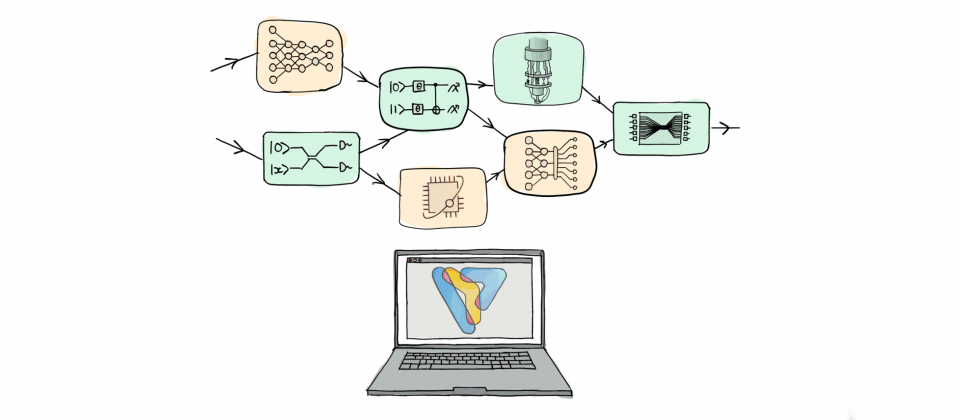

Xanadu的量子程式開發框架PennyLane,是一個開源的跨平臺量子機器學習Python函式庫,供研究人員能以機器學習函式庫,諸如PyTorch和TensorFlow來設計量子電路,而這便能夠無縫整合量子與古典運算,並使用量子運算的特性來加速機器學習工作。而cuQuantum SDK則是Nvidia所推出的軟體開發工具組,能夠加速量子運算的模擬與研究,搭配Nvidia GPU的運算能力,cuQuantum SDK可大幅提高模擬大型量子系統的效率。

PennyLane中將機器學習技術應用在量子計算上是一個新穎的想法,藉由PennyLane的擴充套件,研究人便可連接不同量子運算後端,因此PennyLane在推出之後便受到許多研究人員的關注,但是Xanadu開發人員提到,許多研究人員要求更多的量子位元。

而PennyLane在擴展模擬量子系統遇到的主要問題,便是資源使用的挑戰,因為模擬量子系統使用狀態向量模擬器(State Vector Simulator),其所需要的記憶體,隨著模擬的量子位元數呈現指數成長,Xanadu研究人員提到,在桌上型電腦的極限就是30量子位元,再增加更多的量子位元,所使用的記憶體量便會超過高效能運算執行個體的最大記憶體容量。

在2022年的時候,研究人員開始在單個GPU上使用cuQuantum加速量子模擬,運算速度提升達10倍,而雖然GPU在模擬運算的效能上具有極大的優勢,但是Xanadu研究人員提到,記憶體管理對GPU來說更為重要,雖然單一GPU的記憶體就可達96 GB,但可用裝置記憶體最多只能容納30到32量子位元系統的狀態向量儲存,為了模擬更大的系統,需要將狀態向量分散在多個GPU上,連接所有GPU一起運作。

因此為了支援分散式向量模擬,以模擬更多的量子位元,Xanadu在新版PennyLane中添加MPI(Message Passing Interface )技術以及Nvidia cuQuantum SDK。

研究人員在美國國家能源研究科學計算中心(NERSC)的超級電腦Perlmutter,搭配使用PennyLane,在GPU叢集上高速進行量子模擬。在Perlmutter多達256個Nvidia A100 Tensor Core GPU上執行模擬程式,現可模擬約36個量子位元,達到目前其他研究模擬量子位元數的2倍。

熱門新聞

2026-02-11

2026-02-12

2026-02-11

2026-02-10

2026-02-09

2026-02-13

2026-02-10