近年機器學習的主要研究,都集中在訓練越來越強大的自監督語言模型,而由於這些模型具卓越的預測能力,因此也有成為壓縮器的潛力。DeepMind研究人員評估大型基礎模型的壓縮能力,發現這些模型是強大的通用預測器,不僅能夠處理文字資料,更可處理圖像聲音進行高效壓縮。

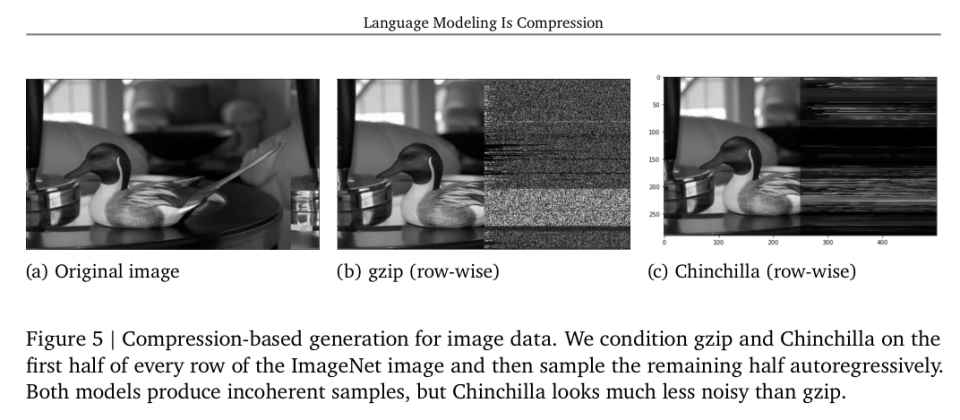

DeepMind在研究中,使用了一個稱為Chinchilla 70B模型,雖然這個模型主要以文字訓練,但是研究人員發現該模型也可用於壓縮ImageNet圖片,可將檔案壓縮至原始大小的43.3%,甚至可將LibriSpeech語音樣本壓縮至原始的16.4%。

研究人員提到,這個壓縮表現超過專門為圖像或是語音設計的壓縮演算法,像是無失真壓縮點陣圖圖形格式PNG只能壓縮該圖片至58.5%,音訊檔無失真壓縮演算法FLAC也只能將音訊壓縮到30.3%。

DeepMind的研究證明,預測和壓縮之間存在等價性,因此研究人員可以使用任何壓縮演算法,建立一個更加強大的條件生成模型。由於好的預測模型能夠準確預測資料中的模式和規律,而這種能力讓模型能夠成為一個高效的壓縮器,因為當一個模型能夠精確預測未來的資料點,也就能夠捕捉資料的本質特徵和結構,有效地壓縮資料。

壓縮是一種資訊編碼的過程,目標是要以更少的位元表示資料,因此當模型能夠精確預測資料,其實也就代表模型學會了一種資訊編碼的方式,這種編碼方式能夠用來壓縮資料,因為模型已經理解了資料中的特徵和模式。

語言模型能精確預測下一個字,也就代表可以用於壓縮文字資料,因為模型有能力找出文本中重複或是可預測的模式,並用更少的位元來表示這些模式。而這個結論同樣適用於圖像和音訊,當模型已經可以預測這些資料中的模式,也就能夠壓縮這些資料。

DeepMind研究的主要貢獻,包括證實基礎模型無損壓縮的能力,在當前語言模型資源取得越趨容易的情況下,任何人都可以取得語言模型並將其用於壓縮中,而不需負擔額外的訓練成本。同時,研究也顯示,主要在文字上進行訓練的基礎模型,由於其上下文學習能力,因此能夠很好地成為通用壓縮器。

研究還發現,要將模型用於壓縮上,模型並非越大越好,過大的模型可能反而對壓縮效能產生負面影響,因為模型的參數本身也需要在輸出中被考慮進去,當有一個模型具有非常多的參數,雖然能夠有效壓縮資料,但是龐大的參數本身也會成為負擔,這些參數也需要被儲存和傳輸。

而自然語言處理常用到的分詞(Tokenization)方法,把一串文字切割成更小、更容易處理的步驟,在壓縮上不會提高壓縮效率,但可以增加模型在特定上下文中的資訊內容。透過上下文的學習,模型能夠根據不同任務,動態調整壓縮策略,達到更高的壓縮效果。

這篇研究的主要重點,探討模型與壓縮器間的等價性,證明兩者可以互相轉換。研究人員也評估語言模型作為壓縮器的能耐,並發現模型不只能夠良好地處理文字資料,也能夠在未受過訓練的資料模式,像是圖像與音訊上表現出色。這篇研究提供一個看待模型的全新角度。

熱門新聞

2026-02-06

2026-02-06

2026-02-06

2026-02-06

2026-02-09

2026-02-09