DeepMind聯手超過30個學術實驗室,發展跨型態機器人學習資源,收集多種不同型態的機器人資料,創建了一個稱為Open X-Embodiment資料集,並且以此資料集訓練了機器人Transformer模型RT-X,該模型可以在多種機器人型態間傳遞技能,核心目標是要讓單一模型可以控制不同類型的機器人。

過去,當機器人、任務或是環境稍有變化,研究人員就需要重新訓練機器人模型,而為了解決更改單一變數,就要從頭開始訓練模型的麻煩,DeepMind想要發展通用機器人技術,而訓練通用機器人模型,建立多樣化機器人演示資料集是關鍵步驟,如此才能使模型可以控制不同類型的機器人,遵循不同的指令,對複雜的任務進行基本推理,並且有效地泛化技能。

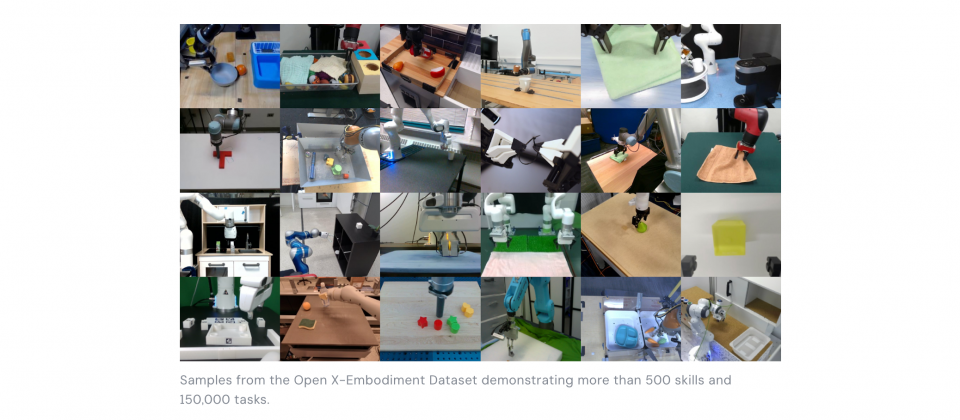

不過,這對單一實驗室來說是非常耗費資源的工作,於是DeepMind肩負起建立Open X-Embodiment資料集的任務,和33個學術實驗室合作,從22個型態的機器人收集資料,資料集範圍涵蓋500種技能和15萬項任務,總計超過100萬個場景。這是目前同類型中,最完善的機器人資料集。

而RT-X則是以DeepMind的RT-1和RT-2機器人Transformer模型,所訓練的通用機器人模型,RT-1是DeepMind大規模用於真實世界的機器人控制模型,進一步訓練成為RT-1-X,而RT-2則是視覺、語言與動作(VLA)模型,可以從網路和機器人資料中學習,DeepMind使用該模型訓練出RT-2-X。

透過引入更多樣化和跨型態的訓練資料集,RT-1-X和RT-2-X達到更佳的性能,相較於只在特定領域訓練的模型,RT-X展示更高的泛化和新增技能的能力。當研究人員將RT-1-X與專為特定任務開發的模型進行比較時,他們發現利用Open X-Embodiment資料集訓練的RT-1-X,在性能上平均超越原始模型50%。

此外,研究人員也深入探討機器人之間的知識轉移。他們進行一系列的實驗,其中涉及的技能和物體在RT-2資料集中不存在,但是在其他機器人資料集中出現,而實驗結果發現,RT-2-X模型在新技能方面的表現是RT-2模型的3倍。這代表結合多平臺的資料進行訓練,RT-2-X成功學習到原始資料集中所沒有的技能(下圖)。

這篇研究的重要性在於,透過使用更多樣化的資料和先進模型,研究人員可以開發出更有用的輔助機器人,同時,還證明了跨型態機器人通用模型的可行性,能夠大幅提升DeepMind和各種機器人的運作表現。DeepMind目前已向社群公開Open X-Embodiment資料集和RT-1-X模型,以促進機器人技術的研究。

熱門新聞

2026-02-11

2026-02-11

2026-02-12

2026-02-09

2026-02-10

2026-02-10

2026-02-06