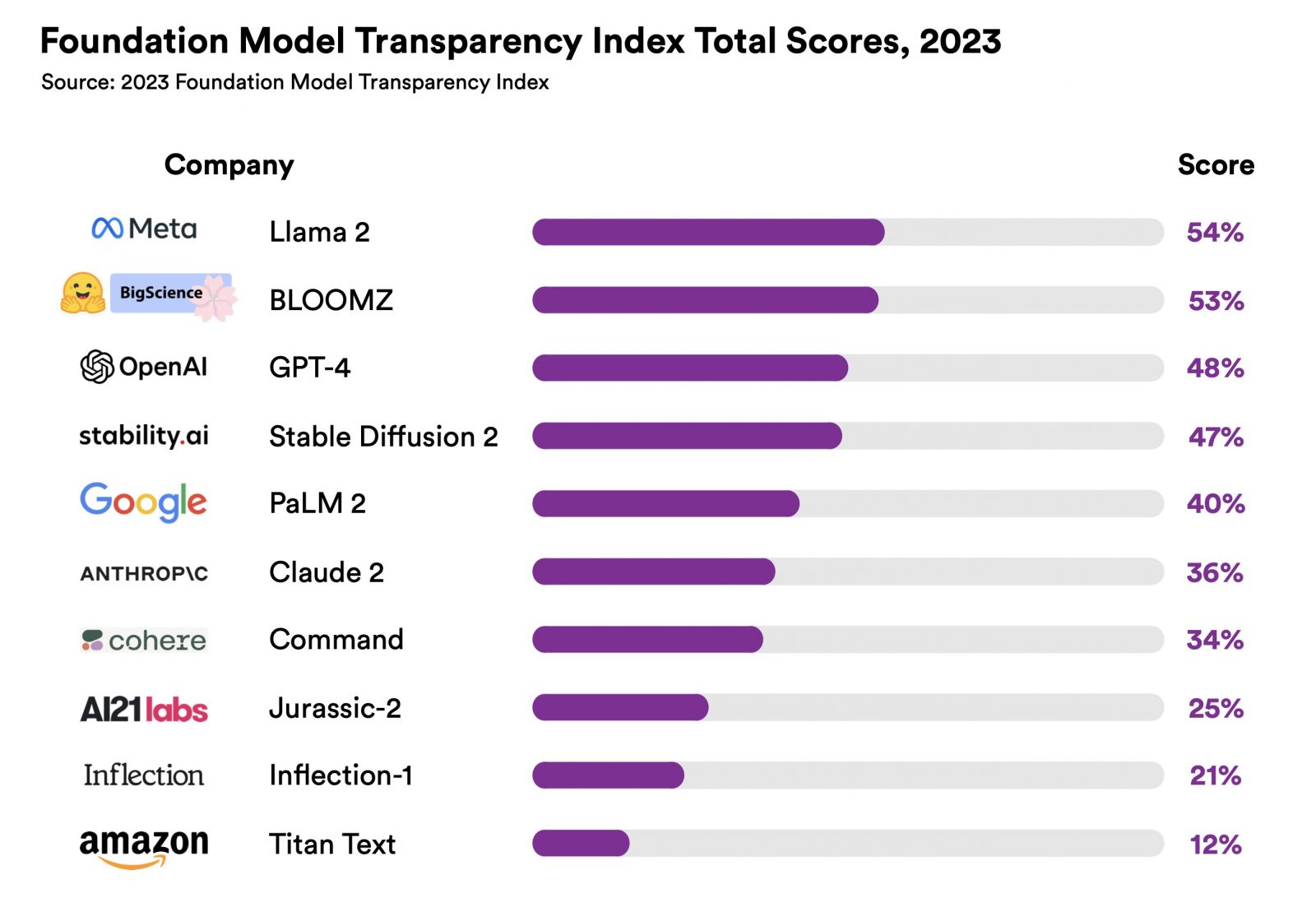

美國史丹佛大學以人為本的人工智慧學院( Stanford University Human-Centered Artificial Intelligence,Stanford HAI)本周公布了十大基礎模型的透明度指標,其中最高的是Meta的Lama 2,但也只有54%,使得該團隊認為它們全都缺乏透明度。

此一研究是由HAI基礎模型研究中心(CRFM)的社會負責人Rishi Bommasani所主導,調查的10款基礎模型包括Meta的Llama 2、BigScience的BloomZ、OpenAI的GPT-4、 Stability AI的Stable Diffusion、Anthropic PBC的Claude、Google的PaLM 2、Cohere 的Command、AI21 Labs的Jurassic-2、Inflection AI的Inflection,以及Amazon Web Services的Titan。

基礎模型指的是利用大量資料訓練而成的大型機器學習模型,通常適用於廣泛的任務。Bommasani指出,缺乏透明度一直是數位技術消費者所面臨的問題,例如人們在網路上看到許多騙人的廣告、共乘服務的薪資不明確、讓使用者在不知情的狀況下購買,或者是與內容審核有關的透明度問題,這些問題形成了一個龐大的生態體系,令社交媒體充斥著錯誤與不實資訊。

CRFM主任Percy Liang則說,商業基礎模型的透明度對於推動AI政策,或是利用這些模型作出決策的產業及學術界而言非常重要。

Stanford HAI總計制定了100項基礎模型的透明度指標,當中約有1/3涉及這些模型是如何建置的,例如訓練資料的相關資訊,建置模型的人力,以及使用的運算資源等,另有1/3與模型本身有關,像是它的能力、可信度、風險或如何緩解風險等,最後的1/3則牽涉到下游如何使用該模型,包括揭露模型分配的公司政策、使用者資料保護、模型行為,以及公司是否替受影響的個人提供補救機會等。

在這些不同範疇的指標中,表現最好的是模型基本資訊(Model Basics ),此一範疇指的是供應商是否揭露了基礎模型的模式、規模、架構,以及中心化的模型文件,其平均透明度為63%。表現最差的則是影響(Impact),該範疇評估了基礎模型是否揭露對下游應用的影響,如使用上的統計、監控,或者是提供補救機制,其平均透明度只有11%。

而在十大基礎模型中,Meta的Lama 2以54%的透明度居冠,Stanford HAI還諷刺品牌中含有「開放」(Open)一字的OpenAI卻一點都不開放,它的旗艦模型GPT-4透明度只有48%,顯示它大部分都不透明。GPT-4在此一透明度排行中位居第三,落後BigScience的BloomZ(53%),而Google的PaLM 2則以40%排名第五。

Bommasani表示,較低的透明度讓企業更難知道它們能否安全地打造仰賴這些商業基礎模型的應用程式,亦難以令學者依靠這些模型來作研究,也不容易制定政策來控制此一強大的技術,消費者則無法了解模型的限制,或是在受到傷害時尋求補救。

總之,Bommasani認為上述十大基礎模型在透明度方面都不及格,而且也不應以目前分數最高的Meta Llama 2作為楷模,而是應該考慮更高的目標,例如滿足其中80或90個以上的指標,且他相信應該至少有一家公司可達到82%。

熱門新聞

2026-02-11

2026-02-09

2026-02-10

2026-02-11

2026-02-10

2026-02-06

2026-02-10

2026-02-10

-image%20by%20Stanford%20Center%20for%20Research%20on%20Foundation%20Models.png)