Google本周宣布,將擴大針對AI系統的抓漏獎勵計畫,進一步納入生成式AI的安全漏洞,同時也揭露了該公司AI系統的抓漏獎勵範圍。

看起來Google像是跟著微軟的腳步推出了AI抓漏計畫,但其實Google宣稱先前已將AI系統納入了該公司的漏洞獎勵計畫(Vulnerability Rewards),也與DEFCON在今年9月共同主持了LLM Hackathon競賽,測試Google的AI服務。

總之,或許是受到微軟的刺激,或者是沒有太多人搞得懂Google的AI抓漏範圍,而讓Google本周首度公開了AI產品的抓漏獎勵標準。

Google的AI抓漏類別包括提示攻擊(Prompt Attacks)、訓練資料汲取(Training Data Extraction)、操縱模型(Manipulating Models)、對抗性擾動(Adversarial Perturbation),以及模型竊取等,舉凡是利用提示來影響模型的行為或輸出,重建或汲取包含敏感資訊的訓練資料,得以改變模型行為,或是可竊取模型權重與結構等關鍵資訊的安全漏洞,都在獎勵之列。

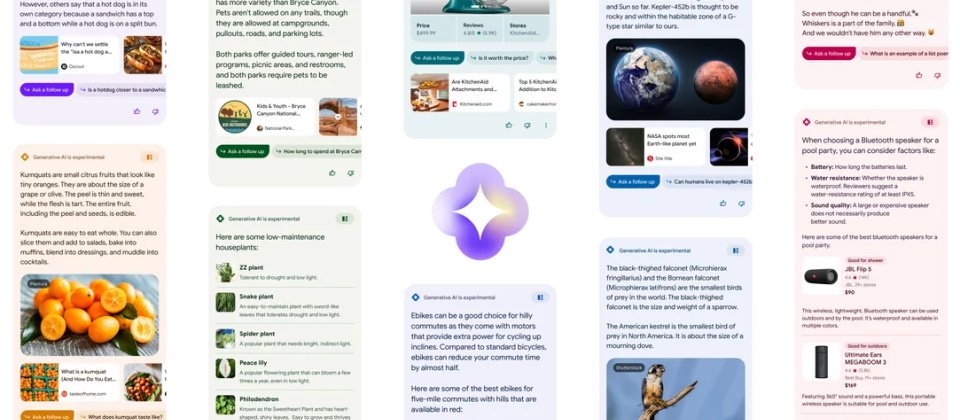

除了上述之外,Google也在本周擴大其AI漏洞獎勵計畫,新增了生成式AI類別。Google表示,新的技術需要新的漏洞報告準則,Google正在重新審視如何分類與提報AI漏洞,相較於傳統的安全漏洞,生成式AI出現了不同的問題,例如不公平的偏見、模型操縱或是對資料的誤解,隨著Google日益將生成式AI整合到產品與功能中,內部團隊正全面性地預測與測試其潛在風險,但同時也知道外部研究人員將可協助Google發現並解決新的漏洞。

其實Google內部已設立了AI紅隊(AI Red Team),專門模擬針對AI系統的攻擊行動,也發布了報告來說明駭客最可能攻陷AI系統的途徑。

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-10

2026-02-06

2026-02-10