Hugging Face

微軟本周公布Orca 2,號稱為參數僅130億的小模型,可經由模仿更大語言模型的推理方法,在測試中也顯示推理能力不輸給大它10倍的模型。

Orca 2是微軟今年年中推出第一代Orca後,探索參數在100億以下的小型語言模型的最新成果。目前微軟已經在Hugging Face上開源70億和130億參數的Orca 2供研究或試用。

微軟指出,LLM如GPT-4及PaLM等具有很強的推論能力,以便回答複雜問題,生成解釋,或解決多步驟推論的任務。但較小模型往往欠缺這類能力,這也是微軟Orca 2專案的目的;他們希望利用對LLM的知識來提升小模型的能力。

Orca 2的2個版本都是由Llama 2基礎模型以大量合成資料客製訓練而成。訓練Orca 2的資料集是由更強大的教師模型(teacher model)生成。這些資料是教師模型在詳細指令甚至多次詢問後的回應結果。研究人員希望學生模型(Orca 2)學習這些回應的推論過程及策略。最後,教師模型教導Orca 2多項推理技巧,包括多步處理、回憶-推理-生成,擷取-生成,以及直接回答方法,也教它為不同任務選擇不同解決策略。

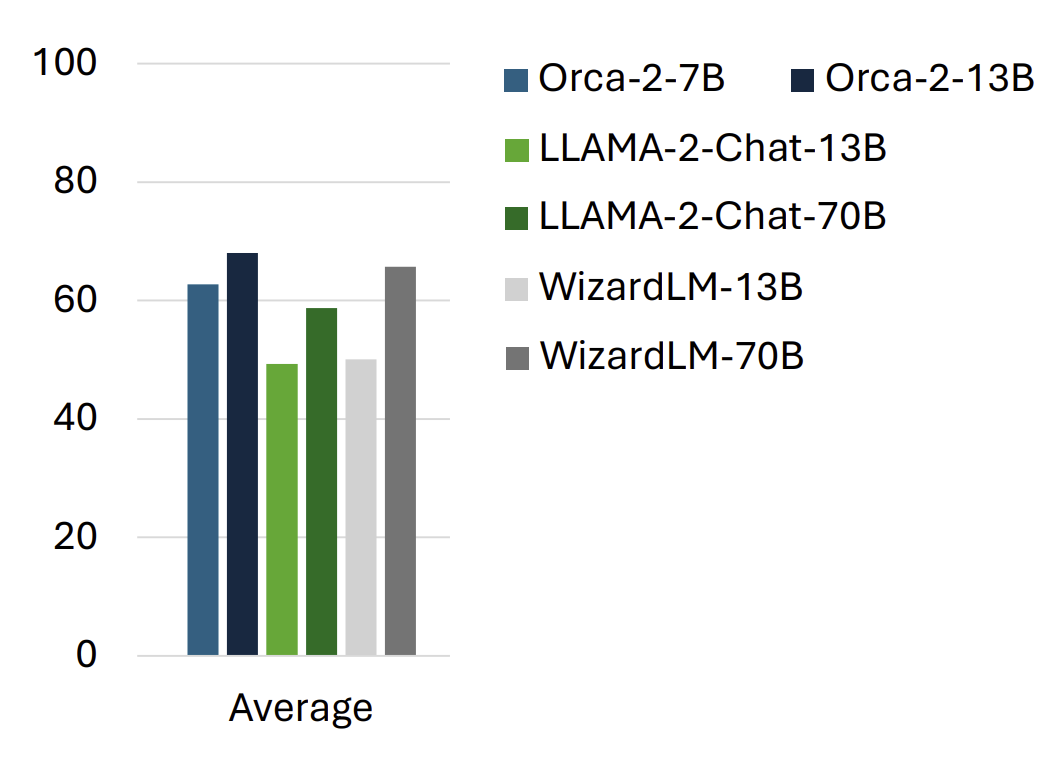

在訓練成後,研究人員利用15種標竿測試,包括近100種任務及超過3.6種不同零樣本測試用例,來評估Orca 2。標竿測試涵蓋語言理解、常識推理、多步驟推理、數學解題、閱讀測驗、摘錄重點、貼近真實性,以及有毒內容的生成及辨識。

評估結果顯示,Orca 2效能大幅超越同樣大小的模型,包括第一代Orca,而在處理複雜推論的零樣本環境測試中,表現和5到10倍大的大型語言模型(LLM)接近,甚至超過。

微軟研究人員指出,Orca 2的成功關鍵在於使用多種推論策略,找出不同任務最適用的解決方案,以及使用高品質的合成資料作為後續訓練(post-training)。雖然Orca 2承襲基礎模型及其他模型共通的限制,不過Orca 2突顯了小模型也能具備良好的推理能力,以及可控、可專化,也更具安全性。

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-10

2026-02-06

2026-02-10

2026-02-10