Meta

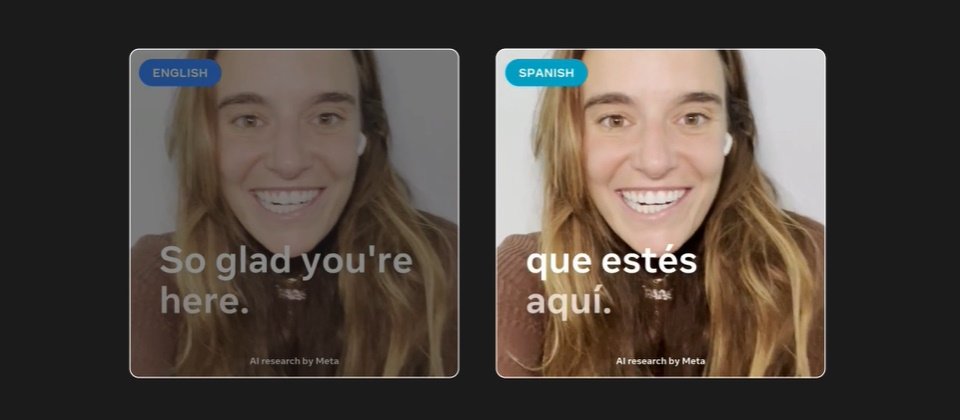

Meta上周(11/30)公布翻譯AI模型套件Seamless Communication,包含提供更精準再現說話者情緒、及延遲僅2秒的幾近同步翻譯能力的新模型,支援近百種語言輸入。

Seamless Communication為Meta為慶祝其AI研究機構基礎AI研究(Fundamental AI Research,FAIR)成立10周年而發表的研究成果之一。Seamless Communication是以8月公布的多語雙模(文字、語音)翻譯模型SeamlessM4T第2版為基礎而發展出的套件,號稱能在翻譯時保存不同語言的說話表情,以及說話者講話同時加速翻譯。

這個套件其實由4個模型組成,其中之一是SeamlessM4T第2代,以及SeamlessExpressive、SeamlessStreaming與Seamless。SeamlessExpressive是一種口譯模型,解決傳統AI翻譯時無法抓住聲音語調、停頓和重點,而失去情感和意圖的重要訊號的問題。SeamlessExpressive是第一個掌握跨語言表情的公開系統。它使用的模型能保存說話者情緒、風格、說話速度、停頓和節奏,又能維持翻譯品質。目前SeamlessExpressive支援英、中、西、法、德、義語。

SeamlessStreaming是同步翻譯模型,主打2秒延遲的語音和文字翻譯,可支援口譯(speech-to-speech translation,S2ST)、聽寫翻譯(speech-to-text translation,S2TT)及自動語音辨識(Automatic speech recognition,ASR)。在後二種任務上,SeamlessStreaming支援將近100種語言輸入及輸出,而在口譯同步翻譯則支援100種語言輸入、36種語言輸出。最後一種模型Seamless則是融合這三種語言模型於一。

Meta也將示範影片公布在GitHub以及HuggingFace網站上。

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-10

2026-02-06

2026-02-10