Nvidia釋出一款示範性應用程式Chat with RTX,展示了一種讓用戶在本地端,將自有文件、筆記和各種資料連接至大型語言模型,並運用進階人工智慧技術自訂聊天機器人的方法。官方強調,由於所有操作都在Windows RTX個人電腦或工作站中本地進行,因此可快速且安全地執行查詢。

Chat with RTX允許用戶在本地端Windows電腦上,運用檢索增強生成(Retrieval-Augmented Generation,RAG)、TensorRT-LLM和RTX加速等技術,快速自訂生成式人工智慧聊天機器人。用戶需要使用GeForce RTX 30、40系列以上的GPU,或是RTX Ampere、Ada Generation GPU,以及至少8 GB顯示卡記憶體。檢索增強生成是一項結合整合技術和生成式模型的人工智慧方法,其目的是透過從大量資料檢索相關資訊,來強化模型的生成能力,進而提高生成內容的準確性和相關性。

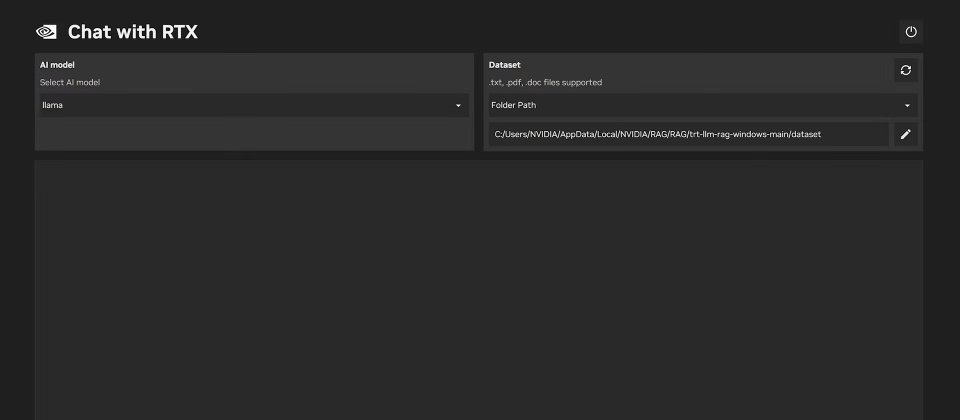

用戶可以將個人電腦本地端文件作為資料集,連接諸如Mistral或Llama 2等開源大型語言模型,快速進行各種查詢。Chat with RTX支援多種檔案格式,包括.txt、.pdf、.doc/.docx和.xml,將應用程式指向包含這些文件的資料夾,Chat with RTX在數秒內就能將其載入。文件也能夠包含YouTube影片和播放列表的資訊,透過將影片網址添加到Chat with RTX,便可以在聊天機器人中整合相關知識進行上下文查詢,獲得諸如旅行建議或是各種教學課程資源。

官方指出,因為Chat with RTX在Windows個人電腦和工作站中本地運作,因此可以很快地獲得查詢結果,而且用戶的資料只會保留在裝置上。Chat with RTX不仰賴雲端大型語言模型服務,而是在本機個人電腦上處理敏感資料,因此不會與第三方共享資料,而且也不需要網路連線。

Chat with RTX展示RTX GPU加速大型語言模型的能力,該應用程式是根據TensorRT-LLM RAG開發者參考專案建置而成,任何人都可以從GitHub上取得,甚至也可以使用該參考專案來開發和部署自己的檢索增強生成RTX應用程式。

熱門新聞

2026-02-11

2026-02-12

2026-02-11

2026-02-10

2026-02-09

2026-02-13

2026-02-10