SAS副總裁Reggie Townsend負責帶領SAS數據倫理措施(Data Ethics Practice)團隊,他在今年年會上揭露AI監管與治理新產品,包括模型卡、AI治理顧問服務,另也釋出AI監管工具。(攝影/王若樸)

不只主打生成式AI,在今年Innovate 2024年會上,數據分析大廠SAS還聚焦另一關鍵領域:AI監管與治理,並推出新工具和服務,來因應日漸高漲的企業需求。

這些新產品,包括整合在雲端資料分析平臺Viya、猶如營養標示卡的AI模型卡(Model Cards),清楚顯示模型各種指標,如準確率、模型漂移等。另一產品是SAS AI治理顧問服務,透過會議輔導方式,來協助企業落實合規的AI治理,同時,他們還釋出可信任AI生命周期(Trustworthy AI Life Cycle)工作流程,專門對應美國國家標準暨技術研究院(NIST)制定的AI風險管理框架需求,方便企業實踐風險管制。

3年前就開始布局AI監管發展藍圖

這不是SAS第一次聚焦AI監管與治理。早在2019年,SAS在主力產品Viya平臺新添自動化機器學習建模功能的同時,就高調宣布了機器學習模型的解釋功能,來因應企業和監管單位對AI黑盒子的擔憂,藉此提高模型透明度和可解釋性。

後來,2021年,他們進一步鎖定AI倫理,發起數據倫理措施(Data Ethics Practice),由時任SAS總監、現任SAS副總裁的Reggie Townsend擔任指揮官角色。當時,他才剛被任命為美國商務部國家人工智慧諮詢委員會(NAIAC)成員,負責對美國政府提供AI發展建議。而對內,他則負責組成SAS跨職能團隊,來指導、整合全球作業,以公平方式開發和部署兼具包容性的AI,提供給內外部顧客。

隔年,SAS在數據倫理措施的原則下,進一步發起負責任創新行動,要全面開發負責任的演算法、AI應用,甚至要找出整個創新過程中可能發生的偏見,並在模型部署的每個階段確保公平性。

AI監管與治理亮點1:模型標示卡

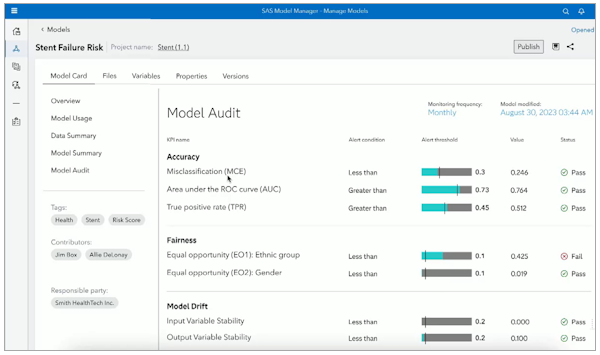

SAS今年年會發表的AI模型卡猶如模型的營養成分表,記載了模型各種關鍵指標和變動記錄,方便企業使用者落實AI監管措施。(圖片來源/SAS)

在這些策略基礎下,今年,SAS首度亮相了AI監管工具模型卡。這是因為,如何將AI模型以通俗易懂的方式,呈現給所有參與AI生命周期工作中的人員,是一件很困難的事。再加上AI監管法規在世界各地越來越嚴格,比如歐盟議會今年3月通過AI法案,來規範AI風險等級與相應措施,美國去年則發布AI行政命令,同樣規範AI系統風險和對社會的衝擊與因應方法。

臺灣去年則由行政院提出公家機關生成式AI指引,年底則有產業主管機關發布金融業運用AI指引草案,來規範金融機構使用AI需達到的公平性、可解釋性等要求,今年初數位部旗下AI評測中心則發布包含公平性、準確度等指標在內的評測規範。對企業來說,如何呈現模型表現和相關指標,讓監管機構容易理解,成為另一重要課題。

看準這波需求,Reggie Townsend在2024年年會上揭露模型卡功能,能讓企業或組織內的利害關係人,不論是開發者還是董事會董事,都能查看易懂的模型重要資訊。這個模型卡功能,預計今年中正式上線。

模型卡的運作方式是,直接根據SAS產品內容來為使用者註冊的模型,自動產生模型卡,使用者不必手動建立。不只是SAS平臺提供的模型,因SAS Viya已有用於管理開源的架構,因此也能替開源模型自動建立模型卡,目前從Python模型開始支援。

模型卡內容會特別突顯準確性、公平性和模型漂移等指標。尤其,模型漂移是模型性能隨條件變化而下降的重要指標,可用來判斷模型的適用性。

除了這些,模型卡還包含詳細的模型治理資訊,像是模型上次修改的時間、誰對模型做出貢獻、哪些人對模型負責等,方便使用者組織解決模型效能異常問題。SAS表示,模型卡還涵蓋模型使用資訊,可供企業或組織查明預期用途、超出範圍的應用和限制資訊。對企業和組織來說,這些訊息可因應業務營運所需的透明度和規範檢查,讓使用單位更輕鬆符合法遵。

AI監管與治理亮點2:顧問服務與監管工具

除了提供模型指標,為更進一步提供現有顧客AI監管和治理服務,SAS自己也成立了AI治理顧問服務(AI Governance Advisory)團隊,透過會議方式來協助企業達到AI治理目標。目前,SAS已試辦這項顧問服務,其中中東歐洲最大的金融機構PZU波蘭保險集團,就有採用。

PZU集團部署了300個AI和機器學習模型來協助日常業務營運,如客戶分析、欺詐偵測等。但近幾年,AI監管法規越來越完備,PZU集團便在去年5月開始與SAS AI治理顧問團隊展開專案,來建立更完善的AI監管與治理制度。

他們表示,這個試辦服務可為企業帶來幾大好處,包括從可信任且分散式的決策制定中,取得更高生產力,或是透過更好地劃分資料當責性,來加深信任,以及能留住呼籲負責任創新的高階人才等。

另一方面,SAS也注意到美國NIST在去年推出的AI風險管理框架(AI RMF)。這是一份關於AI系統設計、開發、部署和使用的指南,也成為美國企業組織在缺乏官方法規的情況下,用來設計可信任和負責任AI的重要參考。

於是,SAS根據NIST AI風險管理框架,設計出一套可信任AI生命周期工作流程,來讓企業和組織更容易實作NIST的AI風險管理框架。

首先,這款工作流程定義了個別角色和工作期望,並收集所需文件、列出考量因素,透過自動化來簡化實作的工作流程。之後,企業或組織會得到一個正式模型,附帶一個文件,來說明他們已做好盡職調查、確保模型是公平的,且作業流程不會造成任何傷害。

除此之外,這款工作流程還能讓使用者記載,自家AI系統可能產生的社會影響思考。

比如,使用者可透過工作流程的幾個步驟,來確保訓練資料能足夠代表被影響的受眾群體,且模型的預測能力和表現,在受保護的類別中都差不多。這些步驟可確保模型不會造成負面影響,或傷害特定群體,而且,使用者還能建立人為介入(Human-in-the-loop)的任務,來確保模型一直準確、有效。

目前,使用者可從SAS模型管理資源的GitHub上,下載可信任AI生命周期工作流程。預計不久後,使用者也能在NIST AI風險中心下載這個工作流程。

熱門新聞

2026-02-06

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-09

2026-02-09