Hugging Face

小語言模型開始加溫,Hugging Face本周公布了可在手機等裝置上執行的小參數量語言模型SmolLM家族,包括1.35億、3.6億及17億參數模型。

能在本地裝置執行的小型語言模型成為最新市場焦點,目前已公布的小模型有微軟Phi系列、阿里巴巴的通義千問Qwen 2(不到20億參數)及Meta的MobileLLM,若設計和訓練得當都可以得到很好的效果。但是關於這些模型的資料策畫(curation)和訓練的資訊卻不為大眾所知。

Hugging Face公布了1.35億、3.6億及17億參數的小型語言模型SmolLM,是以謹慎策畫的高品質訓練資料集訓練而成。團隊指出SmolLM模型精簡的記憶體要求,使其可在多種裝置上部署,包括智慧型手機或筆電,其中團隊特別點明的智慧型手機為iPhone 15或iPhone 15 Pro,二者記憶體分別為6GB和8GB。

團隊也釋出了資料集SmolLM-Corpus。為確保模型透明度,Hugging Face也公開資料集內容及規畫方法:它包含一個由Mixtral-8x7B-Instruct-v0.1生成的合成課本和故事Cosmopedia v2、由The Stack提供的Python程式教學範例Python-Edu、以及由FindWeb提供的教育Web範例FineWeb-Edu。

其中在合成資料集中,團隊產生了3,900萬筆合成文件,包含280億token的大學與高中課本、故事、文章和程式碼,涵括主題超過3.4萬。FineWeb-Edu則是Hugging Face的大型英語網頁資料集FineWeb的一部分,是利用Llama3-70B-Instruct標註挑選出的1.3T token教育類網頁資訊,幾個月前已釋出。Stack-Edu-Python則是由The Stack資料集中,根據Llama 3標註挑選的50萬筆python範例。團隊指出,經過挑選的資料集,在訓練模型的速度都會更快,其中,以Python-Edu-Python資料集訓練的速度提升了3倍。

最終團隊以SmolLM-Corpus 6,000億token資料,分別訓練了1.35億及3.6億版本模型,並以1TB token資料訓練17億版本模型。

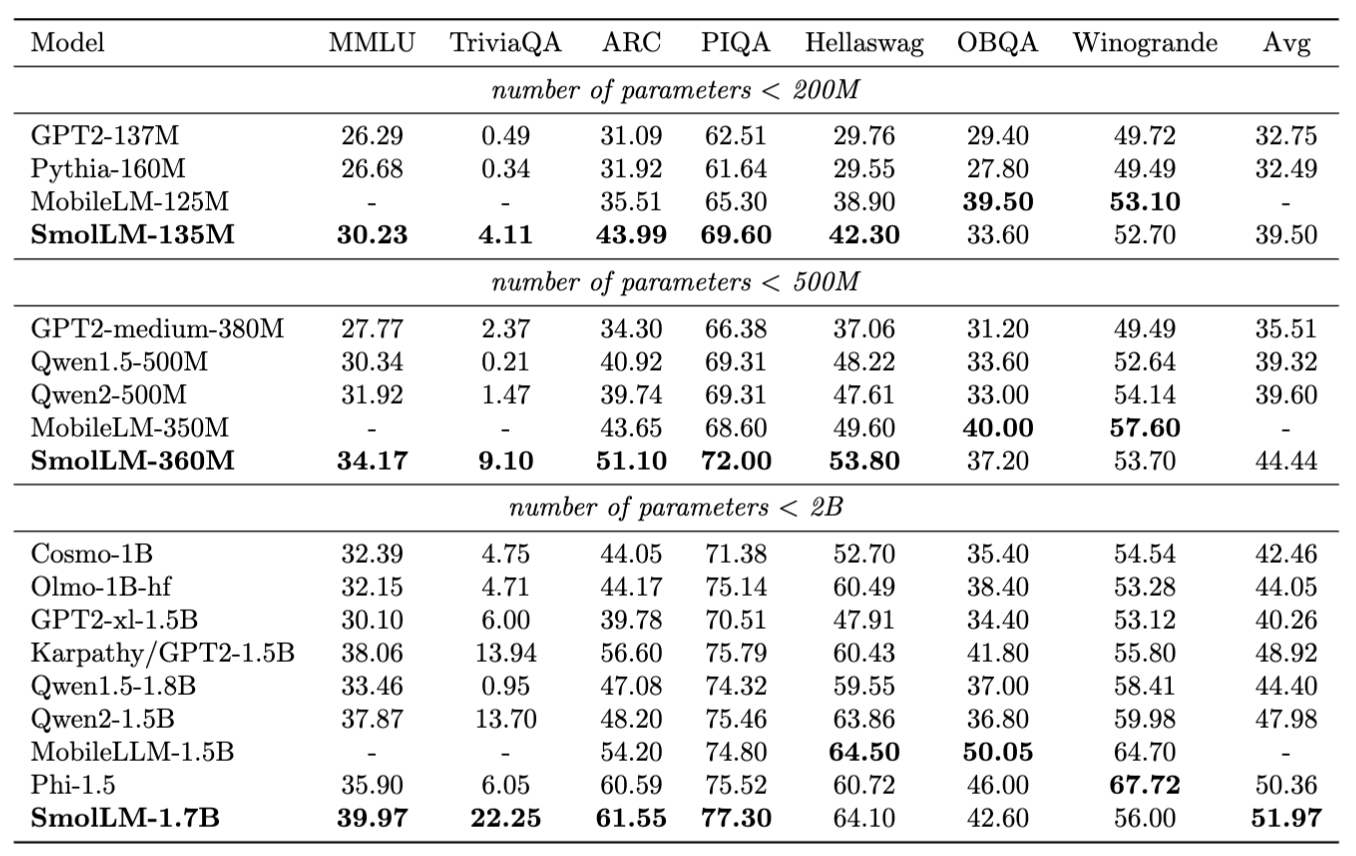

Hugging Face團隊將開發出的SmolLM模型和參數量相當的其他模型進行標竿測試。其中SmolLM-135M在多項測試中超越小於200M(2億)參數的其他模型,包括Meta才剛公布的小型LLM MobileLLM(以1TB資料集訓練)。SmolLM-360M測試成績優於所有500M參數以下的模型,不過某些項目遜於MobileLLM-350M。至於SmolLM-1.7B模型則超越所有參數量小於2B的模型,包括微軟Phi-1.5、MobileLLM-1.5B及Qwen2。此模型在Python程式撰寫效能尤其強大。

圖片來源/Hugging Face

熱門新聞

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-09

2026-02-09

2026-02-06