Hugging Face

AI晶片龍頭Nvidia與法國AI新創Mistral AI周四(7/18)共同發表了Mistral NeMo 12B,它採用Apache 2.0授權,可直接取代Mistral 7B,開發者可透過Hugging Face存取其基礎及指導模型的權重,也已被打包在容器中,可藉由Nvidia NIM的推論服務存取。

Mistral AI是在Nvidia DGX Cloud AI平臺上進行訓練,利用Nvidia的硬體與軟體完成了Mistral NeMo 12B,它支援12.8萬個Token的脈絡長度,定位為企業等級的AI模型,適用於聊天機器人、多語言任務、撰寫程式碼及摘錄等企業應用。

由於Mistral NeMo 12B在訓練時嵌入了量化技術,使得它在執行8位元浮點數(FP8)推論時,不會影響其性能。

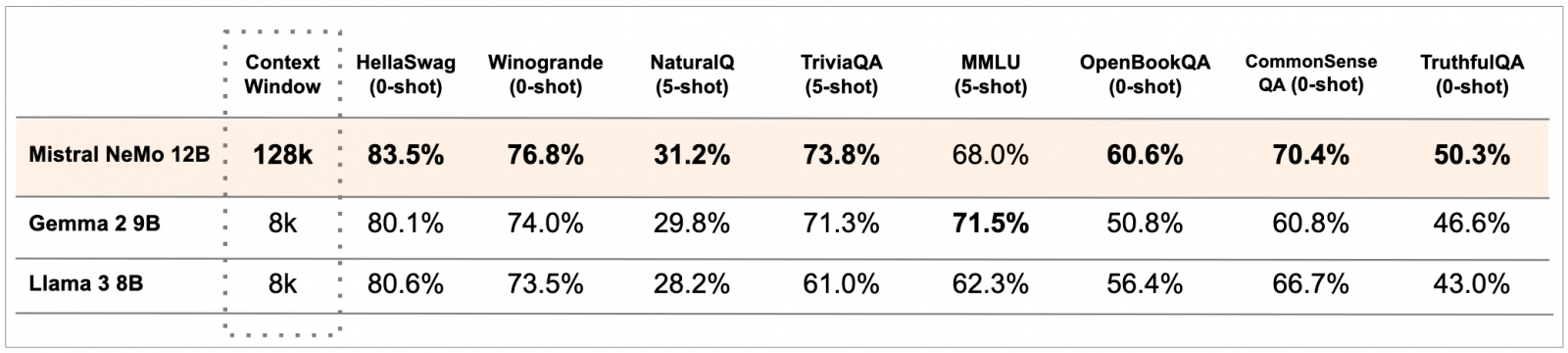

相較於Gemma 2 9B與Llama 3 8B兩個開源模型,Mistral NeMo 12B不管是在HellaSwag、Winogrande、NaturalQ、TriviaQA、OpenBookQA、CommonSenseQA或TruthfulQA等基準測試上都明顯勝出,只有在MMLU上略遜Gemma 2 9B。

圖片來源/Mistral AI

Mistral AI強調,Mistral NeMo 12B是專為全球的多語言應用而設計,而且在中文、英文、法文、德文等十多種語言上特別強大;此外,它也採用了基於Tiktoken的新分詞器Tekken,比其Mistral過去模型所使用的SentencePiece,可更有效地壓縮自然語言文本及原始碼,因此在壓縮程式碼及中文等語言文本的效率提高了30%,相較於Llama 3的分詞器,Tekken更擅長壓縮85%的語言文本。

Mistral AI表示,由於Mistral NeMo 12B採用標準架構,因此目前採用Mistral 7B的任何系統都可以直接以它取而代之,並能在幾分鐘內部署,此外,其授權亦允許企業將它整合至商業應用中。

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-10

2026-02-06

2026-02-10

2026-02-10