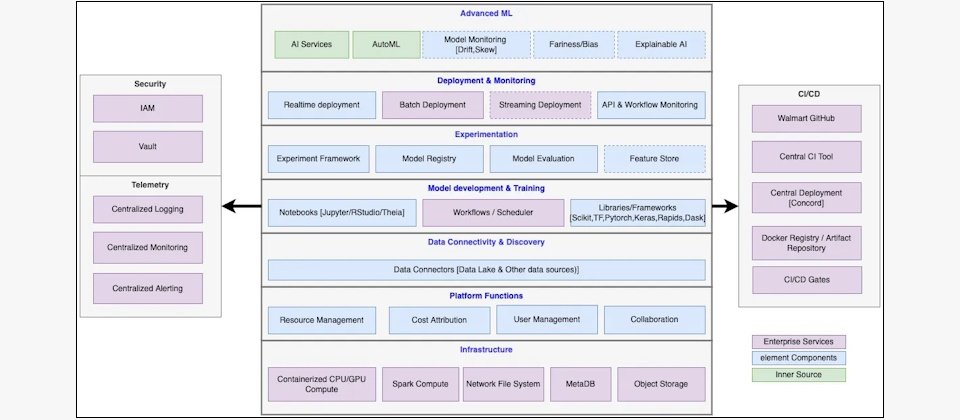

Walmart AI開發平臺Elements功能包括ML生命周期各階段開發工具,以及維運和治理用的管理工具。此平臺串接了Walmart雲原生開發平臺WNCP,以共用IT資源並將百萬個AI模型串聯到各式零售應用。

如何快速、大規模的開發生成式AI應用,並在上百萬AI模型平行執行的情況下顧及治理政策和系統效能?對Walmart來說,他們早在生成式AI時代來臨之前,就做好了準備。

Walmart開發生成式AI的4大挑戰是:持續高速創新、數據及開發規模龐大、成本控制不易,以及需要嚴謹的治理政策。零售市場的激烈競爭和世界級的企業規模,這是每一次Walmart擁抱任何科技,都會面臨的挑戰。

不論是一般AP的開發,到過去幾年的AI/ML應用,Walmart不斷思考因應這些挑戰的方法。其中一項關鍵策略是,統一25,000名IT人員所需的開發環境和資源調度,透過一站式平臺管理超大規模開發的種種面向,包括IT資源、成本、治理政策等,來增加開發效率。

從2015到2019年,Walmart花了四年,從頭打造一套雲原生開發者平臺(Walmart Cloud Native Platform,簡稱WNCP),採取「三胞胎」雲端模型(Triplet model),以容器調度技術為基礎,橫跨Azure、AWS及Walmart私有雲,作為跨雲環境及跨開發生態系的抽象層。開發者可以一站式存取3大雲端平臺的數據處理工具、數十種數據來源、和其他開發工具及資源。此平臺也能自動轉化程式碼,以利自動化部署服務到這3朵雲及Walmart自家邊緣裝置。

這個一站式的開發平臺,更為後來Walmart擴大AI/ML應用時,打下良好基礎。2021年,他們以WNCP的平臺工程及DevOps做法為基礎,打造了一套AI/ML開發平臺Elements,增加MLOps機制與工具,並與WNCP其他系統和技術原生整合。

這種做法大幅降低了不同專案團隊評估開發工具的時間、準備開發環境的時間,以及整體開發和部署時間。Elements上線後,將模型實際落地到商業應用的時間,從2周減少到短短1小時內。

當生成式AI浪潮來臨,Walmart便能用行之有年的MLOps原則、機制和工具,以及平臺工程經驗,來因應前述的4大挑戰。他們於Elements新增更多生成式AI開發和治理工具,以及多個LLM和其他不同模態的模型到Elements,以快速發展生成式AI實驗及應用。至今,Walmart隨時有上百萬個ML、AI、生成式AI模型執行,全都靠Elements開發、部署、管理。

用一站式界面和No-code工具降低開發門檻

Elements前端介面是一個以React.js做成的Web啟動臺,透過微服務及容器架構存取所有Elements甚至WNCP的後端資源。開發人員能於此一站式存取3朵雲上的開發工具及運算資源。

這些工具包括可以視覺化建立和管理工作流的DAG設計器、AI專案管理、Python或R的互動式筆記本、批次數據處理任務管理,以及數據集和模型資產管理等。完整ML生命周期的作業,包括數據彙整、數據準備、特徵工程、模型訓練、模型實驗、模型評估、模型部署、模型監控、模型回饋及再訓練等,都能利用這些工具完成。

此平臺上的開發環境不只服務資料工程師和AI工程師,更針對沒有AI背景的開發人員、資料科學家和分析師,提供了一系列No-code AI開發工具,增加他們數據探勘及實驗AI應用的能力。

Elements還內建了全平臺通用的管理與維運功能,例如成本計算與控管、數據權限管理、程式碼版本控制、系統紀錄留存、系統異常報警、災難復原。

Walmart從前端到後端全面整合AI開發相關功能,是希望確保使用者能自由選擇最適合的AI開發工具,同時能大規模自動化不同流程、重複使用IT資源、建立統一開發及治理標準,並一站式控管所有相關成本。不只如此,整合所有AI開發的IT資源使用需求,還有機會向雲端服務商協商更低的使用費。

打造超大型AI開發平臺的9大關鍵考量

為了一站式支援超大規模的AI模型開發、執行、維運、管理與治理,Walmart打造Walmart平臺時,著眼在9大關鍵考量。3項開發面考量、5項維運需求以及1項治理目標。

在開發面考量上,首先,此平臺須涵蓋AI開發完整生命周期,包括從數據彙整到模型部署的各個階段。部署後,還需定期監控模型的公平性和偏差,進行再訓練,以避免模型衰退。

第2個考量點是開發工具完整性。Elements支援Python、PySpark、Scala、R和SQL 等程式語言,Jupyter、Theia、PyCharm和RStudio等開發環境,TensorFlow、Keras和 PyTorch等AI/ML 演算法和函式庫,以及Grafana和RShiny等報告工具。

有了工具,還需要作為AI開發原料的數據。第3個考量點正是數據可用性,平臺必須讓使用者能快速存取數十種數據來源,以支援模型訓練和推論工作。

第4到第8項維運類需求,則與大規模維運和可用性有關。第4個考量點是規模,平臺需能支援數百萬個模型平行執行時,這些模型依然維持高效能。第5到第8點分別是成本管理、運算硬體支援、可用性措施及地理位置。

隨著數據量和演算法複雜度的增加,平臺必須能夠保持成本低廉。為了滿足大規模運算需求,平臺還必須支援多種運算資源,包括CPU、GPU及TPU。

可用性方面,Walmart尤其重視災難復原能力,確保平臺能在多個地理區域和多個服務提供者之間的備援基礎設施上運行,以維持高可用性。

地理位置上,Walmart有橫跨不同國家的數萬間分店和多個IT研發中心,必須同時考量雲端基礎設施以及邊緣設施的設置地點,確保不同區域都有高系統可用性、IT資源使用彈性和災難復原做法。尤其,需要部署模型在偏遠門市時,須追求低功耗、高可用性和低維護需求。

最後一個關鍵考量點是治理,Walmart希望盡可能用簡單且標準化的流程和工具,來管理超大規模AI專案的開發模式、資訊安全和合規性。他們專門制定了一整套AI治理框架,並透過Elements平臺來實現此框架的指引。

Walmart AI開發平臺的治理框架

AI治理不只是打造Elements平臺9大考量的重要一項,更涉及了法遵、道德、企業形象等面向,是Walmart企業治理政策中的重要一環,受到不同部門重視。制定AI與生成式AI治理框架時,Walmart用不同部門的主管及資深人員,組成數據科學治理委員會(Data Science Governance Council),來制定數據及AI相關的道德及負責任指引。

IT及數據團隊則以這些指引為基礎,在Elements上設計AI治理做法與機制,以強化模型的安全性、透明性及公平性。安全性方面,存取控制機制確保只有經過認證和授權的使用者才能存取數據集、模型或筆記本;加密機制會全面加密靜態和動態數據,確保資料的完整性與保密性。責任歸屬機制則記錄了所有素材的擁有者,以在事件發生時快速辨認相關負責人員。

為了進一步提升AI模型的可稽核性,平臺提供了全生命周期的稽核功能,確保所有利益相關者能觀察模型各個開發階段的情況。具體做法包括模型性能與健康狀的監控儀表板,還有數據飄移及偏差監控機制等,幫助用戶即時了解模型的狀況,並快速識別出需要再訓練的模型。

針對敏感模型,平臺設有公平性與偏見監控機制和自動化評估機制,搭配模型可解釋性機制,使業務面的相關部門能夠更好理解模型的運作原理,增強對AI決策的信任。另外,Walmart還會於開發環境中提供多種模型,讓開發者根據模型生成模式,選擇任務適合的模型。

隨著生成式AI崛起,AI治理的重要性和難度雙雙提升。正是因為有Elements作為所有AI/ML和生成式AI開發及管理的平臺,能一站式進行AI治理,Walmart才有信心,能應用生成式AI到直接面對超大規模消費者的產品,並為AI生成內容負起責任。

熱門新聞

2026-02-09

2026-02-06

2026-02-09

2026-02-09

2026-02-09

2026-02-06

2026-02-09