Google DeepMind部門上周公布優化晶片設計的AI模型,正名為AlphaChip。

2020年DeepMind團隊在科學期刊《自然Nature》上公布用以設計晶片布局的增強式學習(reinforcement learning)方法,之後也將之在GitHub上開源。上周該團隊發表了《自然期刊》補遺,補充說明方法及對晶片設計的影響。Google本周公布該模型正式名稱AlphaChip。Google說,自2020年來,該公司已經用AlphaChip模型設計了3代自己的AI加速器TPU,這些晶片讓該公司可以根據Google Transformer架構大規模擴大AI模型。

AlphaChip在一個空白晶片上,每次舖設一組電路,直到完成所有元件,然後根據最後電路布局的品質獲取回饋。新的邊緣式圖像神經網路讓AlphaChip得以學習互聯的晶片元件之間關係,發展出泛化到其他晶片的方法,藉此逐漸改善每一代布局設計。

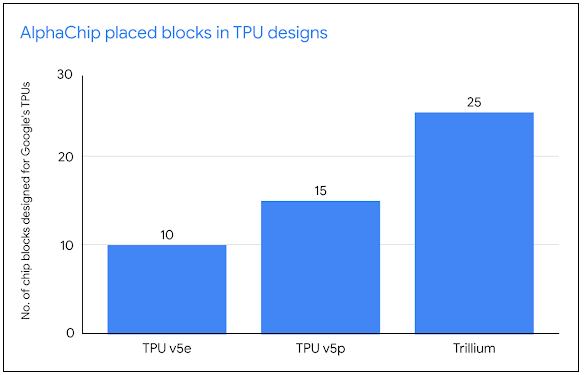

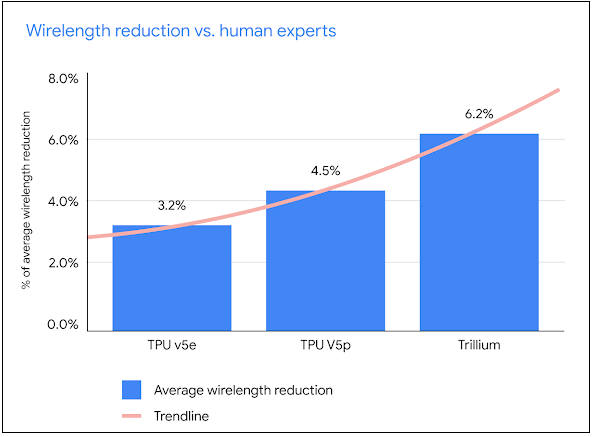

設計TPU布局階段,經過預訓練之後,Google在最新TPU block上執行AlphaChip產生布局設計。由於運用增強式學習,AlphaChip晶片布局能力愈來愈好也愈快,和人類一樣。Google說,近三代TPU,從TPU v5e、TPU v5p到第6代TPU的Trillium,AlphaChip的晶片布局品質更提升,整體布局規劃貢獻比例也更多,布局的區塊(block)由10增加為25,且減少的線長(wirelength)比例,也從3.2%提升為6.2%,證明能加速設計周期,催生更高效能的晶片。

圖片來源/Google

AlphaChip除了用於設計如TPU等專用AI加速器,也為Alphabet生成了其他晶片,像是第一塊通用型Arm-based資料中心處理器的Google Axion Processor。使用AlphaChips設計的外部單位則包括聯發科,它擴展AlphaChip的設計來設計其三星手機使用的5G晶片天璣(Dimensity)系列。

現在AlphaChip涉入的晶片設計階段也更廣,現在擴及邏輯合成(logic synthesis)和巨集選擇(macro selection)。

為了方便開發人員試用AlphaChip,DeepMind也公布預訓練的檢查點(checkpoint)作為共享資源。

熱門新聞

2026-02-06

2026-02-09

2026-02-06

2026-02-06

2026-02-09

2026-02-06

2026-02-06