圖片擷取自Anthropic官方網頁

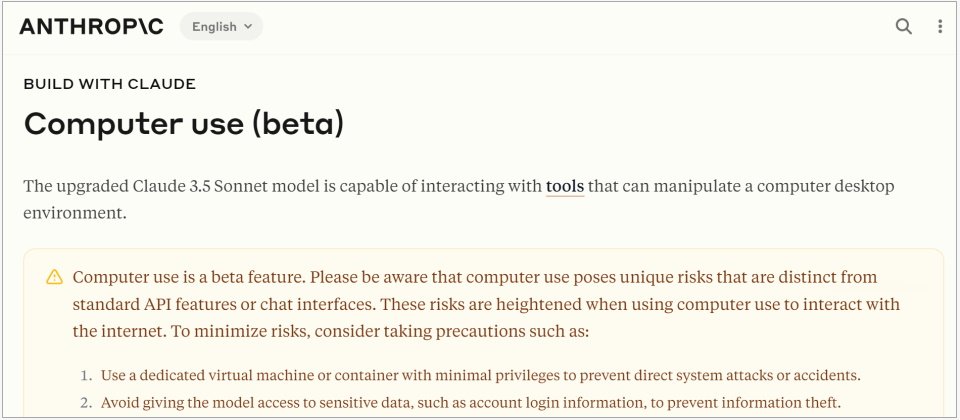

AI模型開發業者Anthropic周二(10/22)更新了Claude 3.5 Sonnet,新版Claude 3.5 Sonnet首度開放使用者測試其電腦操作能力,也特別改善了程式碼撰寫及工具使用任務,並宣布將在10月底釋出Claude 3.5 Haiku。

Claude Sonnet為Anthropic所開發的中階模型,著重在取得智力與速度的平衡,Claude Haiku則是最小也最低階的模型,主打即時回應,而最大的模型Claude Opus則是用來處理更複雜的任務,目前Anthropic僅發表Sonnet 3.5及Haiku 3.5,並未提及Opus 3.5。

為了訓練Claude使用電腦,Anthropic打造了一個API以讓Claude能夠感知電腦介面並與之互動,開發人員即可整合該API,要求Claude將指令(例如:利用我電腦上的資料來填入表格)轉成電腦命令(檢查試算表,移動游標以開啟瀏覽器,導航至最相關的頁面,以及填入表格等)。

Anthropic說,現代的大量工作都是透過電腦進行的,令AI能夠像人類一樣與電腦互動,將解鎖這一代AI助手無法處理的大量應用。這幾年AI有許多重要的發展,像是執行複雜邏輯推理的能力,以及查看與理解圖像的能力,而下一個重要領域則是使用電腦,讓AI模型可直接按照指示使用各種軟體,而不必再透過特製的軟體與電腦互動。開發人員可利用此一功能來自動化重複的流程,建置與測試軟體,或是執行諸如研究等開放式任務。

有一個OSWorld標準是用來評測模型使用電腦的能力,在理解螢幕截圖(Screenshot)上,Claude 3.5 Sonnet取得了14.9%的成績,雖然尚遠不及人類水準(70~75%),卻已高於第二名Cradle BAAI的7.8%,以及OpenAI GPT-4 Vision的7.7%,倘若可以執行更多的步驟,Claude 3.5 Sonnet還能達到22%。

不過,Anthropic坦承Claude目前操作電腦的能力並不完美,人們可以輕鬆執行的滾動、拖曳或縮放對Claude而言都是挑戰,在實驗中,它還停止了正在長時間運作的螢幕錄製,導致所有內容都不見。

目前包括Asana、Canva、Cognition、DoorDash、Replit與The Browser Company都已在測試Claude 3.5 Sonnet的電腦執行能力,其中,線上程式開發平臺Replit利用它來建置Replit Agent的新功能,可在開發人員建置應用程式的過程中,自動檢查並評估應用程式的表現。

除了操作電腦的能力之外,Claude 3.5 Sonnet在許多評測都有長足的進步,包括GPQA、MMLU Pro、HummaEval、MATH、AIME 2024、MMMU、SWE-bench Verified及TAU-bench等,除了MATH略遜Gemini 1.5 Pro之外,其它評測都勝過Gemini 1.5 Pro、Gemini 1.5 Flash、GPT-4o與GPT-4o mini。

在與撰寫程式相關的HummaEval及SWE-bench Verified評測中,Claude 3.5 Sonnet分別奪得了93.7%及49%的成績,高過前一個版本的88.1%與40.6%。

另一個TAU-bench是用來測試AI代理工具於真實世界場景中的表現,衡量能否處理複雜且多步驟的任務,並與使用者進行自然對話,Claude 3.5 Sonnet在零售領域的表現達到69.2%,在航空領域的表現為46%,高於前一版的62.6%與36%。

至於速度最快的Claude 3.5 Haiku特別擅長撰寫程式碼,它在HummaEval的得分為88.1%,而在評估解決實際軟體問題能力的SWE-bench Verified上得分亦有40.6%。

Anthropic表示,Claude 3.5 Haiku具備低延遲,更好的指令遵循能力,以及更準確的工具使用,非常適合面向使用者的產品、專門的子代理任務,以及從大量資料生成個人體驗的服務,例如購買歷史紀錄、定價或庫存紀錄等。

不管是Claude 3.5 Sonnet或Claude 3.5 Haiku都可藉由API、Amazon Bedrock及Google Cloud的Vertex AI存取,只是Claude 3.5 Haiku尚未上線,而且初期僅支援文字,之後才會支援圖像輸入。

熱門新聞

2026-02-13

2026-02-13

2026-02-13

2026-02-13

2026-02-13

2026-02-13

2026-02-13