AWS今年度主力AI產品策略鎖定生成式AI,比如去年上線的生成式AI平臺Amazon Bedrock,今年就根據GAI帶來的AI代理管理需求,新添多代理協作預覽版功能。

「生成式AI(GAI)將成為每個應用程式的核心!」AWS執行長Matt Garman在今年度re:Invent大會中如此直言,揭露了AWS年度戰略的一大重點:生成式AI。他更在主題演講中,花了超過一半的時間,在說明AWS AI平臺服務如何為生成式AI設計新功能。

GAI平臺亮點1 上架市集,還有蒸餾功能加速開發

以去年正式上線的生成式AI平臺Amazon Bedrock為例,這款平臺專為生成式AI設計,提供基礎模型選用、測試、算力支援以及各類工具,來讓使用者將模型整合到應用程式、部署到正式環境。目前有數十萬家組織在使用它。

今年,這款平臺進一步延伸,從基礎模型選擇、提示管理,到RAG和大模型幻覺避免等生成式AI的熱門議題,都有亮點更新。

首先是正式上架的Amazon Bedrock Marketplace市集,提供了100多個熱門的基礎模型,來讓使用者測試和部署。這些模型種類多元,有特定領域的專用模型,像是用於蛋白質研究的ESM3模型,也有通用的基礎模型,如來自Meta、Anthropic的語言模型。

而且,這個市集還提供單一介面,來讓使用者直接存取專用和通用模型,不必再自己建立抽象層和複雜的安全層等複雜工作。

除了基礎模型有更多選擇,AWS還鎖定建模需求,在Amazon Bedrock新添了預覽版的模型蒸餾功能,能將大模型知識快速轉移到小模型上,縮短模型開發時間、降低成本。

這個功能的特點是,使用者就算不具備機器學習專業知識,也能給定範本提示,來讓系統產出較小的蒸餾模型。這個新功能適用於多種模型,來自Anthropic、Meta和Amazon自己在大會中新發布的Nova系列模型都可以。

GAI平臺亮點2 更有效管理提示成本

隨著生成式AI深化企業工作流程,如何控管提示成本,也成為一大問題。看準這波需求,AWS今年在Amazon Bedrcok中推出提示快取(Prompt caching)預覽版新功能,可對提示進行快取,要是偵測到重複輸入的提示,就能快取同部分的答案,減少提示重複出現所產生的Token成本。

也就是說,企業建立的GAI聊天機器人,有多位使用者在提示中詢問同樣問題時,Amazon Bedrock就能快取該部分的答案。因此,這部分問題只會處理一次,還能在每次有人想要詢問相關問題時,重複使用,減少了模型每次需要處理的資訊量。

AWS資料與人工智慧資深副總裁Swami Sivasubramanian甚至形容:「這是降低延遲和節省成本的關鍵,可以降低85%延遲、節省90%成本。」

還有另一款管理提示成本的預覽版新功能是智慧提示分配(Bedrock Intelligent Prompt Routing)。這個功能很特別,使用者配置後,它能根據提示內容,自動將提示分配給最適合且兼顧成本的模型來回答問題。這個方法,在不影響準確度的情況下,最高可節省3成成本,開發者也不必再花大量時間,測試哪些模型最適合回答特定問題。

GAI平臺亮點3 RAG支援結構化和多模態資料了

在正式場景運用生成式AI,最怕的就是答非所問。為約束生成式AI不亂回答,檢索增強生成(RAG)成為一種主流方法,靠外接資料庫,來讓大型語言模型(LLM)在其中搜尋、產出答案,降低幻覺發生。

先前,AWS就推出相關服務來支援RAG,比如Amazon Bedrock Knowledge Bases知識庫,能用來簡化RAG工作流程管理。又或是Amazon Kendra,能利用機器學習預測,來讓使用者更容易在企業或組織中找到所需的正確資料。

這次,AWS瞄準RAG所需的資料類型,分別祭出Bedrock Knowledge Bases的結構化資料檢索功能,以及能自動從非結構化的多模態資料中抽取內容,來轉換、生成結構化資料的Amazon Bedrock Data Automation預覽版資料自動化功能。甚至還有支援圖學檢索的Bedrock Knowledge Bases GraphRAG預覽版功能,使用者可以打造使用知識圖譜的GAI應用程式了。

不只如此,AWS還擴大了RAG可參考的資料來源,一併推出Kendra GAI Index預覽版,使用者能連結40多個資料來源、對其索引,來打造更好的數位助理和智慧搜尋體驗。

GAI平臺亮點4 多代理協作

同樣是避免生成式AI幻覺,除了RAG,AWS今年還在Amazon Bedrock中新添另一項自動推理(Automated Reasoning)檢查功能預覽版,可以檢測模型產出的答案是否符合邏輯。Matt Garman還透露,AWS自己有許多服務,就用自動推理功能來檢查產出結果,像是S3、程式碼檢查工具Amazon Codeguru等。

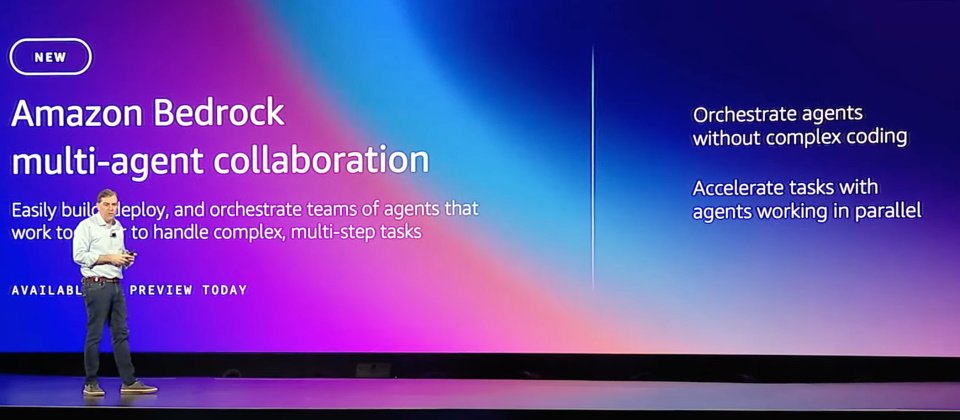

生成式AI的興起,也帶動了AI代理(Agent)應用。也就是說,一項任務可拆解為好幾個步驟,這些步驟可由幾個AI代理來執行。但任務越複雜,比如涉及數百個、上千個變數的財務分析,就需要大量AI代理來分工執行,這種多代理的管理、調度難度也就越高。

所以,AWS今年在既有的Bedrock Agent代理功能中,進一步新添多代理管理協作功能預覽版,使用者可用來建置、部署和管理多個AI代理,來共同執行複雜的多步驟任務,不必再寫複雜的程式碼。

GAI助理亮點1 協助IT現代化

AWS另一項AI主力產品,是去年新上線的生成式AI助理Amazon Q。這個助理分為Q Developer和Q Business兩種,分別能用AI代理,來處理程式開發和企業知識管理任務。

今年,這兩款助理各有重大突破,特別是Amazon Q Developer。

Matt Garman在大會上先賣關子,今年中,Amazon自己就用Q Developer來升級內部Java程式至Java 17,不只省下大把的人工轉換時間,還因為提早使用了現代化Java程式,進而省下年度2.6億美元的IT成本。

於是他們思考,Q Developer能否也加速其他IT現代化工作,而不只讓AI助理輔助簡單的程式開發任務。他們找上不少企業資訊長,詳談IT現代化痛點,最後鎖定3個領域,打造出Q Developer轉換新功能,來協助IT現代化。

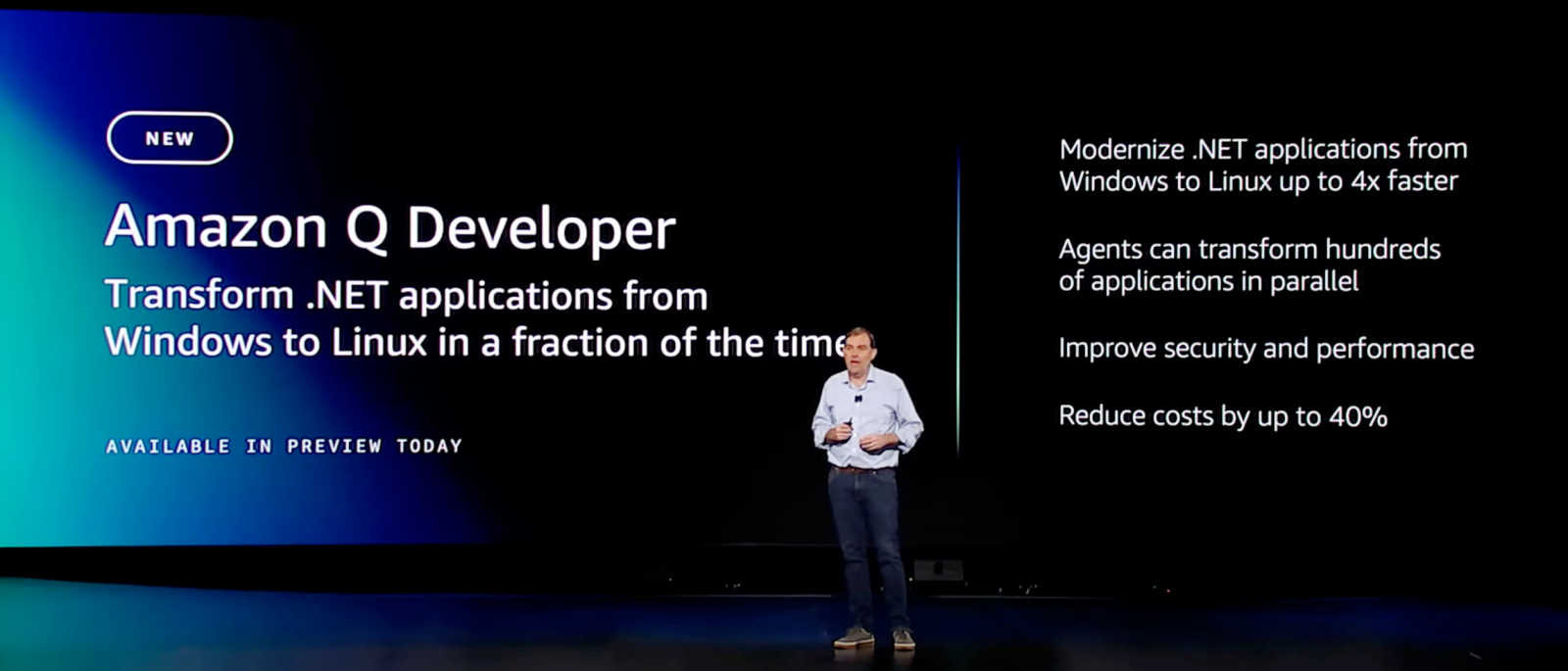

第一個轉換新功能是,將Windows.NET程式轉換為Linux作業系統相容的版本。為何這件事對企業很重要?

因為,Windows.NET是2002年推出、只在Windows作業系統執行,但不再積極更新的框架。而2016年,一款開源的跨平臺.NET框架出現了,可在Linux作業系統上執行,輕量且效能更好。它還會定期更新,每年都會釋出新功能和效能改進。

因此,將.NET應用程式從Windows轉換到Linux版本,不只能使用最新功能,還能減少微軟的授權費用支出。

而Q Developer的AI代理,會自動分析、找出不相容和效率低下的.NET程式碼,產出轉換計畫並執行,重寫有問題的原始程式碼。Q Developer的AI代理還能「同時處理數百甚至上千個應用程式,」Matt Garman強調,轉換時間能得到4倍加速,使用者還能省下40%的許可費用。

他甚至舉例,歐洲一家數位交易大廠Signaturit是這項功能的早期合作夥伴,他們原本打算用6到8個月,來將.NET程式轉換為Linux版本。但有了Q Developer的.NET轉換功能協助,短短幾天就完成了。

AWS另一款AI主力產品Amazon Q生成式AI助理,還可分為Developer和Business兩種。前者專門由AI代理執行程式開發相關任務,在今年新添了將Windows.NET轉換為Linux版本的現代化功能。

另一個新功能是將VMware虛擬機器工作負載轉換到Amazon EC2雲原生環境中。這個功能,由Q Developer的AI代理自動偵測程式相依性,評估狀況後會產出初始搬遷計畫,包含發現資料、應用程式分組、網路遷移和伺服器搬遷等步驟。

過程中,AI代理會將本地端的VMware配置轉換為AWS同等配置,並視情況動態調整搬遷計畫。相較於純人工轉換所需的幾個禮拜,Q Devloper幾個小時就能完成。

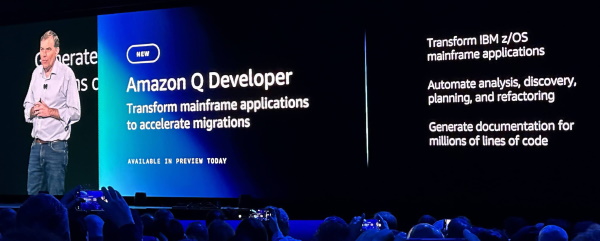

第三個新功能鎖定大型主機現代化。這是一個讓許多企業頭痛的大麻煩,Matt Garman直言,大型主機是目前為止最難搬遷上雲的複雜系統,甚至,當他與客戶企業討論時,「光是分析、記錄和規畫大型主機現代化,就要耗費大量精力,很多人因此放棄。」

於是,AWS看準這個痛點,推出Q Developer大型主機現代化轉換功能,來將老舊的大型主機COBOL程式碼轉換為Java,加速原本人工吃重的工作。首先,Q Developer的AI代理會自動分析程式碼,接著規畫現代化流程,將龐大的單體架構拆解為較小的業務領域,並重寫為Java程式碼。在這個過程中,AI代理還會針對COBOL程式碼,產出文件記錄,讓使用者知道程式碼的作用,有助於應用程式現代化的決策。

「很多企業客戶都認為,大型主機轉換至少要3到5年,」Matt Garman話鋒一轉:「根據早期客戶和內部測試,我們認為Q可以將多年的大型主機現代化工作,減少為多季度的工作,將轉換時間減少50%以上。」這是個非常可觀的加速。

另一項Amazon Q助理的新亮點是IT現代化,能自動分析大型主機程式碼,還能自動產出文件紀錄、生成轉換計畫並執行。根據AWS早期測試,可將數年的IT現代化工作縮短為幾個季度。攝影/王若樸

這些IT現代化功能,目前皆為預覽版。

除了協助IT現代化,AWS今年也替Q Developer增添其他功能,比如正式上線的3款AI代理功能,分別能自動產生和套用單元測試、產出準確的程式碼文件,以及自動進行程式碼檢查。又或是可自動偵測AWS環境問題的預覽版功能,使用者不必在不同的AWS監測工具中來回切換了。

GAI助理亮點2 整合更多資料和自動化

有別於程式開發,Amazon Q Business是一套企業知識管理GAI助理,能整合企業內部各類系統、AWS系統和第三方系統等40多個資料來源,來執行日常任務和資料查找等任務,也能像是商業智慧(BI)工具般,分析業務表現。就連Amazon自己的銷售團隊,也用Q Business來進行10萬多個帳號摘要。

在這個基礎上,為讓使用者更方便進行BI分析,AWS這次將自家BI工具Amazon QuickSight和Q Business助理整合,就算使用者用的是Q Business建立的應用程式,也能查看BI工具提供的視覺化圖表等內容。

不只是資料內容的整合,AWS還進一步擴大整合的資料來源範圍,使用者可授權獨立第三方廠商(ISV)的應用程式,透過API取用Amazon Q建立的索引(Index),來存取既有的其他應用程式資料,強化ISV應用程式的GAI體驗。

再來,Q Business本身就有一些可執行的「動作」(Action),來讓使用者在日常應用程式中採取,來簡化工作流程,比如在Jira中建立問題。現在,AWS擴大這個動作庫,新添了50多個動作,來簡化使用者操作第三方生產力應用程式的工作流程,比如可以自動化操作Google Workspace、微軟365、Smartsheet等程式。

甚至更進一步,AWS還為Q Business助理,新添了自動化執行複雜工作流程的功能,由AI代理分工執行,像是發票處理、管理用戶票證和新員工入職手續等工作。

SageMaker亮點1 更貼切的運算資源管理

另一方面,AWS發展多年的傳統AI平臺工具Amazon SageMaker,在今年大會中也有重大更新,首先是模型訓練的運算資源控管。受生成式AI影響,模型將越來越大,模型訓練的運算資源也需要更細緻的管控,因此AWS在全託管的AI開發部署和維運平臺Amazon SageMaker AI中,推出幾款新功能。

第一款是在其下的運算資源管理工具SageMaker HyperPod中,新添30款精心調整過的開源模型供存取。如此一來,使用者可在幾分鐘內快速使用Llama3.2 90B、Llama 3.1 405B和 Mistral 8x22B等熱門模型,降低入門門檻,不必耗費幾周的時間,來自己迭代測試、優化模型訓練效能。

另一款新功能是自動化彈性支援模型訓練的計畫功能(SageMaker Hyperpod Flexible Training Plans),能自動設置模型訓練所需的基礎設施和運算叢集,而且符合使用者預期的訓練時間和成本。

還有一款是任務治理新功能(SageMaker Hyperpod Task Governance),使用者能定義自己的優先任務,來最大化運用加速器運算資源,降低模型訓練、微調和推論的成本。

不只如此,AWS這次還進一步擴大SageMaker生態系,只要是AWS合作夥伴的AI應用程式,比如Comet、Deepchecks、Fiddler和Lakera Guard等,都能直接供使用者在SageMaker中直接使用這些程式,不必再將資料移出安全的 AWS環境,減少在不同介面間來回切換的時間成本。

SageMaker亮點2 整合工具新定位

AWS今年給予旗下AI開發部署平臺Amazon SageMaker新定位,集結AWS各種資料處理工具、分析工具和AI工具,成為一套統一的AI平臺。攝影/王若樸

另一方面,AWS發展多年的傳統AI平臺工具Amazon SageMaker,在今年年會中有了新定位,成為一套集結資料處理、分析應用和AI工具的統一大平臺。

Matt Garman點出,這個設計,是為了使用者能更好地打造AI分析應用,在單一平臺就能找到所需工具,不必在不同工具間來回切換。

在這個新定位下,首先亮相的新功能是Unified Studio統一工作室預覽版,整合了AWS自家多種工具,包括SQL分析(Amazon Redshift)、資料處理(Amazon EMR、AWS Glue和Amazon Athena)、機器學習(Amazon SageMakerAI)、串流(Amazon MSK、Amazon Kinesis)和商業智慧(Amazon QuickSight)等,甚至連主力的生成式AI平臺Amazon Bedrock,也納入其中,使用者在單一平臺就能存取,用來打造AI分析應用。

AWS對SageMaker的統一策略還不只這一個。他們還針對AI分析必不可缺的資料,進行整合,推出Amazon SageMaker Lakehouse資料湖倉,也就是一套能存取散落在各處的資料的統一平臺。

使用者可在平臺上,存取跨Amazon S3儲存服務、Amazon Redshift資料倉儲服務或其他來自上述Unified Studio平臺的資料。尤其,這個Amazon SageMaker Lakehouse還與Iceberg開源資料表格式相容,可打破數據孤島、讓資料更容易用於AI或ML分析。

當然,集結了這麼多資料來源和工具,也需要相對應的存取權限管理工具,來把關資料安全。因此,Matt Garman也在年會上揭露一款治理工具Amazon SageMaker Catalog,管理者可用來設定細緻的資料、模型等存取權限。

Amazon Nova六款基礎模型亮相

Amazon執行長Andy Jassy在今年度AWS re:Invent大會中,不僅揭露6款Nova系列模型,還透露明年要推出語音到語音、多模態到多模態等更強大的Nova模型。圖片來源/AWS

在今年度AWS re:Invent大會中,Amazon執行長Andy Jassy親自登場,揭露了6款自行研發的Nova系列基礎模型,包括Nova Micro、Nova Lite、Nova Pro、Nova Premier,以及用來生成高品質圖像的Nova Canvas和生成高品質影片的Nova Reel。

進一步來說,Nova Micro是一款只處理文字的模型,能以極低的延遲和成本給出回答。Andy Jassy說明,這款模型在11項基準測試中,表現媲美Meta的Llama 3.1 8B甚至更好。Nova Micro不只支援128K Token的輸入長度,每秒還可輸出210個Token,非常快速,適合需要迅速回應的應用場景。

再來,Nova Lite是一款多模態模型,主打快速處理圖像、影片和文字輸入。與OpenAI的GPT-4o mini相比,它在19項文字基準測試中,有17項表現持平或更好。

Nova Pro則是功能更強大的多模態模型,兼顧準確性、速度和成本,適合處理多種任務。至於Nova Premier,則是Amazon所謂的頂級多模態模型,專為複雜推論任務而生。

特別的是,Nova Micro、Lite和Pro等模型支援200多種語言,其中Nova Lite和Pro還支援300K Token的上下文長度,影片處理時長更能達到30分鐘。Andy Jassy預計,2025年初,Amazon將支援超過200萬Token的上下文長度。

目前,Nova Micro、Nova Lite和Nova Pro已在生成式AI平臺Amazon Bedrock上正式可用,Nova Premier預計在2025年第一季上架。

這些模型除了效能好,還很划算。AWS說明,Nova Micro、Lite和Pro在各自的類別中,使用成本比Amazon Bedrock中表現最佳的模型至少便宜75%,同時也是Amazon Bedrock中對應類別中,速度最快的模型。甚至,使用者還能客製化微調,或是使用蒸餾方法,來將大模型的知識快速轉移到小模型上,亦能採用RAG,來優化模型表現。

另一方面,Nova Canvas這款模型不只能根據輸入文字或圖像,產出高品質視覺內容,還提供編輯功能,使用者利用文字輸入,就能快速調整圖像、控制顏色組合和排版等。這款模型也提供浮水印功能,可追溯每張圖像的來源,還會審核內容,以防有害內容出現。

而Nova Reel除了可以文字生成高品質影片,一樣也能透過文字輸入,來控制視覺風格和節奏,像是鏡頭移動、旋轉和縮放等。

最後,Andy Jassy還透露重磅消息,Amazon預計在明年第一季推出Nova語音到語音模型,也就是能即時根據語音輸入,解釋語言和非語言訊號(如語調和節奏),來提供接近真人的即時語音互動。

再來,Amazon還在開發Nova多模態到多模態模型,也就是能接受文本、圖像、音訊和影片作為輸入,並以任意模態生成輸出,預計2025年中旬問世。他們認為,這種模型將能簡化應用程式開發,光靠同一模型就能執行多種任務,像是內容模態轉換、內容編輯,或是驅動能理解和生成所有模態的AI代理。

熱門新聞

2026-02-11

2026-02-09

2026-02-10

2026-02-11

2026-02-06

2026-02-10

2026-02-10

2026-02-10