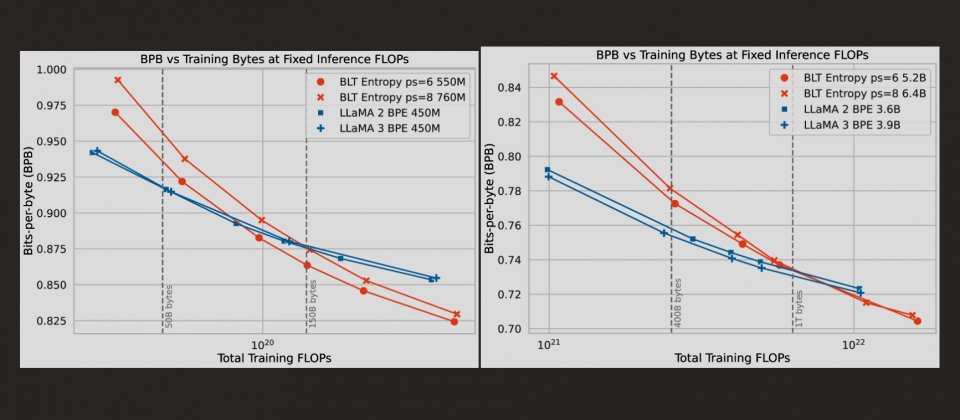

BLT模型在固定推理資源下,透過動態調整補釘(Patch)大小,同時擴展模型規模與效能,展現出比傳統分詞(Tokenization)模型更好的擴展性。實驗顯示,補釘大小為6和8的BLT模型,比Llama 2和3更快超越效能限制,特別是在高推理資源下優勢更明顯。

Meta新推出的BLT(Byte Latent Transformer)架構,重新定義了大型語言模型的運算方式,使得性能以及效率都超越目前主流的分詞(Tokenization)模型。該項新技術打破長期以來分詞模型在大型語言模型訓練中的限制,直接在位元組層級上進行運算,並展現出了在推理效能和模型強健性上的優勢。

分詞是大型語言模型的技術重點之一,分詞模型會將原始字串分解並壓縮成固定的字彙單元,以減少處理長序列的運算成本。但是這種方法的限制,隨著語言模型的發展日益明顯,首先,分詞過程中使用的壓縮演算法通常帶有語言和資料偏差,對非主流語言和多語言環境支援不足。其次是分詞模型對輸入雜訊的容忍度較低,特別是處理非正規語料時更容易出錯。此外,由於分詞具靜態性,無法根據資料密度靈活分配運算資源,導致資源的分配效率通常與資料的複雜度不一致。

為解決傳統分詞模型的限制,BLT架構直接從原始位元組資料中學習。這種架構不再仰賴固定的分詞單元,而是直接從原始位元組資料中學習,並透過動態分組機制,將位元組根據下一步預測的資料複雜度,分組為大小不一的補釘(Patch),低複雜度資料位元組可被合併成較長的補釘,減少需要處理的補釘數量,高複雜度資料補釘則被分割得更細,讓模型能專注於處理資訊密集的部分。

而這些補釘在保持資料完整性的同時,能有效提高模型對資訊密集區域的運算資源分配效率。在實際測試中,BLT展現出比Llama 3等分詞模型更高的推理效率,並能在相同的運算資源下同時擴大模型規模與補釘大小。

這種新的設計不僅提高模型的運算效率,也帶來了性能上的突破,Meta研究團隊表示,BLT模型在處理輸入雜訊時,比分詞模型更強健,並且在語言學上的細微特徵理解,像是字形結構和拼音規則等方面表現得更好。BLT也能克服低資源語言翻譯任務上的劣勢,進一步擴展應用場景。

BLT架構由三個核心模組構成,一個是輕量本地編碼器,負責將位元組轉換為補釘的表示形式,另一個是處理補釘的大型Latent Transformer,第三個模組則是將補釘轉回位元組的解碼器。這種設計讓BLT模型能夠根據資料需求靈活調整,大幅降低不必要的運算成本。實驗結果顯示,BLT的推理效率較傳統分詞模型提升達50%。

熱門新聞

2026-02-11

2026-02-11

2026-02-09

2026-02-10

2026-02-10

2026-02-06

2026-02-10

2026-02-10